声音里包含了丰富的信息,例如,听到“吱呀”的声音就知道门开了,听到“沙沙”的树叶声就知道起风了。依靠听觉,人类可以更好地感知世界。但对于机器人来说,目前它们只能基于视觉和少量的触觉进行操作。为了让机器人未来具备更好的感知力,科学家们正在研究如何赋予机器人听觉。

近日,卡内基梅隆大学(CMU)机器人研究所的研究人员对声音和机器人动作之间的相互作用进行了大规模的研究,发现声音可以帮助机器人区分物体,识别率能达到79.2%,还能识别使物体发出声音的动作,以及预测物体的物理属性。相关研究发表在《机器人技术:科学与系统》杂志上。

在此之前,没有任何算法,也没有数据集可以帮助机器人建立对物体的理解,形成机器人听觉。主要原因在于声音的产生受到许多因素的相互影响。例如,机器人撞击物体时发出的声音取决于撞击的力度、物体的结构、麦克风的位置等等。这使得从声音中提取对机器人有用的信息变得十分困难。

项目的研究人员之一莱雷尔·平托(Lerrel Pinto)说:“在其他领域的许多初步工作表明,声音可能有用,但尚不清楚它在机器人技术中有多有用。”

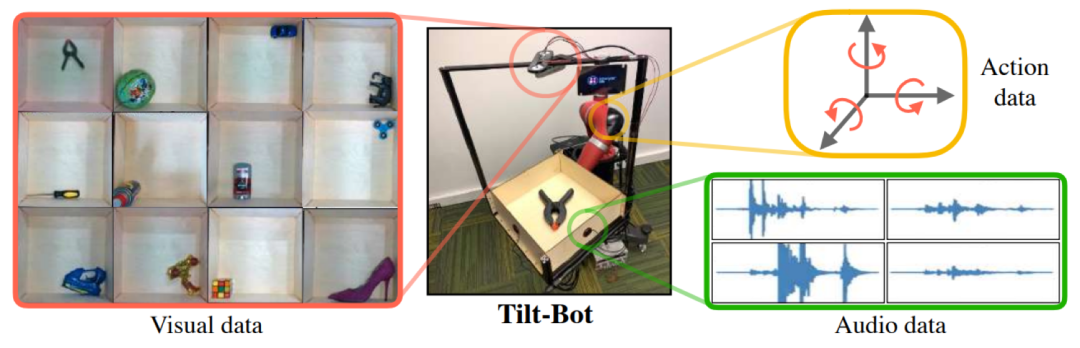

为了回答这一问题,研究人员首先创建了一个“倾斜机器人”(Tilt-Bot)。这个“倾斜机器人”由一个方形托盘、一个机械臂和固定装置组成。托盘的四周有挡板,挡板上贴着声波捕捉装置,托盘上方安装有一个摄像头。

研究人员将60种常见物体(例如苹果、鞋子和网球)分别放置在托盘上,随着机械臂向随机方向倾斜,物体会撞击挡板并发出声音。通过“倾斜机器人”,研究人员收集了60种物体的15000组交互记录,每组交互记录都包含声音、动作和视觉数据。

用于创建数据集的Tilt-Bot(中),可用于收集视觉(左)、声音(右下)和动作(右上)数据

利用Tilt-Bot收集的数据,研究人员得出了关于声音和机器人动作之间相互作用的三个发现。

首先,声音可以帮助机器人区分物体。通过建立学习模型,机器人可以通过声音区分60种不同的物体,而且识别准确率达到79.2%。

第二,声音还可以帮助机器人用于识别使物体发出声音的动作类型。通过建立模型,机器人只要一听到某一物体的声音,就能预测出使这个物体发出声音的动作,而且产生的误差比只用视觉信息进行识别的机器人低42%。

第三,仅通过一个物体发出的声音,机器人就能判断出这个物体的物理属性,而且产生的误差比仅用视觉进行判断产生的误差低了24%。也就是说,听觉比视觉更能捕捉物体的物理性质。

平托认为,机器人能利用声音提取信息并不奇怪,他说:“真正令人兴奋的是,我们预期它会失败时,它真的就失败了。”例如,机器人无法通过声音分辨红色和绿色之间的差异。“但是,如果是不同的物体,例如一个砖块和一个杯子,它可能会弄清楚。”

研究人员声称,这是关于声音和动作之间相互作用的首次大规模研究。他们将把Tilt-Bot数据集公开,为将来在机器人听觉领域的研究提供帮助,扩展声音在机器人中的使用范围。

平托补充说,我们的研究结果是如此令人鼓舞,以至于未来机器人将可能配备一根带工具的拐杖,只要用拐杖轻轻敲击,机器人就能识别出想要识别的物体。

-

机器人

+关注

关注

211文章

28379浏览量

206906 -

视觉

+关注

关注

1文章

147浏览量

23933 -

机械臂

+关注

关注

12文章

513浏览量

24552

原文标题:卡耐基梅隆大学设计的机器人能“听音识物”:准确率近八成

文章出处:【微信号:tjrobot,微信公众号:天津机器人】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

【「具身智能机器人系统」阅读体验】+初品的体验

西湖大学:科学家+AI,科研新范式的样本

【书籍评测活动NO.51】具身智能机器人系统 | 了解AI的下一个浪潮!

AI for Science:人工智能驱动科学创新》第4章-AI与生命科学读后感

英伟达预测机器人领域或迎“GPT-3时刻”

Jim Fan展望:机器人领域即将迎来GPT-3式突破

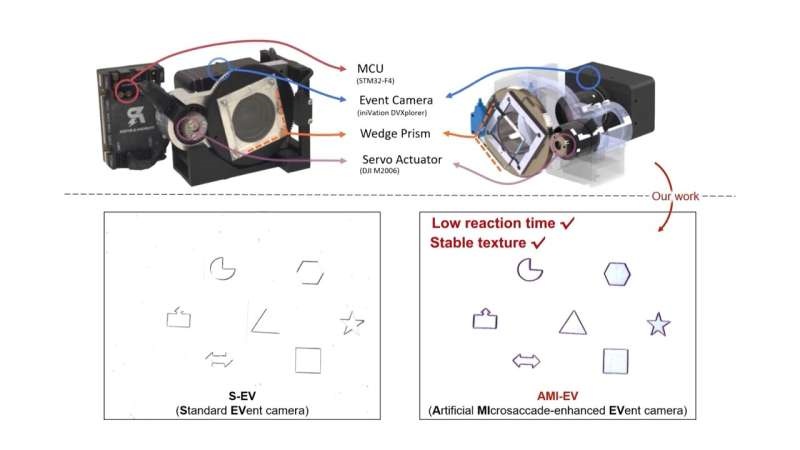

受人眼启发!科学家开发出新型改良相机

天津大学科学家突破人类大脑器官成功驱动机器人

前OpenAI首席科学家创办新的AI公司

视觉机器人焊接的研究现状

科学家们正在研究如何赋予机器人听觉

科学家们正在研究如何赋予机器人听觉

评论