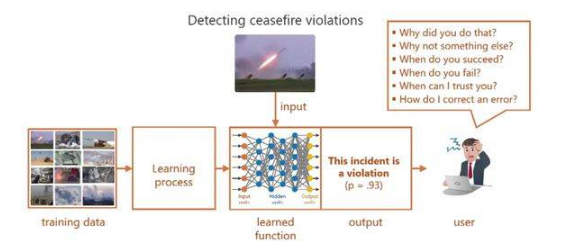

XAI主要解决以下问题:对于使用者而言某些机器学习模型如同黑盒一般,给它一个输入,决策出一个结果。比如大部分深度学习的模型,没人能确切知道它决策的依据以及决策是否可靠。如图 1 的 output 所示,为一般网络给出的决策,缺乏可解释性的结果让使用者感到困惑,严重限制了其在现实任务中的广泛应用。

图 1 如今的深度学习 [1]

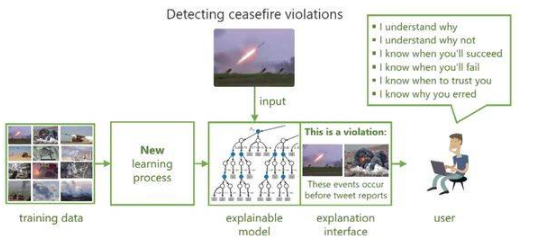

所以为了提高机器学习模型的可解释性和透明性,使用户和决策模型之间建立信任关系,近年来学术界进行了广泛和深入的研究并提出了可解释的机器学习模型。如图 2,模型在决策的同时给出相应的解释,以获得用户的信任和理解。

图 2 可解释的机器学习 [1]

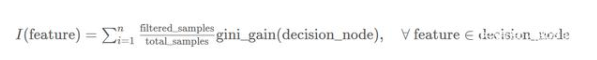

对于机器学习模型来说,我们常常会提到2个概念:模型准确性(accuracy)和模型复杂度(complexity)。模型的复杂度与准确性相关,又与模型的可解释性相对立。因此我们希望找到一种模型如图 3 所示,具有可解释性的同时尽可能保证模型的准确性和复杂度。

编辑:hfy

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表德赢Vwin官网 网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

- 机器学习

+关注

关注

66文章

8292浏览量

131602 - 深度学习

+关注

关注

73文章

5414浏览量

120394

发布评论请先登录

相关推荐

机器学习模型可解释性的结果分析

模型的

可解释性是

机器

学习领域的一个重要分支,随着 AI 应用范围的不断扩大,人们越来越不满足于

模型的黑盒特性,与此同时,金融、自动驾驶等领域

发表于09-28 10:17

•

791次阅读

什么是“可解释的”?可解释性AI不能解释什么

通过建立既

可解释又准确的

模型来改良这种错误的二分法。关键是将神经网络与决策树相结合,在使用神经网络进行低级决策时保留高级的

可解释性。

发表于05-31 10:51

•

8258次阅读

机器学习模型的“可解释性”的概念及其重要意义

如果考察某些类型的“事后

可解释性”(post-hoc interpretable),深度神经网络具有明显的优势。深度神经网络能够

学习丰富的表示,这些表示能够可视化、用语言表达或用于聚类。如果考虑对

可解释性的需求,似乎线性

Explainable AI旨在提高机器学习模型的可解释性

Google Cloud AI战略总监Tracy Frey在 今天的博客中

解释说,Explainable AI旨在提高

机器

学习

模型的

可解释性

机器学习模型可解释性的介绍

模型

可解释性方面的研究,在近两年的科研会议上成为关注热点,因为大家不仅仅满足于

模型的效果,更对

模型效果的原因产生更多的思考,这...

图神经网络的解释性综述

:https://arxiv.org/pdf/2012.15445.pdf 参考文献 0.Abstract近年来,深度

学习

模型的

可解释性研究在图像和文本领域取得了显著进展

使用RAPIDS加速实现SHAP的模型可解释性

模型

解释性帮助开发人员和其他利益相关者理解

模型特征和决策的根本原因,从而使流程更加

透明。能够

解释

模

人工智能可解释性规制面临的问题分析

在实践中,人工智能的规模化应用推广,在很大程度上依赖于用户能否充分理解、合理信任并且有效管理人工智能这一新型伙伴。为此,确保人工智能产品、服务和系统具有

透明性(Transparency)与

可解释性(Explainability)是至关重要的。

浅谈机器学习模型的可解释性和透明性

浅谈机器学习模型的可解释性和透明性

评论