鞭牛士BiaNews消息:安全人员曾为某著名车企自动驾驶系统做过一次安全测试,用物理对抗攻击欺骗Autopilot车道检测系统,导致汽车在Autopilot不发出警告的情况下驶入错误车道。假如这是一场真实的攻击,后果不堪设想。事实上,AI系统如果没有足够的“免疫力”,甚至会被一张图片欺骗,如将停车标志识别为通行,在医疗应用中将有问题的医疗影像识别为正常图像等。

为帮助AI应用从源头构建安全性,阿里安全图灵实验室整理归纳了学界针对AI模型提出的32种攻击方法,以此为基础搭建了一个自动化AI对抗攻击平台CAA,帮助检测AI系统存在的安全漏洞。

经CAA“体检”后,AI安全专家可针对被检测AI的薄弱地带提出安全建议,助力AI鲁棒性(稳定性)检测,以此增强AI系统的安全性,近日,该研究成果被人工智能顶会AAAI2021接收。

相比业界此前提出的其他攻击工具箱,阿里图灵实验室研发的自动化对抗攻击平台CAA首度实现了对抗攻击的“工具化”。它让AI应用的使用者即使不具备任何专业领域知识的情况下,也可以进行AI模型的对抗攻击和鲁棒性测试。

此外,CAA还可预先评估待检测AI的特性,通过自动化搜索技术来合成多个攻击算法的组合,提升了现有模型攻击方法的性能和效率。阿里安全专家通过实验表明,CAA超越了最新提出的攻击方法,是可有效评估当前AI系统安全性的最强“攻击”。

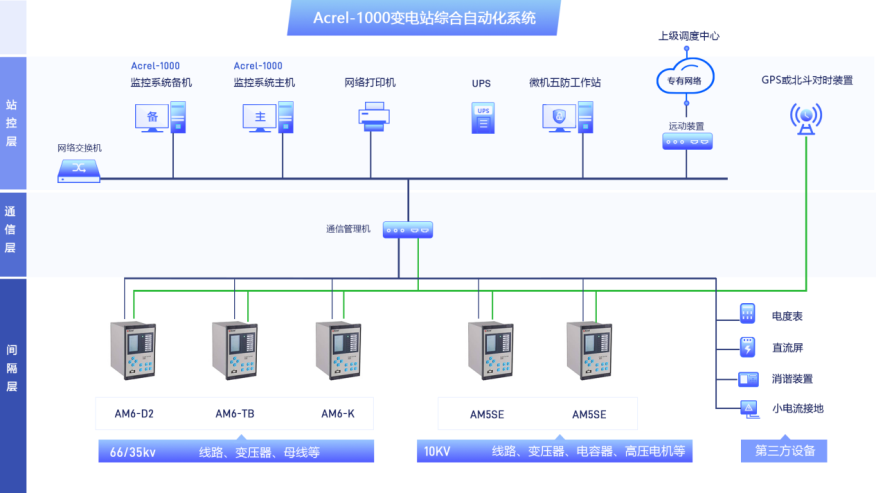

图示:阿里安全提出的自动化对抗攻击平台CAA运行示意图

以事前“攻击演练”检测AI系统的安全性,是当前提升安全AI的有效方法,也是阿里提出新一代安全架构,从源头构建安全的核心理念。但如果不知道目标模型的防御细节,研究者通常很难根据经验选择到对当前模型最优的攻击算法,从而难以验证“体检”的真实效果。

阿里安全图灵实验室算法专家箫疯表示,阿里安全首次提出将智能技术引入到对抗攻击中,使得所有攻击细节和参数作为一个黑箱,而攻击者只需要提供目标模型和数据,算法就会自动选择最优的攻击组合和参数。

以AI体检AI,以AI训练AI。萧疯认为,对识别黄、赌、毒等不良内容的安全检测AI而言,模型可靠性和鲁棒性显得尤为重要。目前,在鉴黄算法上,图灵实验室正在借此技术方法提升曝光、模糊、低画质等极端分类场景下的模型识别能力,并且逐渐提升模型在极端场景下的鲁棒性,为业界提供更安全可靠的AI算法能力。

责任编辑:PSY

-

AI

+关注

关注

87文章

30728浏览量

268880 -

自动化

+关注

关注

29文章

5562浏览量

79239 -

抗攻击

+关注

关注

0文章

3浏览量

6368 -

阿里

+关注

关注

6文章

438浏览量

32828

发布评论请先 登录

相关推荐

自动化水厂监控系统

罗克韦尔自动化推出Logix SIS,开拓安全新格局

自动化AI开发平台功能介绍

AI即服务平台的安全性分析

高速公路自动化安全监测预警系统解决方案

机械自动化是自动化的一种吗

工业自动化和控制系统网络安全的关系

英国AI安全研究所推出AI模型安全评估平台

水利闸门自动化控制系统简介及构成

阿里安全提出的自动化对抗攻击平台CAA,给AI系统做“安全体检”

阿里安全提出的自动化对抗攻击平台CAA,给AI系统做“安全体检”

评论