近期外网爆出传闻,AMD下一代Zen 4核心的EPYC Genoa处理器可能会配备HBM内容,以求与英特尔的下一代服务器CPU Xeon Sapphire Rapids争雄。巧合的是,近日Linux内核补丁中也透露了消息,AMD下一代基于CDNA 2核心的Instinct MI200 GPU也将用到HBM2e,显存更是高达128GB。这意味着AMD很可能会在服务器市场全面拥抱HBM。

已与消费显卡市场无缘的HBM

HBM作为一种高带宽存储器,其实是由AMD最先投入研发的高性能DRAM。为了实现这一愿景,AMD找来了有3D堆叠工艺生产经验的SK海力士,并借助互联和封装厂商的帮助,联合开发出了HBM存储器。

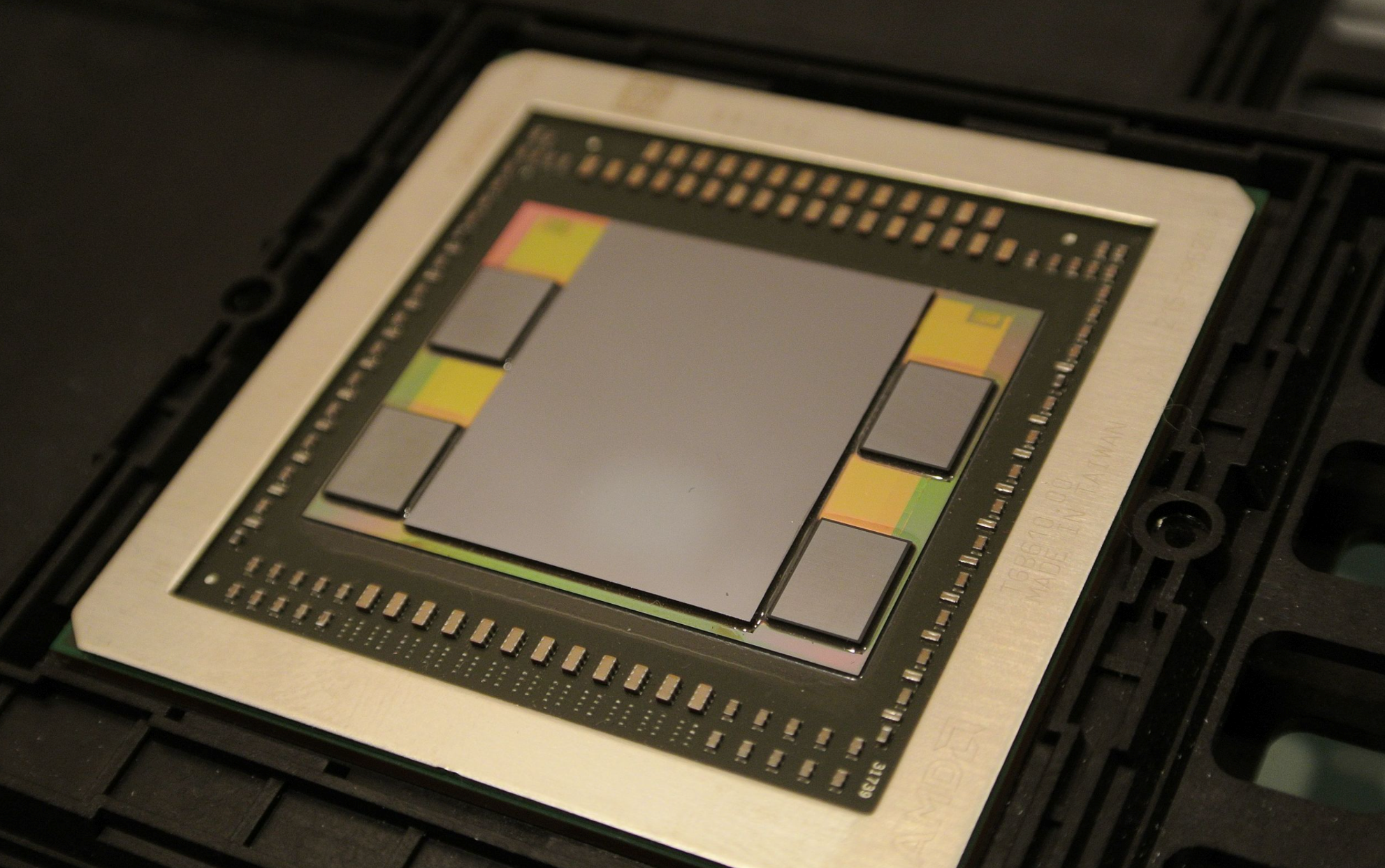

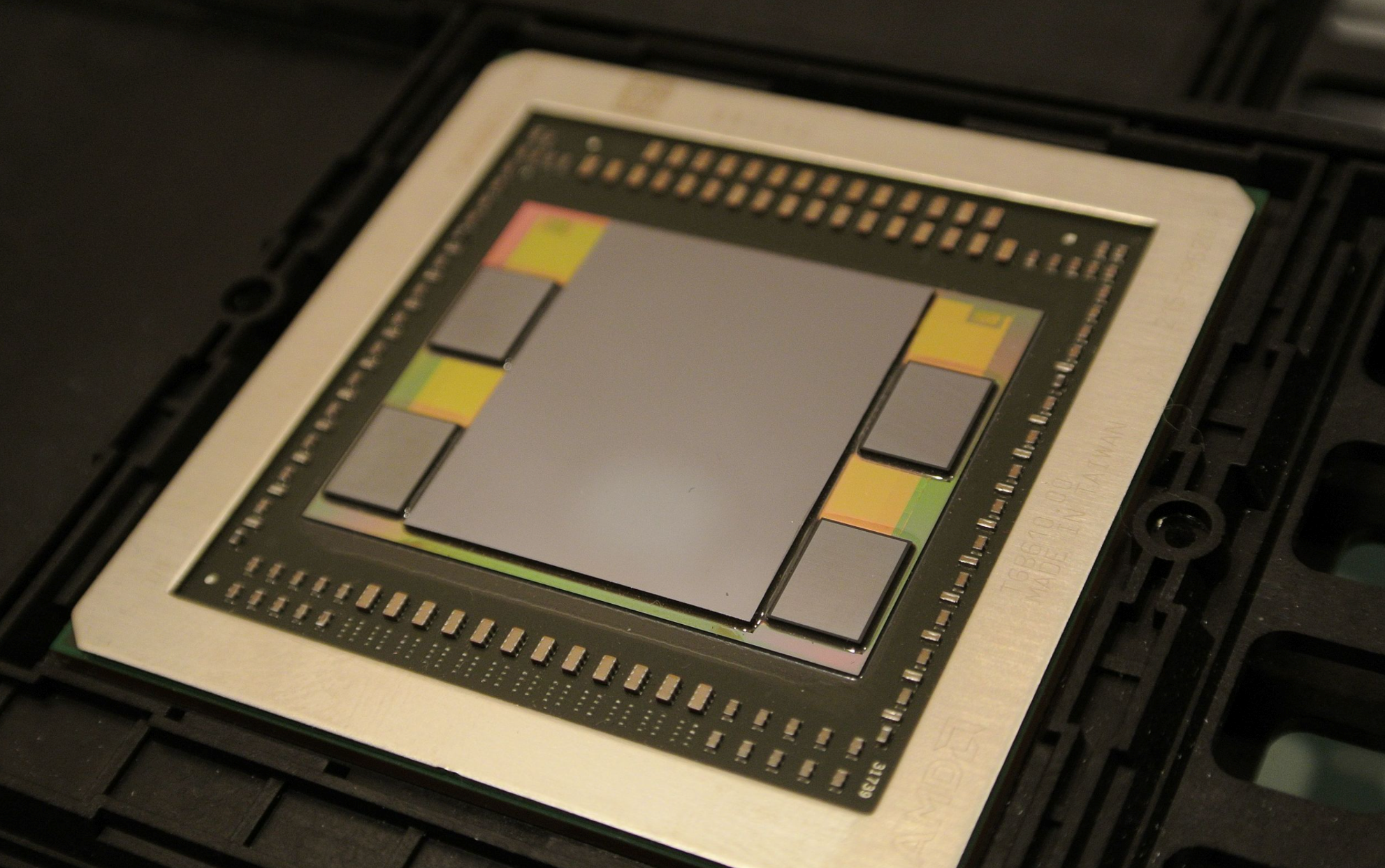

AMD也是首个将其引入GPU市场的厂商,并应用在其Fiji GPU上。随后2016年,三星率先开始了HBM2的量产,AMD被英伟达抢了风头,后者率先将这一新标准的存储器应用在其Tesla P100加速卡上。

当时HBM的优缺点都十分明显了,从一开始以来的带宽优势正在被GDDR6迎头赶上,设计难度和成本又是一道难以迈过的坎。虽然高端显卡上这些成本并不占大头,但中低端显卡用到HBM就比较肉疼了。但AMD并没有因此放弃HBM2,而是在Vega显卡上继续引入了HBM2。

不过,这可能也就是我们最后一次在消费级GPU上见到HBM了,AMD在之后的RDNA架构上再也没有使用HBM,仅仅只有基于CDNA架构且用于加速器的GPU上还在使用HBM。

为什么是服务器市场?

HBM是如何在服务器市场扎根的呢?这是因为HBM最适合的应用场景之一就是功率受限又需要最大带宽的环境,完美达到HPC集群中进行人工智能计算,或是大型密集计算的数据中心的要求。

这也就是这些包含数据中心业务的公司持续使用HBM的原因,英伟达在性能强大的服务器GPU A100中依然在使用HBM2和HBM2e,甚至可能会在下一代Hopper结构继续沿用下去。据传,英特尔尚未面世的Xe-HP和Xe-HPC GPU也将使用HBM。

不过这两家厂商的消费级GPU都不约而同的避过了HBM,选择了GDDR6和GDDR6X,可想而知他们都不想走AMD的弯路。

至于AMD在CPU上率先使用HBM也并非空穴来风,在AMD去年公布的一份专利中,就在芯片设计上出现了HBM。英特尔推出的竞品Xeon Sapphire Rapids服务器CPU也正式宣布将使用HBM,不过量产要等到2023年。这些可以看出HBM在服务器市场有多“香”,他们都开始将HBM向CPU上发展。

下一代HBM

虽然制定标准的JEDEC尚未推出HBM3的相关规范,但一直在研究下一代HBM的SK海力士在今年6月透露了HBM3的最新情报,HBM将迎来进一步的性能提升。

HBM2E的带宽可达460GB/s,I/O速率可达3.6Gbps,而HBM3的带宽可以达到665GB/s以上,I/O速率超过5.2Gbps。这还是只是速率的下限而已,要知道SiFive与OpenFive今年流片的5nm RISC-V SoC也加入了HBM3的IP,最高支持的数据传输率达到7.2Gbps。

SK海力士能做到如此高的性能提升,很可能得益于去年与Xperi签订的专利许可协议。这些协议中包含了DBI Ultra 2.5D/3D互联技术,可以用于3DS、HBM2、HBM3及后续DRAM产品的创新开发。传统的铜柱互联只能做到每平方毫米625个互联,而DBI Ultra可以在同样的面积下做到10万个互联。

结语

从JEDEC2018年宣布HBM2E标准以来,HBM已经近3年没有更新了。三星更是在今年2月宣布开发带有人工智能引擎的HBM-PIM,未来HBM3是否能在服务器领域继续称雄,相信当前几大厂商规划的服务器产品中HBM占比已经给出了答案。

已与消费显卡市场无缘的HBM

HBM作为一种高带宽存储器,其实是由AMD最先投入研发的高性能DRAM。为了实现这一愿景,AMD找来了有3D堆叠工艺生产经验的SK海力士,并借助互联和封装厂商的帮助,联合开发出了HBM存储器。

Fiji GPU / AMD

AMD也是首个将其引入GPU市场的厂商,并应用在其Fiji GPU上。随后2016年,三星率先开始了HBM2的量产,AMD被英伟达抢了风头,后者率先将这一新标准的存储器应用在其Tesla P100加速卡上。

当时HBM的优缺点都十分明显了,从一开始以来的带宽优势正在被GDDR6迎头赶上,设计难度和成本又是一道难以迈过的坎。虽然高端显卡上这些成本并不占大头,但中低端显卡用到HBM就比较肉疼了。但AMD并没有因此放弃HBM2,而是在Vega显卡上继续引入了HBM2。

不过,这可能也就是我们最后一次在消费级GPU上见到HBM了,AMD在之后的RDNA架构上再也没有使用HBM,仅仅只有基于CDNA架构且用于加速器的GPU上还在使用HBM。

为什么是服务器市场?

HBM是如何在服务器市场扎根的呢?这是因为HBM最适合的应用场景之一就是功率受限又需要最大带宽的环境,完美达到HPC集群中进行人工智能计算,或是大型密集计算的数据中心的要求。

A100不同规格的显存对比 / Nvidia

这也就是这些包含数据中心业务的公司持续使用HBM的原因,英伟达在性能强大的服务器GPU A100中依然在使用HBM2和HBM2e,甚至可能会在下一代Hopper结构继续沿用下去。据传,英特尔尚未面世的Xe-HP和Xe-HPC GPU也将使用HBM。

不过这两家厂商的消费级GPU都不约而同的避过了HBM,选择了GDDR6和GDDR6X,可想而知他们都不想走AMD的弯路。

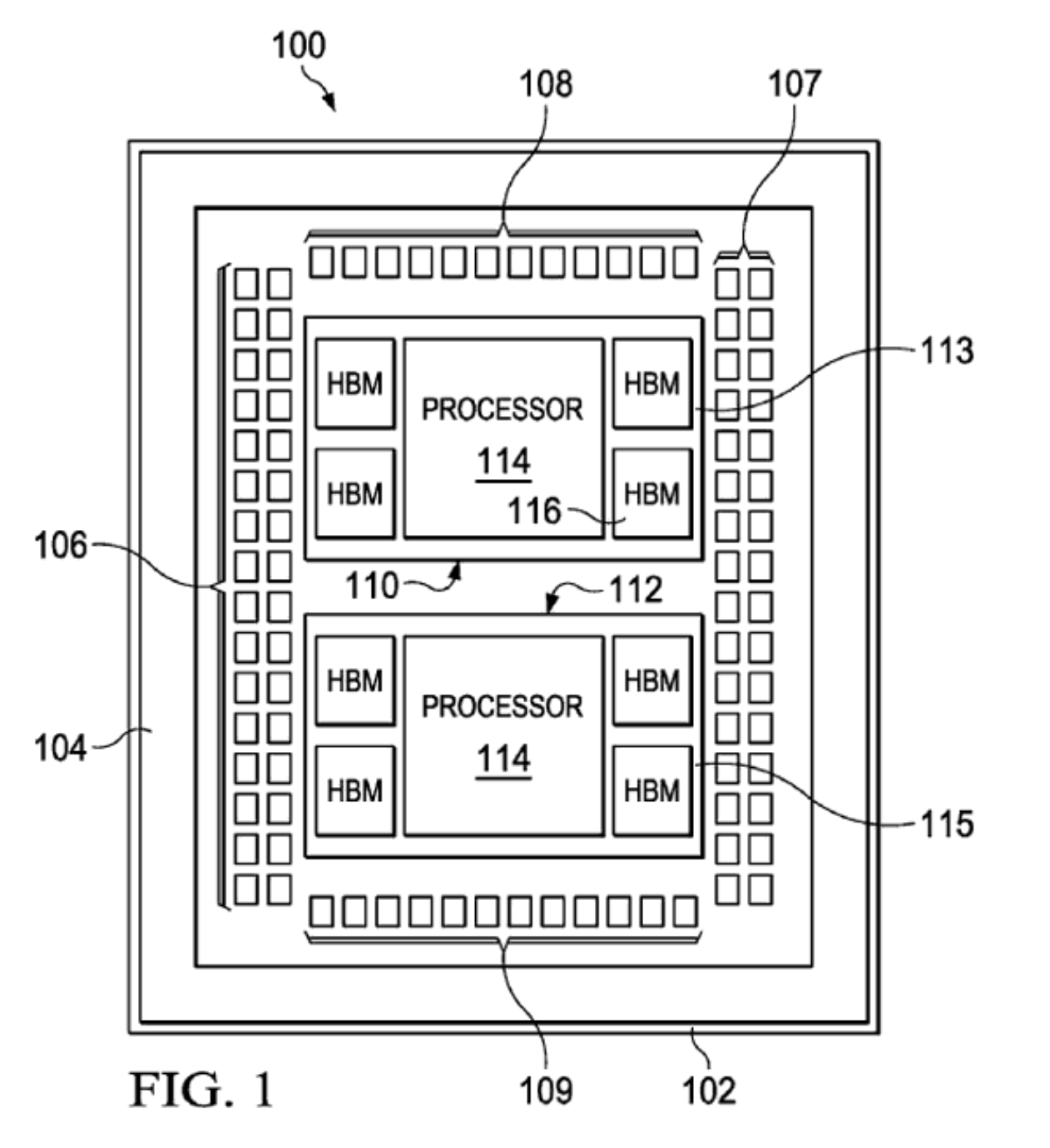

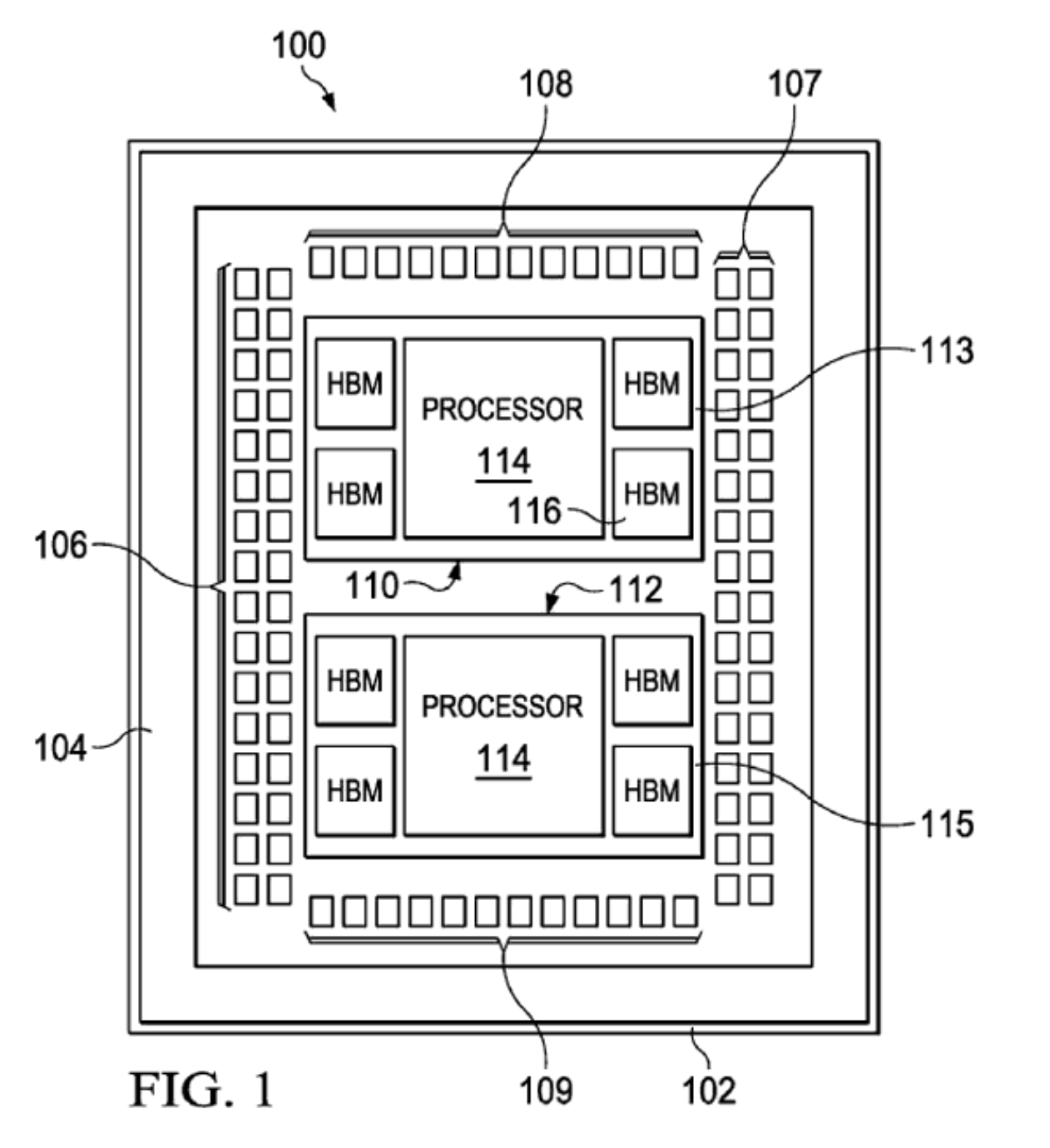

AMD专利 / AMD

至于AMD在CPU上率先使用HBM也并非空穴来风,在AMD去年公布的一份专利中,就在芯片设计上出现了HBM。英特尔推出的竞品Xeon Sapphire Rapids服务器CPU也正式宣布将使用HBM,不过量产要等到2023年。这些可以看出HBM在服务器市场有多“香”,他们都开始将HBM向CPU上发展。

下一代HBM

虽然制定标准的JEDEC尚未推出HBM3的相关规范,但一直在研究下一代HBM的SK海力士在今年6月透露了HBM3的最新情报,HBM将迎来进一步的性能提升。

HBM2E和HBM3性能对比 / SK海力士

HBM2E的带宽可达460GB/s,I/O速率可达3.6Gbps,而HBM3的带宽可以达到665GB/s以上,I/O速率超过5.2Gbps。这还是只是速率的下限而已,要知道SiFive与OpenFive今年流片的5nm RISC-V SoC也加入了HBM3的IP,最高支持的数据传输率达到7.2Gbps。

SK海力士能做到如此高的性能提升,很可能得益于去年与Xperi签订的专利许可协议。这些协议中包含了DBI Ultra 2.5D/3D互联技术,可以用于3DS、HBM2、HBM3及后续DRAM产品的创新开发。传统的铜柱互联只能做到每平方毫米625个互联,而DBI Ultra可以在同样的面积下做到10万个互联。

结语

从JEDEC2018年宣布HBM2E标准以来,HBM已经近3年没有更新了。三星更是在今年2月宣布开发带有人工智能引擎的HBM-PIM,未来HBM3是否能在服务器领域继续称雄,相信当前几大厂商规划的服务器产品中HBM占比已经给出了答案。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表德赢Vwin官网

网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

amd

+关注

关注

25文章

5466浏览量

134080 -

cpu

+关注

关注

68文章

10854浏览量

211565 -

gpu

+关注

关注

28文章

4729浏览量

128886

发布评论请先 登录

相关推荐

《CST Studio Suite 2024 GPU加速计算指南》

的各个方面,包括硬件支持、操作系统支持、许可证、GPU计算的启用、NVIDIA和AMD GPU的详细信息以及相关的使用指南和故障排除等内容。

1. 硬件支持

- NVIDIA GPU

发表于 12-16 14:25

AMD与NVIDIA GPU优缺点

在图形处理单元(GPU)市场,AMD和NVIDIA是两大主要的竞争者,它们各自推出的产品在性能、功耗、价格等方面都有着不同的特点和优势。 一、性能 GPU的性能是用户最关心的指标之一。在高端市场

X-Silicon发布RISC-V新架构 实现CPU/GPU一体化

X-Silicon 的芯片与其他架构不同,其设计将 CPU 和 GPU 的功能整合到单核架构中。这与英特尔和 AMD 的典型设计不同,前者有独立的

发表于 04-08 11:34

•578次阅读

RISC-V芯片新突破:CPU与GPU一体化核心设计

X-Silicon 的芯片与其他架构不同,其设计将 CPU 和 GPU 的功能结合到单核架构中。这与 Intel 和 AMD 的典型设计不同,后者有独立的

发表于 04-07 10:41

•727次阅读

FPGA在深度学习应用中或将取代GPU

业可行性方面考虑,自动驾驶汽车等应用可能需要多达 7-10 个 GPU(其中大多数会在不到四年的时间内失效),对于大多数购车者来说,智能或自动驾驶汽车的成本将变得不切实际。”

机器人、医疗保健和安全

发表于 03-21 15:19

四川长虹回应帮华为代工 HBM芯片备受关注

的CPU/GPU内存芯片因为AI而全面爆发,多家存储企业的产能都已经跟不上。HBM英文全称High Bandwidth Memory,翻译过来即是高带宽内存,

英伟达B100 GPU架构披露,B200或配备288GB显存

XpeaGPU透露,B100 GPU将配备两枚基于此技术的芯片,与此同时,还将连通多达8个HBM3e显存堆栈,总容量高达192GB。AMD同样已有提供同量级的产品,并且在Instinc

AMD Instinct MI300新版将采用HBM3e内存,竞争英伟达B100

AMD于去年宣布旗下两款Instinct MI300加速器,包括基于GPU的MI300X以及基于APU架构的MI300A, both配备192GB/128GB的HBM3内存,还流传着一款纯粹的

gpu是什么和cpu的区别

GPU和CPU是两种常见的计算机处理器,它们在结构和功能上有很大的区别。在这篇文章中,我们将探讨GPU和CPU的区别,并详细介绍它们的原理、

AMD将推新GPU,效能媲美英伟达RTX 4080

据悉,AMD正努力研制新品级GPU,性能堪比英伟达的RTX 4080,而售价却只有后者的一半。据多个在线社区反映,AMD即将发布的Radeon RX 8000系列GPU效能与NVIDI

CPU与GPU散热器设计的异同及其重要性

计算机的稳定和性能不受影响,散热器成为了必要的组件。本文将详述CPU和GPU散热器的设计异同以及其重要性。 一、设计异同 1. 散热原理: CPU和

AMD或将全面拥抱HBM,CPU和GPU都要用?

AMD或将全面拥抱HBM,CPU和GPU都要用?

评论