介绍了数据中心网络对于算力的意义,归纳出影响数据中心全以太化演进的因素,以及超融合数据中心网络架构的典型特征与价值。

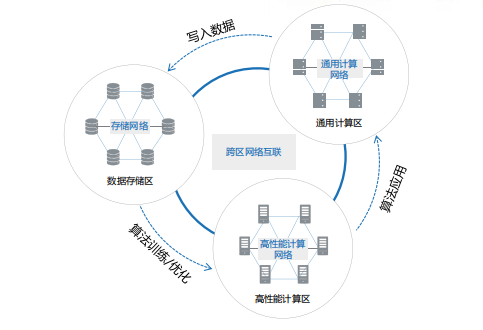

结合业界在超融合数据中心网络技术中的实践与探索,对超融合数据中心网络架构的未来发展进行了展望。数据中心内数据处理包括数据的存储、计算和应用三个环节,分别对应三大资源区:

数据存储区:存储服务器内置不同的存储介质,如机械硬盘、闪存盘(SSD)、蓝光等,对于数据进行存储、读写与备份,存储节点间通过存储网络互联。

高性能计算区:服务器较少虚拟化,配置CPU、GPU 等计算单元进行高性能计算或 AI 训练,服务器节点间通过高性能计算网络互联。

通用计算区:服务器大量使用 VM或容器等虚拟化技术,通过通用计算网络(又称为应用网络、业务网络、前端网络),与外部用户终端对接提供服务。

在这个持续循环的过程中,网络就像联接计算和存储资源的中枢神经,贯穿数据处理的全生命周期。数据中心算力水平不仅取决于计算服务器和存储服务器的性能,很大程度上也受到网络性能的影响。如果网络算力水平无法满足要求,则会引发“木桶效应”拉低整个数据中心的实际算力水平。

数据中心算力是数据中心的服务器通过对数据进行处理后实现结果输出的一种能力。在服务器主板上,数据传输的顺序依次为 CPU、内存、硬盘和网卡,若针对图形则需要 GPU。所以,从广义上讲,数据中心算力是一个包含计算、存储、传输(网络)等多个内涵的综合概念,是衡量数据中心计算能力的一个综合指标。

提升网络性能可显著改进数据中心算力能效比

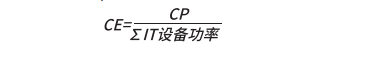

定 义 数 据 中 心 算 效(CE,Computational Efficiency)为数据中心算力与所有 IT 设备功耗的比值,即“数据中心 IT 设备每瓦功耗所产生的算力”(单位:FLOPS/W):

在服务器规模不变的情况下,提升网络能力可显著改善数据中心单位能耗下的算力水平。ODCC2019 年针对基于以太的网算一体交换机的测试数据表明,在 HPC场景同等服务器规模下,相对于传统 RoCE(基于融合以太的远程内存直接访问协议)网络,网算一体技术可大幅度降低HPC 的任务完成时间,平均降幅超过 20%。即:单位时间提供的算力提升 20%,同等算力下能耗成本降低 20%。

在存储网络场景,采用基于 NVMeover Fabric 的无损以太网络,可实现同等服务器规模 下, 存 储 IOPS性能相对于传统 FC网络最高可提升87%,这也将大幅减少业务端到端运行时长。由此可见,重构数据中心网络可以实现在单位ICT 能耗下对算力的极大提升,更好满足绿色节能数据中心的建设要求。在大算力需求持续高涨的情况下,为企业带来更加直接的价值。

存储全闪存化驱动 RoCE 产业生态发展

相比 HDD,SSD 介质在短时间内将存储性能提升了近 100 倍,实现了跨越式的发展,而 FC 网络技术无论是从带宽或时延已成为存储网络场景的系统瓶颈,存储业务开始呼唤更快、更高质量的网络。为此,存储与网络从架构和协议层进行了深度重构,NVMeoverFabric 应运而生。

在新一代存储网络技术的选择上,业界存在NVMeoverFC、NVMeoverRoCE等多条路径。然而,FC 网络始终无法突破三大挑战:

第一、FC 网络技术及互通性相对封闭,整体产业生态与连续性面临着很大挑战;

第二、由于产业规模受限,FC 技术的发展相对迟缓,目前最大带宽只有 32G 且已长达 6 年没有出现跨代式技术;

第三、同样由于产业规模受限,FC 网络运维人员稀缺,能够运维 FC 网络的技术人员不足以太网络维护人员的 1/10。这造成 FC网络运维成本居高不下,故障解决效率低下。

相比FC网络,NVMeoverRoCE 技术无论从产业规模、技术活跃度、架构扩展性、开放生态、和多年 SDN(Software-DefinedNetwork,软件定义网络)管理运维能力积累上都具有明显的优势,已成为下一代存储网络技术的最优选择。

CPU/GPU 去PCIe化,直出以太以获取极致性能

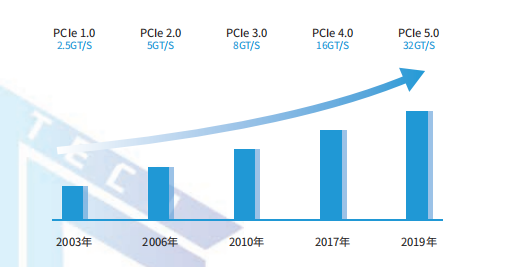

随着人工智能技术的快速发展,PCIe 总线瓶颈凸显。PCIe 是英特尔在 2001 年提出的高速串行计算机扩展总线标准,接口速度决定了 CPU 间的通信速度,而接口数量则决定了主板的扩展性。

当前,占据数据中心服务器 CPU 市场绝对地位的 Intelx86 架构普遍使用 PCIe3.0,PCIe3.0 单通道仅支持 8GT/s 的传输速率,且通道扩展数量有限。在 AI 超算服务器已经全面迈入 100GE 网卡的时代,PCIe3.0 架构速率成为大吞吐高性能计算场景下的性能瓶颈。

为此,业界开始探索计算单元去 PCIe 之路。2019 年,Habana 公司发布了在 AI 芯片处理器片内集成 RoCE 以太端口的处理器 Gaudi,Gaudi 将10 个基于融合以太网的 RoCE-RDMA100GE 端口集成到处理器芯片中,每个以太网端口均支持 RoCE功能,从而让 AI 系统通过标准以太网,在速度和端口数方面获得了几乎无限的可扩展性,提供了过去的芯片无法实现的可扩展能力。同年,华为的达芬奇芯片昇腾 910 集成了 RoCE 接口,通过片内RoCE 实现节点间直接互联,为构建横向扩展(ScaleOut)和纵向扩展(ScaleUp)系统提供了灵活高效的方法。

IPv6 大规模部署,产业政策加速以太化进程

IPv6 即互联网协议第6版,是互联网工程任务组设计的用于替代 IPv4 的下一代 IP 协议。IPv6 不仅能解决网络地址资源数量的问题,而且还解决了多种接入设备连入互联网的障碍问题,具有更大的地址空间和更高的安全性。从人人互联到万物智联,网络对 IP 地址的需求量指数级增加;数据中心作为智能世界的算力中枢,IPv6 成为互联的基础诉求。

超融合数据中心网络架构与核心特征

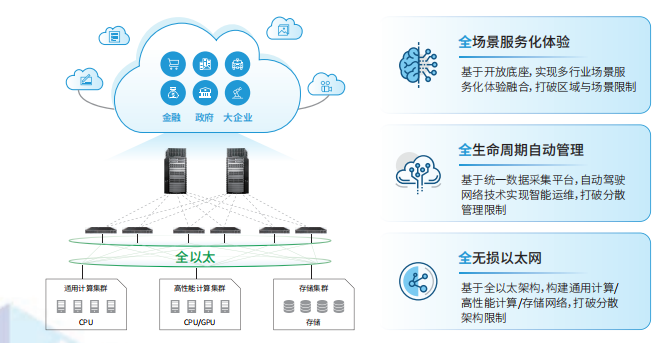

下一代超融合数据中心网络需具备如下特征,实现三个层面的融合:

• 全无损以太网络,实现流量承载融合:通用计算、存储、高性能计算网络统一承载在 0 丢包以太网技术栈上,实现大规模组网协议统一,TCP、RoCE 数据混流运行,打破传统分散架构限制;

• 全生命周期自动管理,实现管控析融合:基于统一网络数字孪生底座,加以大数据及 AI 手段,实现规划、建设、维护、优化全生命周期自动化,代替人工处理大量重复性、复杂性的操作,并可基于海量数据提升网络预测和预防能力,打破多工具多平台分散管理限制;

• 全场景服务化能力,实现全场景融合:抽象数据中心网络“物理网络服务”、“逻辑网络服务”、“应用服务”、“互联服务”、“网络安全服务”、“分析服务”等核心服务能力,基于开放服务化架构实现多厂家、离线与在线数据的灵活接入。满足多私有云、多公有云、混合云、以及丰富行业场景下的网络统一编排需求,支持算力跨云灵活智能调度,打破区域与场景限制。

超融合数据中心网络技术最佳实践

基于全无损以太的超融合数据中心网络技术正在迅猛发展,在存储、高性能计算、通用计算等场景得到了较好地商业实践。

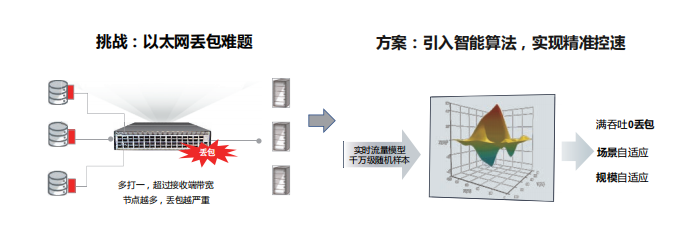

在无损网络方向,标准以太网络虽然有 QoS 以及流量控制能力,但执行机制简单粗暴,通常通过静态水线控制。静态水线无法适应千变万化的存储业务流量,设置过高可能引发丢包,设置过低则无法充分释放存储的 IOPS 性能。为了解决这个难题,业界将 AI 机制引入到交换机中,一方面交换机可毫秒级感知流量变化,另一方面基于海量存储流量样本持续训练获得的 AI 算法可通过智能动态调整队列水线实现亚秒级流量精准控制,最大程度释放存储性能。

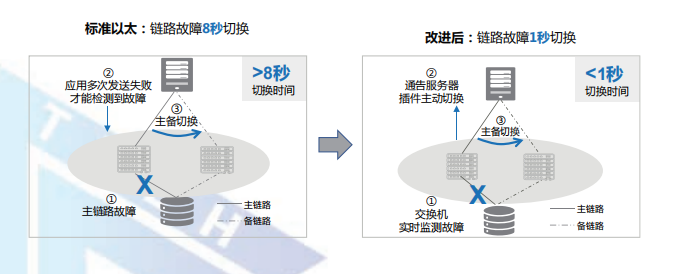

在可靠性方面,业界正在推动网络与存储在故障场景下的联动标准化方案。通过交换机毫秒级主动通告故障,并联动存储协同倒换,可支持亚秒级的网络故障倒换,真正实现网络单点故障存储业务无感知。

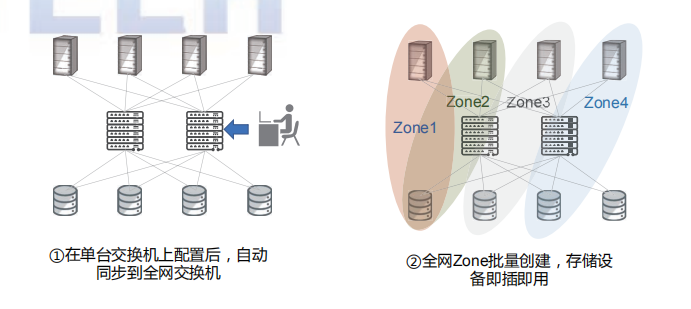

在网络易用性与运维方面,业界发布了以太网络环境下的存储即插即用最佳实践,相比传统以太逐节点、逐 ZONE 手工配置方式,可以做到业务单点配置、全网同步,实现存储设备的即插即用。

由于传统 FC 网络当前主流商用端口带宽只有8G,最大端口带宽只有 32G,同城 100G 存储传输往往需要 4~10 条以上的链路。相比之下,以太网络 100G/400G 接口能力已经成熟商用,可以大幅减少同城链路资源。然而,在同城双活及灾备场景中,跨城传输时延增大,短距流控反压机制存在严重的滞后性。以同城 70 公里传输场景为例,RTT(Round-TripTime)时延往往大于 1 毫秒,导致传统流控机制彻底失效。网络时延由四部分组成:

动态时延:主要由排队时延产生,受端口拥塞影响;

静态时延:主要包括网络转发(查表)时延和转发接口时延,一般为固定值,当前以太交换静态时延远高于超算专网;

网络跳数:指消息在网络中所经历的设备数;

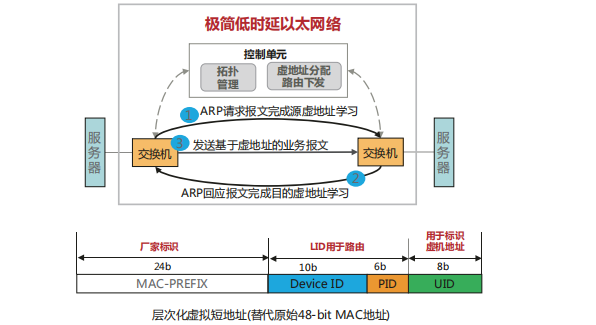

入网次数:指消息进入网络的次数。新一代无损以太网络在动态时延、静态时延、网络跳数以及入网次数几个方面均做出了系统性优化,大幅优化了网络性能,可满足高性能计算场景的实际诉求。

传统的以太交换机在转发层面,因需要考虑兼容性和众多协议支持等问题,导致转发流程复杂、转发时延较大。与此同时,以太查表算法复杂、查表时延大,导致整体转发处理时延长。目前业界主流商用以太交换机的静态转发时延大约在 600ns-1us 左右。

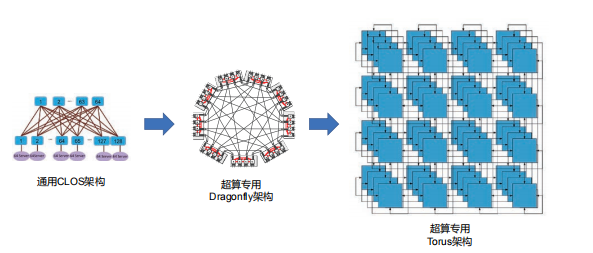

高性能计算场景的流量关注静态时延的同时需要支持超大规模组网。然而传统的 CLOS 架构作为主流网络架构,主要关注通用性,牺牲了时延和性价比。业界针对该问题开展了多样的架构研究和新拓扑的设计。

当前数据中心网络架构设计大多基于工程经验,不同搭建方式之间难以选择,缺乏理论指导和统一性设计语言。网络拓扑性能指标繁多,不同指标之间相互制约,指标失衡很难避免。

审核编辑:郭婷

-

cpu

+关注

关注

68文章

10854浏览量

211567 -

SSD

+关注

关注

21文章

2857浏览量

117360 -

数据中心

+关注

关注

16文章

4761浏览量

72030

原文标题:超融合数据中心网络解决方案

文章出处:【微信号:架构师技术联盟,微信公众号:架构师技术联盟】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

华为联合IEEE面向全球发布L4数据中心自动驾驶网络白皮书

讯维融合通信系统在金融数据中心建设的实践探索

超融合架构解决方案

传统数据中心架构和叶脊架构网络解决方案

CloudFabric3.0超融合数据中心网络全新升级,携手共筑算力新联接

数据中心网络架构:万兆电口模块的重要作用

华为发布2024数据中心能源十大趋势

超融合和虚拟化的区别

超融合数据中心网络架构的典型特征与价值

超融合数据中心网络架构的典型特征与价值

评论