或许大家都被苹果的WWDC23新品发布会刷屏,除了例行的iOS 17系统和Macbook电脑更新外,最令人期待的“One more thing”当属苹果的首款头显Vision Pro。

秘密研发七年、“延期发布”三次、库克时代最重磅的创新产品、传奇设计师Ive主导的最后一款苹果硬件......层层buff让苹果首款MR头显的发布更添几分传奇色彩。 苹果首款头显的介绍已经很多,本文主要着眼于苹果Vision Pro的新型人机交互,以及背后多达23个的感知传感器。

在苹果首款头显上,我们可以看到这样一个趋势:在新的消费电子设备中,传感器所占的比例越来越重,颠覆性的人机交互依赖于传感器的实现。

23个传感器!眼动跟踪+面部跟踪+虹膜识别+手势控制,苹果首款头显Vision Pro将带动这些赛道! 北京时间6月6日凌晨1点的WWDC23苹果新品发布会,成为今日早上的热搜事件,相信大家已经被苹果新品相关信息刷屏了。 在本次新品发布会中,最令人瞩目的“One more thing”当属苹果的首款头显Vision Pro。

这款AR设备被业界寄予厚望,苹果曾引爆了智能手机、平板、TWS无线耳机、智能手表等众多万亿级消费电子新市场,引领了一个又一个浪潮,多年来AR/VR产业不温不火,大家都在期待苹果的入场来引爆市场。

在发布前,彭博社曾表示,Vision Pro是苹果近10年最重要的新品。还有人认为,这款产品将拳打手机,脚踢笔记本,进而颠覆整个消费电子市场。

秘密研发七年、“延期发布”三次、库克时代最重磅的创新产品、传奇设计师Ive主导的最后一款苹果硬件......层层buff让苹果首款MR头显的发布更添几分传奇色彩。

在现场的Vision Pro展示区人满为患,据悉苹果不允许媒体上手体验,只能外观拍摄。从外观上来看,跟此前爆料的“类似滑雪护目镜”的设计类似。

虽然被定位为AR设备,但在苹果看来,Vision Pro完全可以看作一个无缝融合现实世界和电子世界的新型计算机。库克直接放话:正如iPhone带我们进入移动计算时代,Apple Vision Pro将带我们进入空间计算时代。 在苹果官网上,对Vision Pro的定义是——Apple的首个空间计算设备。

具体硬件配置上,它的屏幕包括两块微型OLED显示屏,像素2300万,每只眼睛的分辨率高达4k。芯片则配备了两块:一块M2和一块R1,后者负责处理来自12个摄像头、5个传感器和6个麦克风的输入,确保内容实时呈现在用户眼前 正如之前外界预测,设备上类似“表冠”的按钮可进行AR/VR模式切换。外框由特质的铝合金制成。其中囊括了包括显示屏、摄像头、传感器、高性能计算机、高效散热设计等组成部分。

眼罩有一系列不同的形状和尺寸选择,还打造了能够通过磁力吸附的定制光学插片。插电时能全天候使用,接到外置高性能电池最长可用两个小时,分离式电池设计。

售价方面Vision Pro定价3499美元,约24850人民币。售价及配置与同期其他AR设备对比如下图:

23个传感器带来的革命性操作系统和用户交互介面 作为一款AR设备,除了显示之外,最重要的一点就是人机交互的便捷混和高效。对于Vision Pro的人机交互特性,苹果在发布会及官网介绍上,也好不吝啬词语。

Apple 今日发布Apple Vision Pro,一台革命性的空间计算设备,将数字内容无缝融入真实世界,让用户处在当下并与他人保持连接。Vision Pro打造无边际画布,让app突破传统显示屏的限制,为用户带来全新的3D交互体验,以最自然、最直观的输入方式来控制——眼睛、双手与语音。Vision Pro搭载全球首创的空间操作系统 visionOS,通过用户与数字内容互动的模式,让数字内容如同存在于真实世界。Vision Pro的突破性设计,搭载超高分辨率显示系统,将 2300 万像素置于两个显示屏中,定制的 Apple芯片为独特的双芯片设计,确保用户每次的体验如同在眼前即时发生。

从介绍中,我们看到苹果希望人们以最自然、最直观的输入方式来控制Vision Pro,并为此开发了全球首创的空间操作系统 visionOS。

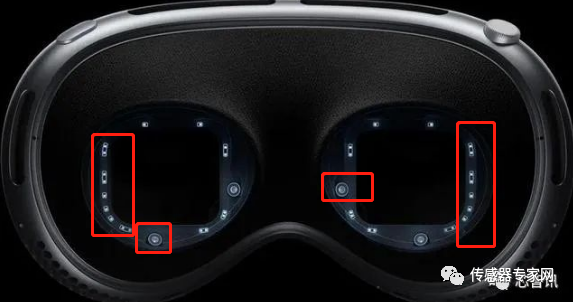

那么,我们怎么通过眼睛、双手与语音来控制Vision Pro?答案就藏在Vision Pro配置的23颗传感器中。 据官网介绍,Vision Pro至少配置了12个摄像头、5个传感器和6个麦克风等共计23个传感器——这甚至比此前分析师们预测的都要多。 这些传感器分布在整个设备的外侧、四周以及内框处,这样就可以监测手势、眼球、声音等各种信息。

▲Vision Pro传感器布局

人类生物研究表明,人类头部运动和视野回传的延迟须低于20ms,否则将产生视觉拖影感从而导致强烈眩晕。为了处理这些传感器带来的庞大数据,快速输出图像反馈,Vision Pro采用了双芯片设计——M2主芯片负责计算,此外R1芯片则专门用来处理来自这些23个传感器输入的数据,据苹果介绍,R1可在12 毫秒内将新影像串流至显示器,比眨眼还要快 8 倍,从而避免眩晕的发生。

Vision Pro的手势识别 因为手部在于眼睛下方,因此Vision Pro的手势识别通过位于设备下方的两个高分辨率图像传感器来识别。 据悉,该图像传感器可以每秒向设备传输超过10 亿像素,提供精确的头部和手部跟踪以及实时3D映射,之后通过算法分析,让Vision Pro从各种位置理解用户的手势控制指令。

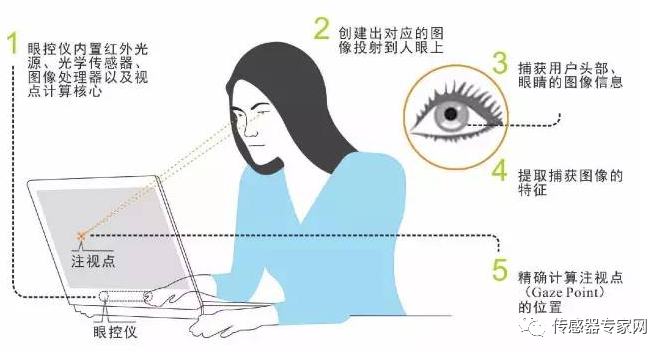

Vision Pro的眼动识别 由LED和红外摄像头组成的眼动追踪系统,可以将不可见光图案投射到每只眼睛上,能够判断用户当前注视的位置。这使得用户无需使用手柄控制,只需通过注视来浏览应用图标,轻点选择,轻扫滚动,或者发出语音指令即可操控。

▲眼动识别原理

苹果强调,用户在显示屏上观看的区域和眼球追踪数据不会与苹果或网站共享。相反,来自传感器和摄像头的数据在系统级别进行处理,因此应用程序也不一定需要“看到”用户或他们的周围环境来提供空间体验。

此外,Vision Pro的语音识别,通过内置于设备的MEMS麦克风监测用户语音指令进行控制,这点与智能手机语音助手等类似,相信大家也或多或少体验过了。 Vision Pro的虹膜识别与苹果的第一款 3D 相机 作为一款私人设备,如iPhone一样,苹果也为Vision Pro添加了安全识别功能——Optic ID,Optic ID是一款虹膜识别系统。 据苹果介绍,Optic ID使用不可见的LED光源传感器来分析虹膜,然后将其与存储在Secure Enclave上的注册数据进行比较,这与Face ID和触控ID使用的过程类似。并且光学ID数据是完全加密的,不会提供给其他应用程序,也不会离开设备本身,用户不必担心生物信息被泄露到网上。

此外,Vision Pro 也是“苹果的第一款 3D 相机”,通过配备的LiDAR激光雷达传感器和深感传感器,可以感知深度信息,配合全新的具有三维界面的操作系统 visionOS,能够创建用户周围环境的融合 3D 地图,使它能够在空间中准确呈现数字内容。

用户可以将常用、熟悉的App放置在空间中的任何位置,也可以将它们放大、缩小到适合的尺寸,包括从消息线程中把物体拉出来放到真实世界中。比如,Vision Pro 上的 FaceTime 可以在视频通话时显示真人大小的人物,还优化了查看照片和视频的体验。

Vision Pro的Eyesight功能 为了让你戴上眼镜后不与现实彻底脱节,当有人进入视野范围时,Vision Pro屏幕的透明度会随时变化。如果用户处于全 VR 模式,一个发光的屏幕会遮挡住他们的眼睛,以示他们不想被打扰。 而监测是否有人在附近的功能,则来自于设备前面的图像传感器。

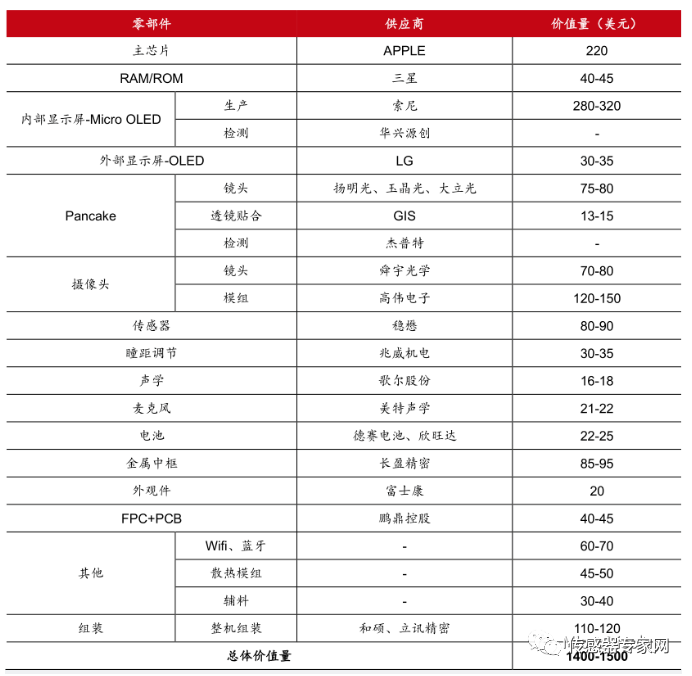

中国第一MEMS企业歌尔股份不是麦克风供应商?Vision Pro供应链曝光 此前,中金公司、民生证券等多家分析机构,贴出了Vision Pro的供应链和BOM零部件成本价格,合计成本大概在1200~1500美金左右。

其中,Vision Pro使用的图像传感器来自索尼,传感器由我国台湾企业、全球最大砷化镓晶圆代工服务公司稳懋半导体制造,此前稳懋半导体一位苹果iPhone 手机生产ToF 传感器、LiDAR(激光雷达)等传感器。声学部件由歌尔股份提供,值得注意的是,据证券商提供的BOM清单显示,MEMS麦克风由美特声学供应,美特科技隶属于台湾美律实业,2016年立讯精密通过入股取得苏州美特 51%股权,从而进入声学领域。 当然,本清单由证券商根据渠道信息汇总,Vision Pro的具体零部件可能需要半年后正式上市后拆解才可得知。

结语 从以上Vision Pro的各种人机交互中,使用到了图像传感器(可见光/红外线)、MEMS麦克风、3D飞行时间(ToF)传感器、激光雷达,以及用于姿态检测的惯性传感器(陀螺仪、加速度计、IMU)等各种传感器。

同时,我们可以看到这样一个趋势:在新的消费电子设备中,传感器所占的比例越来越重,颠覆性的人机交互模式,往往通过新的传感器来实现。譬如,大家都在期待的柔性传感器,将为未来带来更多的人机交互体验。 随着苹果进入AR/VR赛道,后期凭借其强大的开发能力以及原苹果软件生态数以千万级的开发者,是否会给AR/VR赛道带来爆炸性的发展?我们拭目以待。

-

传感器

+关注

关注

2550文章

51034浏览量

753036 -

mems

+关注

关注

129文章

3924浏览量

190572 -

苹果

+关注

关注

61文章

24395浏览量

198528 -

MR

+关注

关注

2文章

334浏览量

43324 -

激光雷达

+关注

关注

968文章

3967浏览量

189814 -

TOF

+关注

关注

9文章

482浏览量

36329

发布评论请先 登录

相关推荐

Vision Pro每台23个传感器!苹果首款头显带动这些传感器迎来新机遇

Vision Pro每台23个传感器!苹果首款头显带动这些传感器迎来新机遇

评论