有理论基础,我们就可以进行深度优化了。为什么 transformer 性能这么好?它给众多大语言模型带来的上下文学习 (In-Context Learning) 能力是从何而来?在人工智能领域里,transformer 已成为深度学习中的主导模型,但人们对于它卓越性能的理论基础却一直研究不足。 最近,来自 GoogleAI、苏黎世联邦理工学院、Google DeepMind 研究人员的新研究尝试为我们揭开谜底。在新研究中,他们对 transformer 进行了逆向工程,寻找到了一些优化方法。论文《Uncovering mesa-optimization algorithms in Transformers》:

。

该研究的贡献包括:

。

该研究的贡献包括:

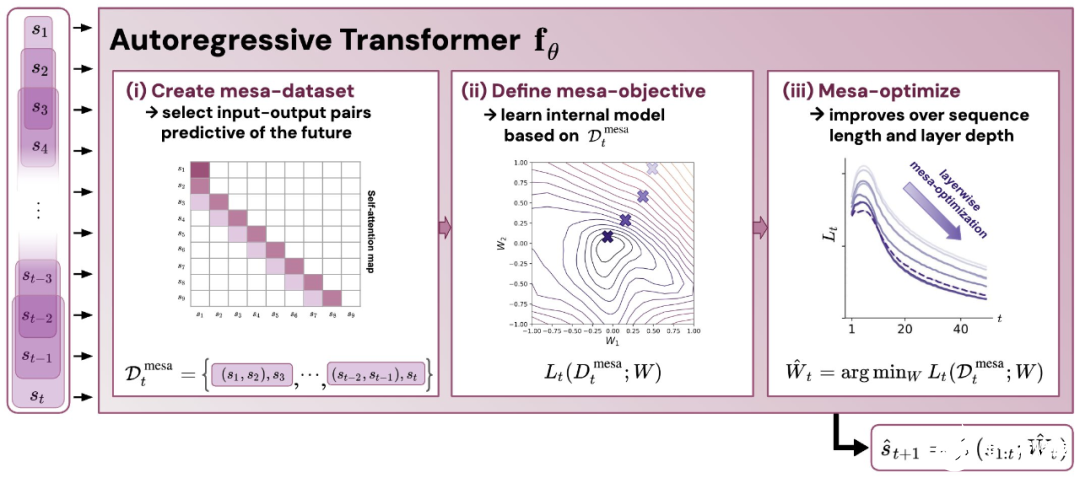

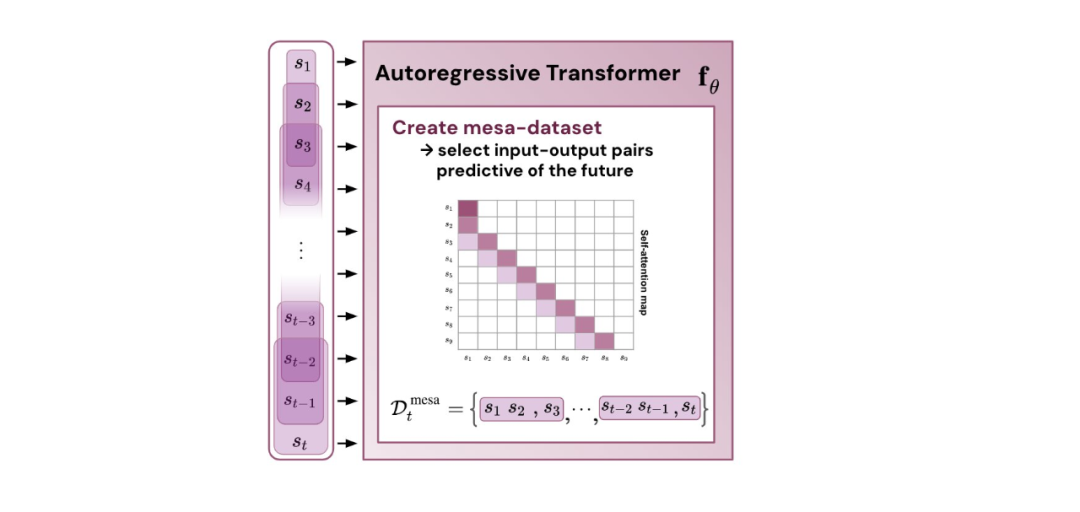

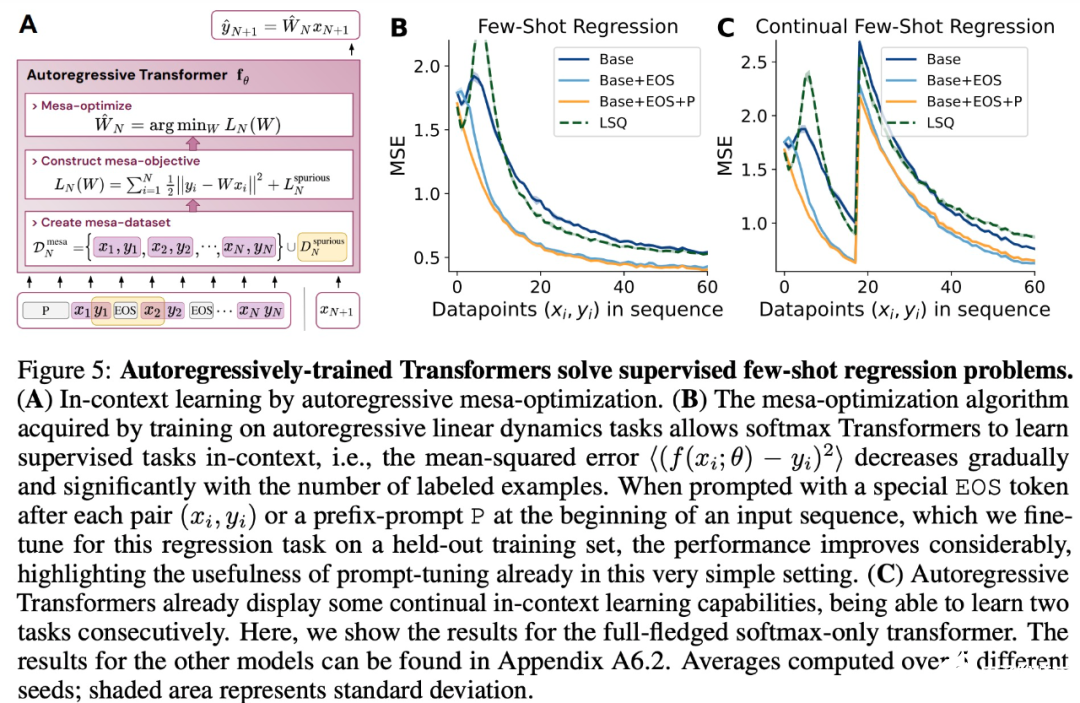

- 概括了 von Oswald 等人的理论,并展示了从理论上,Transformers 是如何通过使用基于梯度的方法优化内部构建的目标来自回归预测序列下一个元素的。

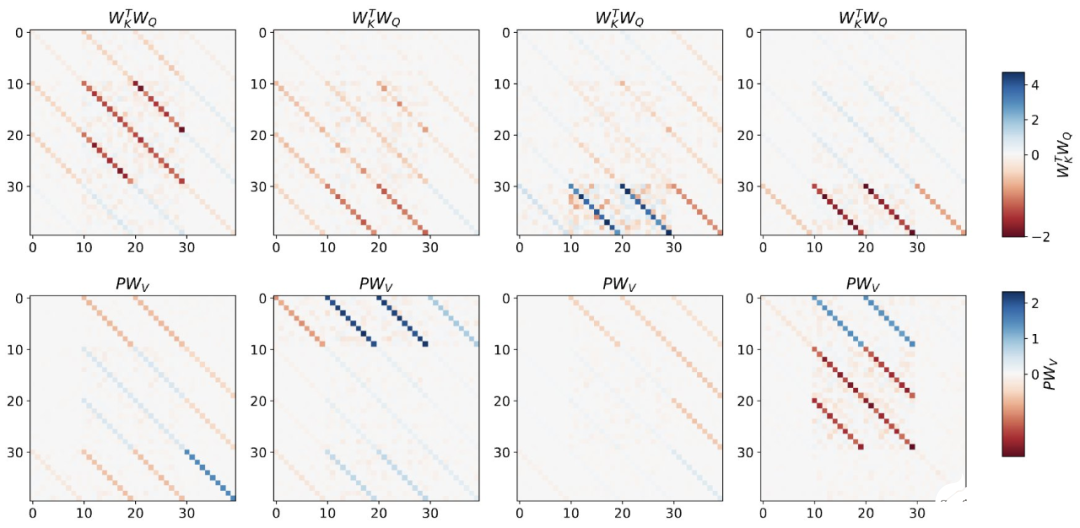

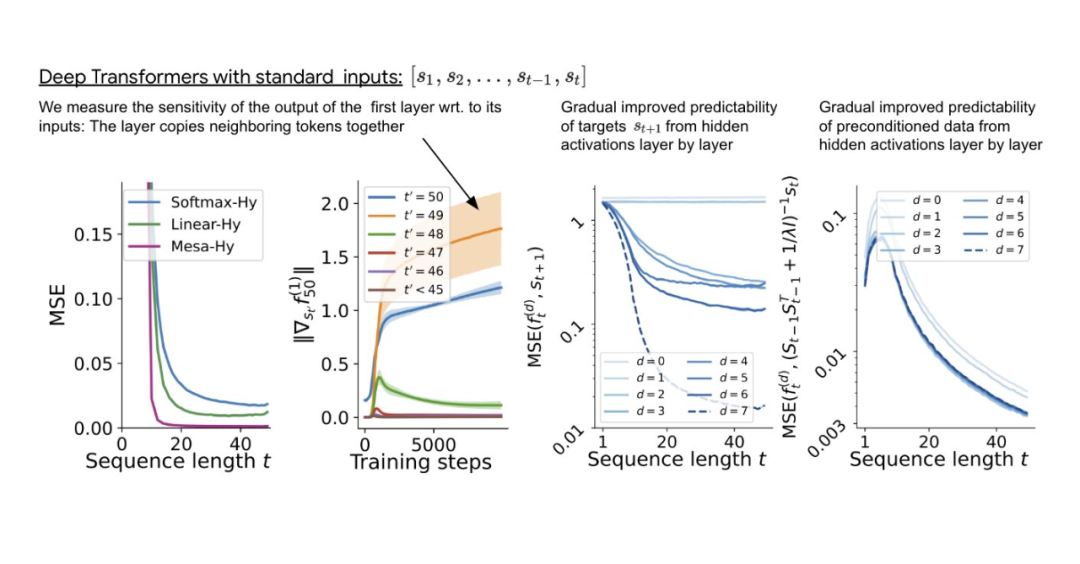

- 通过实验对在简单序列建模任务上训练的 Transformer 进行了逆向工程,并发现强有力的证据表明它们的前向传递实现了两步算法:(i) 早期自注意力层通过分组和复制标记构建内部训练数据集,因此隐式地构建内部训练数据集。定义内部目标函数,(ii) 更深层次优化这些目标以生成预测。

- 与 LLM 类似,实验表明简单的自回归训练模型也可以成为上下文学习者,而即时调整对于改善 LLM 的上下文学习至关重要,也可以提高特定环境中的表现。

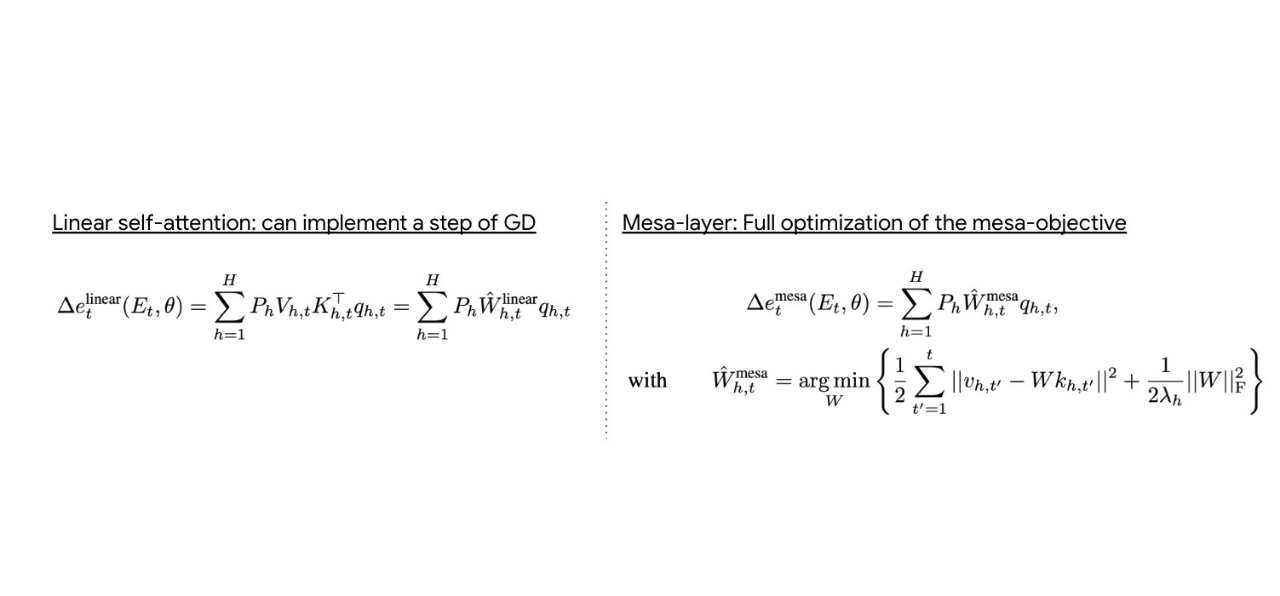

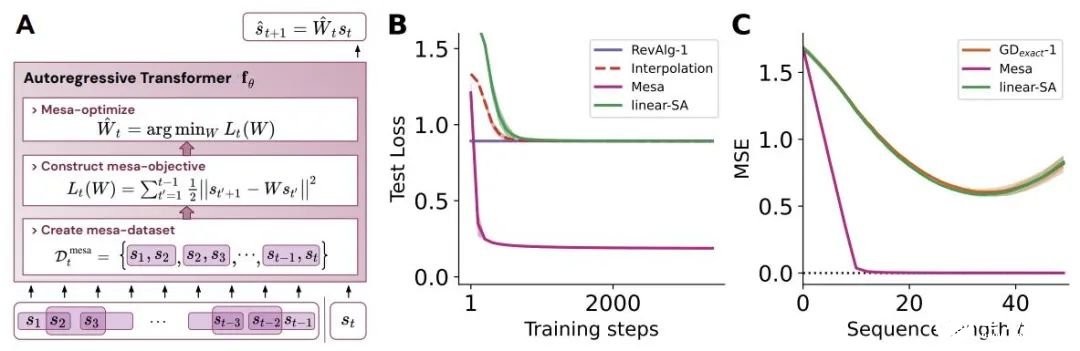

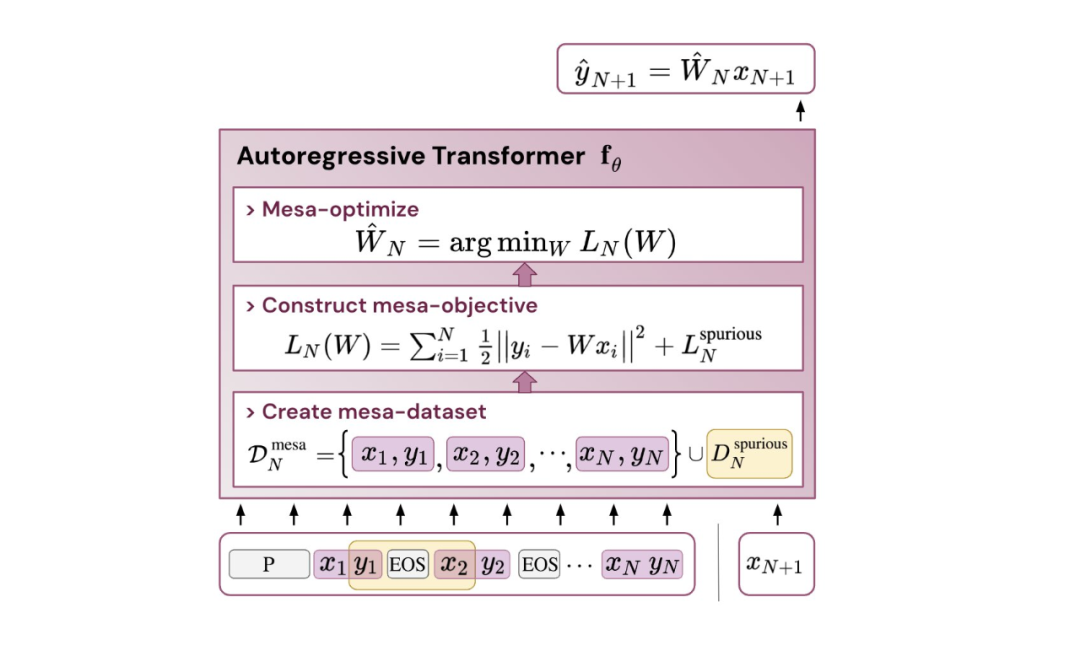

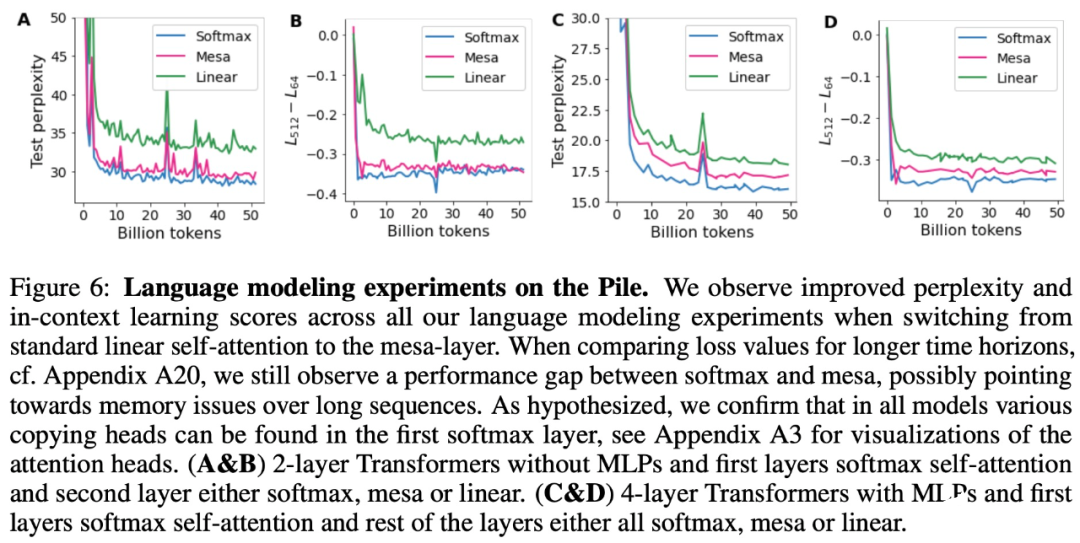

- 受发现注意力层试图隐式优化内部目标函数的启发,作者引入了 mesa 层,这是一种新型注意力层,可以有效地解决最小二乘优化问题,而不是仅采取单个梯度步骤来实现最优。实验证明单个 mesa 层在简单的顺序任务上优于深度线性和 softmax 自注意力 Transformer,同时提供更多的可解释性。

- 在初步的语言建模实验后发现,用 mesa 层替换标准的自注意力层获得了有希望的结果,证明了该层具有强大的上下文学习能力。

,这对应于选择 W_0 = 0。

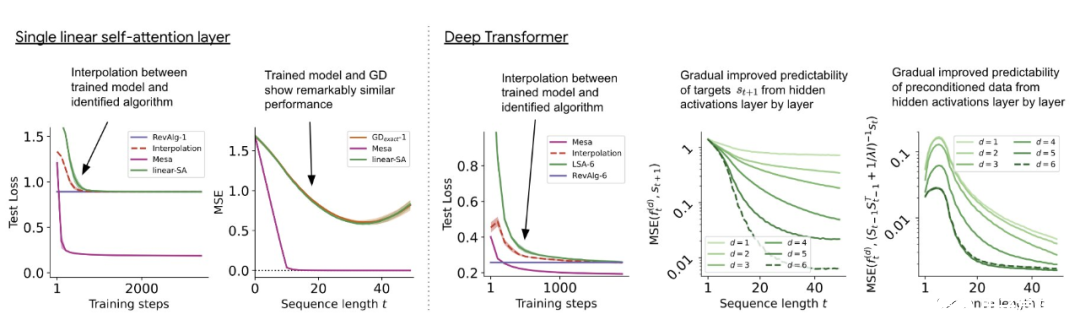

与单层模型一样,作者在训练模型的权重中看到了清晰的结构。作为第一个逆向工程分析,该研究利用这个结构并构建一个算法(RevAlg-d,其中 d 表示层数),每个层头包含 16 个参数(而不是 3200 个)。作者发现这种压缩但复杂的表达式可以描述经过训练的模型。特别是,它允许以几乎无损的方式在实际 Transformer 和 RevAlg-d 权重之间进行插值。

虽然 RevAlg-d 表达式解释了具有少量自由参数的经过训练的多层 Transformer,但很难将其解释为 mesa 优化算法。因此,作者采用线性回归探测分析(Alain & Bengio,2017;Akyürek et al.,2023)来寻找假设的 mesa 优化算法的特征。

在图 3 所示的深度线性自注意力 Transformer 上,我们可以看到两个探针都可以线性解码,解码性能随着序列长度和网络深度的增加而增加。因此,基础优化发现了一种混合算法,该算法在原始 mesa-objective Lt (W) 的基础上逐层下降,同时改进 mesa 优化问题的条件数。这导致 mesa-objective Lt (W) 快速下降。此外可以看到性能随着深度的增加而显着提高。

因此可以认为自回归 mesa-objective Lt (W) 的快速下降是通过对更好的预处理数据进行逐步(跨层)mesa 优化来实现的。

,这对应于选择 W_0 = 0。

与单层模型一样,作者在训练模型的权重中看到了清晰的结构。作为第一个逆向工程分析,该研究利用这个结构并构建一个算法(RevAlg-d,其中 d 表示层数),每个层头包含 16 个参数(而不是 3200 个)。作者发现这种压缩但复杂的表达式可以描述经过训练的模型。特别是,它允许以几乎无损的方式在实际 Transformer 和 RevAlg-d 权重之间进行插值。

虽然 RevAlg-d 表达式解释了具有少量自由参数的经过训练的多层 Transformer,但很难将其解释为 mesa 优化算法。因此,作者采用线性回归探测分析(Alain & Bengio,2017;Akyürek et al.,2023)来寻找假设的 mesa 优化算法的特征。

在图 3 所示的深度线性自注意力 Transformer 上,我们可以看到两个探针都可以线性解码,解码性能随着序列长度和网络深度的增加而增加。因此,基础优化发现了一种混合算法,该算法在原始 mesa-objective Lt (W) 的基础上逐层下降,同时改进 mesa 优化问题的条件数。这导致 mesa-objective Lt (W) 快速下降。此外可以看到性能随着深度的增加而显着提高。

因此可以认为自回归 mesa-objective Lt (W) 的快速下降是通过对更好的预处理数据进行逐步(跨层)mesa 优化来实现的。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表德赢Vwin官网 网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

- 人工智能

+关注

关注

1787文章

45805浏览量

234130 - 深度学习

+关注

关注

73文章

5415浏览量

120439 - DeepMind

+关注

关注

0文章

129浏览量

10753 - Transformer

+关注

关注

0文章

135浏览量

5934 - 大模型

+关注

关注

2文章

2053浏览量

1785

原文标题:Transformer的上下文学习能力是哪来的?

文章出处:【微信号:tyutcsplab,微信公众号:智能感知与物联网技术研究所】欢迎添加关注!文章转载请注明出处。

发布评论请先登录

相关推荐

SystemView上下文统计窗口识别阻塞原因

SystemView工具可以记录嵌入式系统的运行时行为,实现可视化的深入分析。在新发布的v3.54版本中,增加了一项新功能:

上下文统计窗口,提供了对任务运行时统计信息的深入分析,使用户能够彻底检查每个任务,帮助开发人员识别阻塞原因。

【《大语言模型应用指南》阅读体验】+ 基础知识学习

的信息,提供更全面的

上下文理解。这使得模型能够更准确地理解复杂问题中的多个层面和隐含意义。 2. 语义分析 模型通过训练

学习到语言的语义特征,能够识别文本中的命名实体、句法结构和语义关系等信息。这些

发表于08-02 11:03

Transformer能代替图神经网络吗

Transformer作为一种在处理序列数据方面表现出色的深度

学习模型,自其提出以来,已经在自然语言处理(NLP)、时间序列分析等领域取得了显著的成果。然而,关于

Transformer是否能完全代替图神经网络(GNN)的问题,需

Transformer语言模型简介与实现过程

在自然语言处理(NLP)领域,

Transformer模型以其卓越的

性能和广泛的应用前景,成为了近年来最引人注目的技术之一。

Transformer模型由谷歌在2017年提出,并首次应用于神经机器翻译

编写一个任务调度程序,在上下文切换后遇到了一些问题求解

大家

好, 我正在编写一个任务调度程序,在

上下文切换后遇到了一些问题。 为下一个任务恢复

上下文后: __builtin_tricore_mtcr_by_name(\"pcxi\"

发表于05-22 07:50

微信大模型扩容并开源,推出首个中英双语文生图模型,参数规模达15亿

基于Diffusion

Transformer的混元DiT是一种文本到图像生成模块,具备中英细粒度理解

能力,能与用户进行多轮对话,根据

上下文生成并完善图像。

【大语言模型:原理与工程实践】大语言模型的基础技术

Transformer有效避免了CNN中的梯度消失和梯度爆炸问题,同时提高了处理长文本序列的效率。此外,模型编码器可以运用更多层,以捕获输入序列中元素间的深层关系,并

学习更全面的

上下文向量表示。 预训练语言模型

发表于05-05 12:17

ISR的上下文保存和恢复是如何完成的?

函数:ifxCPU_enableInterrupts ();如果我让更高优先级的 ISR 中断优先级较低的 ISR,那么 ISR 的

上下文保存和恢复是如何完成的?

发表于01-22 06:28

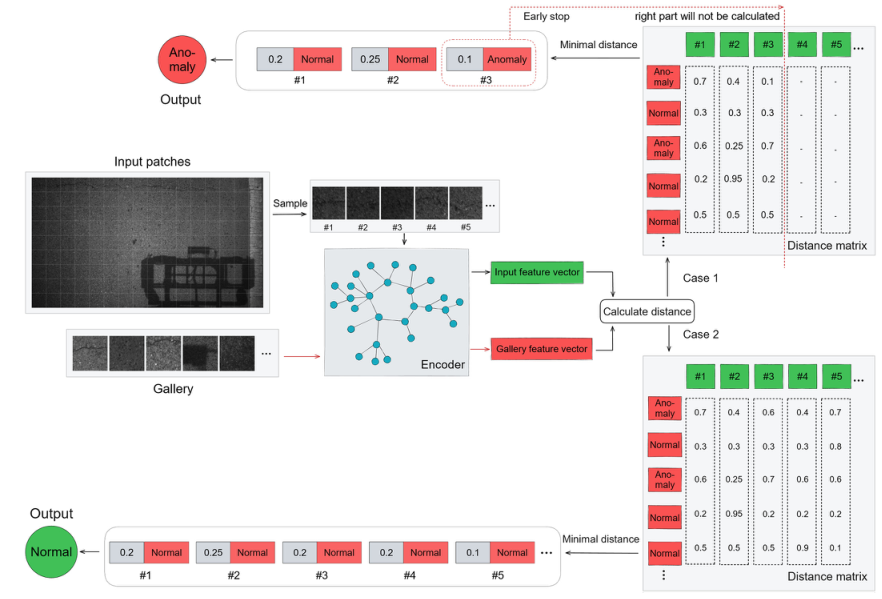

基于transformer和自监督学习的路面异常检测方法分享

铺设异常检测可以帮助减少数据存储、传输、标记和处理的压力。本论文描述了一种基于

Transformer和自监督

学习的新方法,有助于定位异常区域。

FreeRTOS系列技术文章:上下文切换

嵌入式实时操作系统(RTOS)中的

上下文切换是指保存和恢复任务的状态,以使调度程序能够切换到另一个任务,从而促进多任务处理。

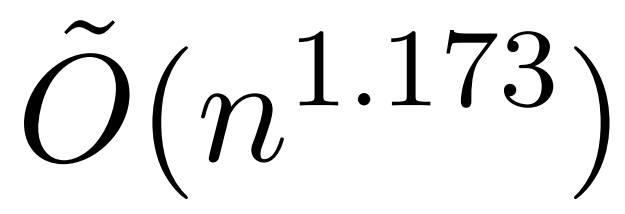

全新近似注意力机制HyperAttention:对长上下文友好、LLM推理提速50%

已经成功应用于自然语言处理、计算机视觉和时间序列预测等领域的各种

学习任务。虽然取得了成功,但这些模型仍面临着严重的可扩展性限制,原因是对其注意力层的精确计算导致了二次(在序列长度上)运行时和内存复杂性。这对将

Transformer模型扩展到更长的

关于深度学习模型Transformer模型的具体实现方案

Transformer本质上是一个 Encoder-Decoder 架构。因此中间部分的

Transformer可以分为两个部分:编码组件和解码组件。

发表于11-17 10:34

•

420次阅读

Linux技术:什么是cpu上下文切换

过多的

上下文切换会消耗 CPU 的时间来保存和恢复寄存器、程序计数器、内核栈和虚拟内存等数据,从而导致系统

性能显着下降。 既然

上下文切换对系统

性能的影响如此之大,那么我们如何检查它呢?

发表于09-01 09:31

•

321次阅读

为什么transformer性能这么好?Transformer的上下文学习能力是哪来的?

为什么transformer性能这么好?Transformer的上下文学习能力是哪来的?

评论