“大数据时代”的概念最早由世界著名的咨询公司麦肯锡提出。麦肯锡说:“数据已渗透到今天的每个行业和业务功能领域,并已成为重要的生产要素”。

本文引自:《数据技术基础》(作者:张洁、吕佑龙、张朋、汪俊亮)。

随着互联网技术的发展,现有计算机拥有了在极短时间内处理海量数据的能力,进而催生了一大批企业利用大量的数据,将传统的企业运营方式进行颠覆,使得企业实现了从靠人力决策到靠数据决策的转变,这意味着更少的决策失误和更大的利润,而对于普通民众而言则能享受到更好的服务质量和办事效率。 在以上过程中,大量的企业决策与服务提供需要依靠大数据技术支撑,并且大数据带来的经济效益已经大于开发成本,由此进入大数据时代。

内涵与特征 1)大数据的内涵

大数据的定义方法有很多种,如果仔细观察,会发现不同领域专家学者给出了不同的定义。通常所说的“大数据”往往指的是“大数据现象”。

(1)计算机科学与技术:当数据量、数据的复杂程度、数据处理的任务要求等超出了传统数据存储与计算能力时,称之为大数据(现象)。可见,计算机科学与技术中是从存储和计算能力视角理解大数据——大数据不仅是“数据存量”的问题,还与数据增量、复杂度和处理要求(如实时分析)有关。

(2)统计学:当能够收集足够的全部(总体中的绝大部分)个体的数据,且计算能力足够强,可以不用抽样,直接在总体上就可以进行统计分析时,称之为大数据(现象)。可见,统计学主要从所处理的问题和总体的规模之间的相对关系视角理解“大数据”。

(3)机器学习:当训练集足够大,且计算能力足够强,只需要通过对已有的实例进行简单查询即可达到“智能计算的效果”时,称之为大数据(现象)。可见,机器学习主要从“智能的实现方式”理解大数据-智能可以通过简单的实例学习和机械学习的方式来实现。

(4)社会科学家:当多数人的大部分社会行为可以被记录下来时,称之为大数据(现象)。可见,社会科学家眼里的大数据主要是从“数据规模与价值密度角度”谈的,即数据规模过大导致的价值密度过低。

总之,术语大数据的内涵已超出了数据本身,代表的是数据带来的机遇与挑战,可以总结如下。

(1)机遇:原先无法(或不可能)找到的数据,现在可能找到;原先无法实现的计算目的(如数据的实时分析),现在可以实现。

(2)挑战:原先一直认为正确或最佳的理念、理论、方法、技术和工具越来越凸现出其局限性,在大数据时代需要改变思考模式。

2)大数据的特征

通常,用4V来表示大数据的基本特征。但是,建议读者结合上述对大数据的内涵的讨论,灵活理解大数据的特征。

(1)Volume(数据量大):数据量大是一个相对于计算和存储能力的说法,就目前而言,当数据量达到PB级以上,一般称为“大”的数据。但是,应该注意到,大数据的时间分布往往不均匀,近几年所生成的数据,相对占比最高。

(2)Variety(类型多):数据类型多是指大数据存在多种类型的数据,不仅包括结构化数据,还包括非结构化数据和半结构化数据。有统计显示,在未来,非结构化数据的占比将达到90%以上。非结构化数据所包括的数据类型很多,例如网络日志、音频、视频、图片、地理位置信息等。数据类型的多样性往往导致数据的异构性,进而加大了数据处理的复杂性,对数据处理能力提出了更高要求。

(3)Value(价值密度低):在大数据中,价值密度的高低与数据总量的大小之间并不存在线性关系,有价值的数据往往被淹没在海量无用数据之中,也就是人们常说的“我们淹没在数据的海洋,却又在忍受着知识的饥渴(We are drowning in a sea of data and thirsting for knowledge)”。例如,一段长达120min连续不间断的监控视频中,有用数据可能仅有几秒。因此,如何在海量数据中洞见有价值的数据成为数据科学的重要课题。

(4)Velocity(速度快):大数据中所说的“速度”包括两种——增长速度和处理速度。一方面,大数据增长速度快。有统计显示,2009—2020年期间的数字宇宙的年均增长率将达到41%,另一方面,对大数据处理的时间(计算速度)要求也越来越高,“大数据的实时分析”成为热门话题。

业务数据化

随着互联网的快速发展,企业逐渐面临越来越多大数据时代的不确定性和挑战,很可能因为成本高居不下而逐渐失去份额,被竞争对手超越并最终出局。企业每天都会产生大量的业务数据,通过实现业务数据化可以帮助企业经营者对尚未掌握的商业机遇进行理性评估判断,实现业务增值,同时帮助企业提升内部运营效率,降低成本。因此业务数据化是未来发展的一大趋势。

1)设计目标和原则

业务数据化的设计目标是要从大量的、可能是杂乱无章的、难以理解的数据中抽取并推导出对于某些特定的人或事物来说有价值、有异议的数据。设计原则包括简约原则、综观原则、解释原则以及智慧原则。

(1)简约原则:简化现有的数据集,使得一种小规模的数据就能够产生同样的分析效果。通过一些数据规约方法获取可靠数据,减少数据集规模,提高数据抽象程度,提升数据挖掘效率,使之在实际工作中,可以根据需要选用合适的处理方法,以达到操作上的简单、简洁、简约和高效。

(2)综观原则:对认知对象进行综合性的观察、分析和探索,以求得解决问题的策略和战略。它坚持整体的具体统一性,凸显认知对象的具体实在性。

(3)解释性原则:针对提取的数据究竟表达什么或意味什么,很大程度上,并不取决于数据信息自身所标明的“客观实在性”,而是取决于认知主体对数据进行解读时的主观评价,以此揭示数据的本质。

(4)智慧原则:在对数据的处理挖掘过程中既要兼具数据处理能力,也要具备应用算法和编写代码的经验。在大数据时代,不仅要关注数据的多样性、差异性、精确性和实效性;还要深入挖掘各类数据,并在此基础上在不同的数据集成中分析不同的假设情境,建构不同的可视化图像,揭示数据集成的变化及其产生的效用。

2)数据线程

数据线程是指以价值链活动为脉络,以业务为中心,构建的数据建模、关联、因果、集成、演化等全主线流程。数据线程通过建立面向业务应用的数据模型,实现各种信息化业务系统数据源的统一建模需求;针对设计、制造、运行、维护等生产环节,发掘数据资源间的复杂关联关系和因果关系;通过描述业务驱动的数据动态演化过程,提升对产品迭代、工艺更新、设备维护等业务决策问题的适应能力。数据线程围绕数据生成、汇聚、存储、归档、分析、使用和销毁等全过程,实现了产品研发设计、生产制造、经营管理和销售服务等全价值链活动中业务数据的有效组织,为业务数据化提供了良好的基础。

3)业务数据系统

业务数据系统主要包括业务数据集成系统、业务数据管理系统、业务数据分析系统、业务数据可视化系统等多个子系统。

(1)业务数据集成系统:是面向业务的数据集成系统。随着企业信息化建设的发展,企业建立了众多的信息系统,以帮助企业进行内外部业务的管理。但是,企业各系统的数据是分布的、异构的,为了共享这些业务数据,需要一个业务数据集成系统来完成数据的共享与转换。业务数据集成系统通过对具体的数据库业务数据进行访问,实现了基于变量的增量数据的获取和发送,不仅解决了分布式环境下异构数据的集成,还具有良好的扩展性及部署的简单性。

(2)业务数据管理系统:是业务数据系统的核心组成部分,主要完成对业务数据的操纵与管理功能,实现数据对象的创建、数据存储数据的查询、添加、修改与删除操作和数据库的用户管理、权限管理等。业务数据管理系统可以依据它所支持的数据库模型来做分类,例如关系式、XML;或依据所支持的计算机类型来做分类,例如服务器群集、移动电话;或依据所用查询语言来做分类,例如SQL、XQuery;或依据性能冲量重点来做分类,例如最大规模、最高运行速度。

(3)业务数据分析系统:主要功能是从众多外部系统中,采集相关的业务数据,集中存储到系统的数据库中。系统内部对所有的原始数据通过一系列处理转换之后,存储到数据仓库的基础库中;然后,通过业务需要进行一系列的数据转换到相应的数据集市,供其他上层数据应用组件进行专题分析或者展示,并将数据加以汇总和理解并消化,以求最大化地开发数据的功能,发挥数据的作用。

(3)业务数据可视化系统:将数据进行更清晰的展示,能够准确而高效、精简而全面地传递信息和知识。可视化能将不可见的数据现象转化为可见的图形符号,能将错综复杂、看起来没法解释和关联的数据,建立起联系和关联,发现规律和特征,获得更有商业价值的洞见和价值。

4)智能制造业务数据

智能制造业务数据主要包括以下6个方面。

(1)从底层的设备控制系统中采集的数据,包括设备的状态数据、设备参数等,如数控系统、产线控制系统等。

(2)直接采集各类终端及传感器的数据,如温度传感器、振动传感器、噪声传感器、手持终端等。

(3)从各类业务应用信息系统中获取数据,如MES系统从PDM系统获取BOM数据,从ERP系统获取订单数据等。

(4)从各类业务运行过程中获取的样本数据集,是指以业务为中心,积累的历史样本数据,可用于智能制造过程中模型的训练。

(5)指算法和模型数据,是指机器学习、深度学习、强化学习等算法和已训练好的模型,用户可以直接从业务数据系统中调用这些算法和模型数据,用于制造大数据分析、预测、决策等。

(6)从互联网获取数据,如获取市场信息数据、环境数据,上下游供应商数据等。还包括来源于人类轨迹产生的数据,包括在现代工业制造链中,从采购,生产,物流与销售市场的内部流程等。通过行为轨迹数据与设备数据的结合,可以帮助我们实现客户的分析和挖掘。

大数据时代的新理念

大数据时代的到来改变了人们的生活方式、思维模式和研究范式,也带来了很多全新的理念。

(1)研究范式的新认识——从第三范式到第四范式:2007年,图灵奖获得者Jim Gray提出了科学研究的第四范式——数据密集型科学发现(Data-intensive Scientific Discovery)。在他看来,人类科学研究活动已经历过3种不同范式的演变过程(原始社会的实验科学范式、以模型和归纳为特征的理论科学范式和以vwin 仿真为特征的计算科学范式),目前正在从计算科学范式转向数据密集型科学发现范式。第四范式,即数据密集型科学发现范式的主要特点是科学研究人员只需要从大数据中查找和挖掘所需要的信息和知识,无须直接面对所研究的物理对象。

(2)数据重要性的新认识——从数据资源到数据资产:在大数据时代,数据不仅是一种资源,而更是一种重要的资产。因此,数据科学应把数据当作一种资产来管理,而不能仅仅当作资源来对待。也就是说,与其他类型的资产相似,数据也具有财务价值,且需要作为独立实体进行组织与管理。

(3)对方法论的新认识——从基于知识解决问题到基于数据解决问题:传统方法论往往是基于知识的,即从大量实践(数据)中总结和提炼出一般性知识(定理、模式、模型、函数等)之后,用知识去解决(或解释)问题。因此,传统的问题解决思路是问题→知识→问题,即根据问题找知识,并用知识解决问题。然而,数据科学中兴起了另一种方法论——问题→数据→问题,即根据问题找数据,并直接用数据(不需要把数据转换成知识的前提下)解决问题。

(4)对数据分析的新认识——从统计学到数据科学:在传统科学中,数据分析主要以数学和统计学为直接理论工具。但是,云计算等计算模式的出现以及大数据时代的到来,提升了人们对数据的获取、存储、计算与管理能力。在海量、动态、异构的数据环境中,人们开始重视相关分析,而不仅仅是因果分析。人们更加关注的是数据计算的“效率”而不再盲目追求其精准度。

(5)对计算智能的新认识——从复杂算法到简单算法:“只要拥有足够多的数据,我们可以变得更聪明”是大数据时代的一个新认识。因此,在大数据时代,原本复杂的智能问题变成简单的数据问题——只要对大数据的进行简单查询就可以达到“基于复杂算法的智能计算的效果”。

(6)对数据管理重点的新认识——从业务数据化到数据业务化:在大数据时代,企业需要重视一个新的课题——数据业务化,即如何基于数据动态地定义、优化和重组业务及其流程,进而提升业务的敏捷性,降低风险和成本。

(7)对决策方式的新认识——从目标驱动型决策到数据驱动型决策:传统科学思维中,决策制定往往是目标或模型驱动的——根据目标(或模型)进行决策。在大数据时代出现了另一种思维模式,即数据驱动型决策,数据成为决策制定的主要触发条件和重要依据。

(8)对产业竞合关系的新认识——从以战略为中心竞合关系到以数据为中心竞合关系:在大数据时代,企业之间的竞合关系发生了变化,原本相互激烈竞争,甚至不愿合作的企业,不得不开始合作,形成新的业态和产业链。

(9)对数据复杂性的新认识——从不接受到接受数据的复杂性:在传统科学看来,数据需要彻底净化和集成,计算目的是需要找出精确答案,其背后的哲学是“不接受数据的复杂性”。然而,大数据中更加强调的是数据的动态性、异构性和跨域等复杂性——弹性计算、鲁棒性、虚拟化和快速响应,开始把复杂性当作数据的一个固有特征来对待,组织数据生态系统的管理目标转向将组织处于混沌边缘状态。

(10)对数据处理模式的新认识——从小众参与到大众协同:传统科学中,数据的分析和挖掘都是基于专家经验,但在大数据时代,基于专家经验的创新工作成本和风险越来越大,而基于专家-业余相结合(Pro-Am)的大规模协作日益受到重视,正成为解决数据规模与形式化之间矛盾的重要手段。

大数据时代的新术语

大数据时代的到来,为业务活动提出了一些新的任务和挑战,同时出现了很多全新术语。

(1)数据化(datafication):捕获人们的生活与业务活动,并将其转换为数据的过程。

(2)数据柔术(data jiu-jitsu):数据科学家将大数据转换具有立即产生商业价值的数据产品(data product)的能力,如图1所示。数据产品是指在零次数据或一次数据的基础上,通过数据加工活动形成的二次或三次数据,数据产品的特点包括:高层次性,其一般为二次数据或三次数据;成品性,数据产品往往不需要(或不需要大量的)进一步处理即可直接应用;商品性,数据产品可以直接用于销售或交易;易于定价,相对于原始数据,数据产品的定价更为容易。

图1数据柔术

图1数据柔术

(3)数据改写(data munging):带有一定的创造力和想象力的数据再加工行为,主要涉及数据的解析(parsing)、提炼(scraping)、格式化(formatting)和形式化(formalization)处理。与一般数据处理不同的是,数据再加工强调的是数据加工过程中的创造力和想象力。

(4)数据打磨(data wrangling):采用全手工或半自动化的方式,通过多次反复调整与优化过程,即将原始数据转换为一次数据(或二次数据)的过程。其特殊性表现在不是完全自动化方式实现,一般用手工或半自动化工具;不是一次即可完成,需要多次反复调整与优化。

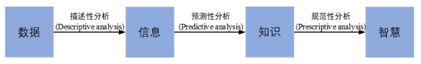

(5)数据分析式思维模式(data-analytic thinking):一种从数据视角分析问题,并基于数据来解决问题的思维模式。数据分析思维模式与传统思维模式不同。前者,主要从数据入手,最终改变业务;后者从业务或决策等要素入手,最终改变数据。从分析对象和目的看,数据分析可以分为3个不同层次,如图2所示。

图2数据分析的层次

(6)描述性分析( descriptive analysis):采用数据统计中的描述统计量、数据可视化等方法描述数据的基本特征,如总和、均值、标准差等。描述性分析可以实现从数据到信息的转化。

(7)预测性分析(predictive analysis):通过因果分析、相关分析等方法,基于过去/当前的数据得出潜在模式、共性规律或未来趋势。预测性分析可以实现从信息到知识的转化。

(8)规范性分析(normative analysis):不仅要利用当前和过去的数据,而且还会综合考虑期望结果、所处环境、资源条件等更多影响因素,在对比分析所有可能方案的基础上,提出可以直接用于决策的建议或方案。规范性分析可实现从知识到智慧的转变。

(9)数据洞见(data insights):采用机器学习、数据统计和数据可视化等方法从海量数据中找到人们并未发现的且有价值的信息的能力。数据科学强调的是数据洞见——发现数据背后的信息、知识和智慧以及找到“被淹没在海量数据中的未知数据”。与数据挖掘不同的是,数据科学项目的成果可以直接用于决策支持。数据洞见力的高低主要取决于主体的数据意识、经验积累和分析处理能力。

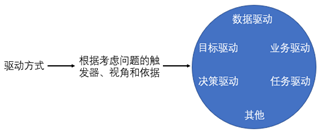

(10)数据驱动(data-driven):是相对于决策驱动、目标驱动、业务驱动和模型驱动的一种提法。数据驱动主要以数据为触发器(出发点)、视角和依据,进行观测、控制、调整和整合其他要素——决策、目标、业务和模型等,如图3所示。数据驱动是大数据时代的一种重要思维模式,也是业务数据化之后实现数据业务化的关键所在。

图3常用的驱动方式

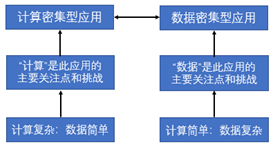

(11)数据密集型(data-intensive)应用:是相对于计算密集型应用、I/O密集型应用的一种提法,如图4所示。也就是说,数据密集型应用中数据成为应用系统研发的主要焦点和挑战。通常,数据密集型应用的计算比较容易,但数据具有显著的复杂性(异构、动态、跨域和海量等)和海量性。例如,当对PB级复杂性数据进行简单查询时,计算不再是最主要的挑战,而最主要挑战来自于数据本身的复杂性。

图4计算密集型应用与数据密集型应用的区别

(12)数据空间(data space):主体的数据空间——与主体相关的数据及其关系的集合。主体相关性和可控性是数据空间中数据项的基本属性。

(13)关联数据(linked data):一种数据发布和关联的方法。其中,数据发布是指采用资源描述框架(resource definition framework,RDF)和超文本传输协议(hypertext transfer protocol,HTTP)技术在Web上发布结构化信息;数据关联是指采用RDF链接技术在不同数据源中的数据之间建立计算机可理解的互连关系。2006年, Tim Berners Lee首次提出了关联数据的理念,目的在于不同资源之间建立计算机可理解的关联信息,最终形成全球性大数据空间。Tim Berners Lee进一步明确提出了关联数据技术中的数据发布和数据关联的4项原则:采用统一资源标识符(uniform resource identifier, URI)技术统一标识事物;通过HTTP URI访问URI标识;当URI被访问时,采用RDF和SPARQL(Simple Protocol and RDF Query Language)标准,提供有用信息;提供信息时,也提供指向其他事物的URI,以便发现更多事物。

除了上述概念之外,还有数据消减(data reduction)、数据新闻(data journalism)、数据的开放获取(open access)、数据质量、特征提取等传统概念也重新备受关注。

大数据生命周期管理

在大数据平台下,预处理的数据量非常大,而处理后的有效数据量往往比较小,因此,数据的生命周期管理显得非常重要。数据生命周期管理(data life-cycle management,DLM)是一种基于策略的方法,用于管理信息系统的数据在整个生命周期内的流动:从创建和初始存储,到它过时被删除。(图5)

图5大数据生命周期管理概述图

DLM产品将涉及的过程自动化,通常根据指定的策略将数据组织成各个不同的层,并基于那些关键条件自动地将数据从一个层移动到另一个层。作为一项规则,较新的数据和那些很可能被更加频繁访问的数据,应该存储在更快的,并且更昂贵的存储媒介上,而那些不是很重要的数据则存储在比较便宜的,稍微慢些的媒介上。数据生命周期管理的总体原则在数据的整个生命周期中,不同阶段的数据其性能、可用性、保存等要求也不一样。通常情况下,在其生命周期初期,数据的使用频率较高,需要使用高速存储,确保数据的高可用性。随着时间的推移,数据重要性会逐渐降低,使用频率会随之下降,应将数据进行不同级别的存储,为其提供适当的可用性、存储空间,以降低管理成本和资源开销。最终大部分数据将不再会被使用,可以将数据清理后归档保存,以备临时需要时使用。

编辑:黄飞

-

数据

+关注

关注

8文章

7002浏览量

88941 -

大数据

+关注

关注

64文章

8882浏览量

137396

原文标题:数据的基本概念!

文章出处:【微信号:数字化企业,微信公众号:数字化企业】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

智慧城市与大数据的关系

socket的基本概念和原理

使用CYW20829的BLE进行最大数据发送应用,BLE丢失数据如何解决?

BP网络的基本概念和训练原理

四路数据分配器的基本概念、工作原理、应用场景及设计方法

八路数据分配器的基本概念及工作原理

循环神经网络的基本概念

分布式存储与计算:大数据时代的解决方案

CYBT-343026传输大数据时会丢数据的原因?

浅析大数据时代下的数据中心运维管理

大数据技术是干嘛的 大数据核心技术有哪些

GPU:大数据时代的强力引擎

数据的基本概念!大数据时代的新术语

数据的基本概念!大数据时代的新术语

评论