大型语言模型(LLM)的出现标志着NLP的重大突破,导致文本理解和生成的显著进步。然而,除了这些进步,LLM还产生了幻觉现象,导致生成内容与现实世界的事实或用户输入不一致。这篇综述从LLM幻觉的分类开始,深入研究导致幻觉的因素。对幻觉检测方法和基准进行了全面概述。此外,还相应地介绍了缓解幻觉的代表性方法。最后分析了面临的挑战,突出了当前的局限性,并提出了开放问题。

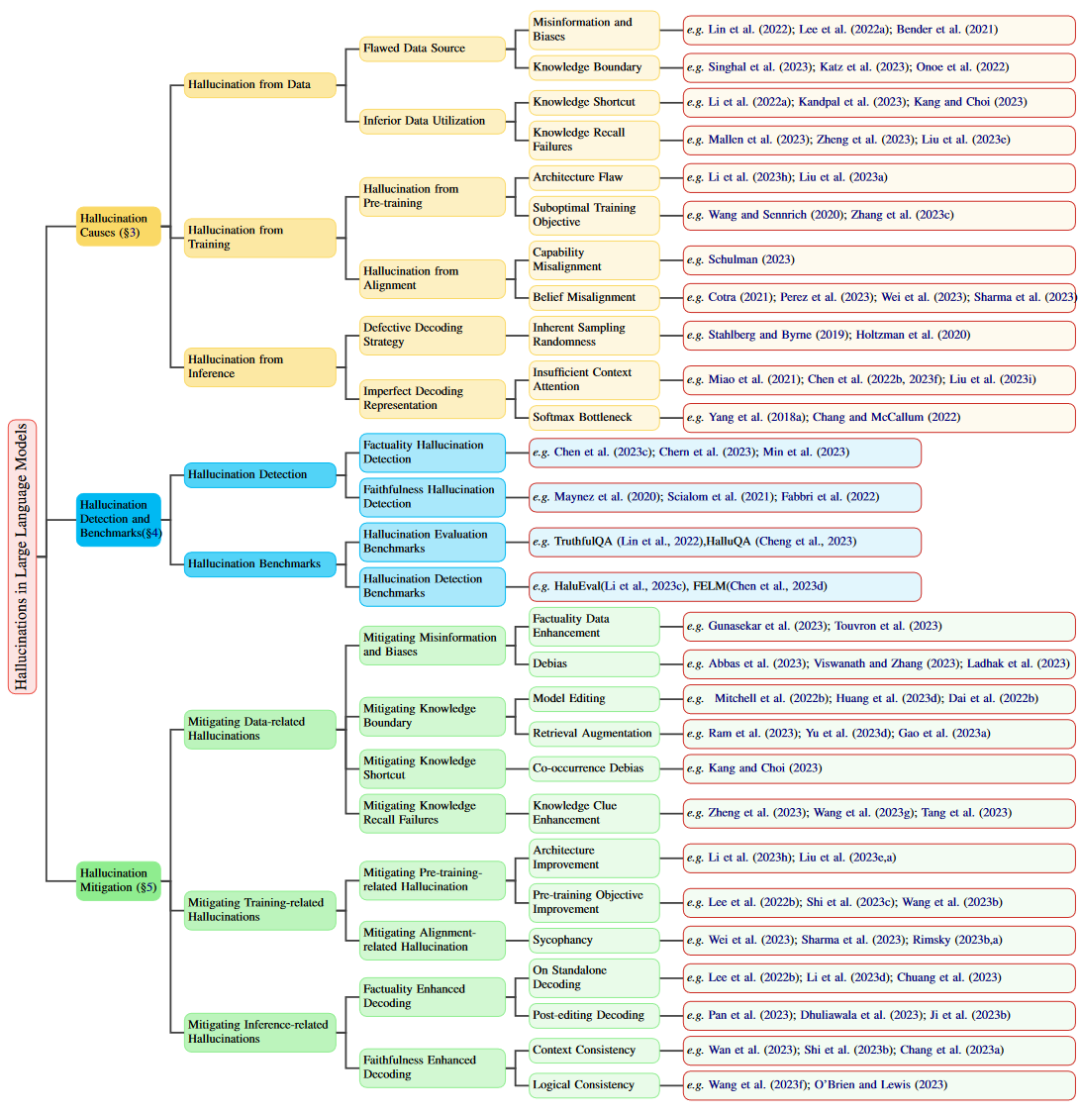

文中相关引用论文如下图所示:

背景介绍

最近,LLM的出现引领了NLP范式的转变,在语言理解和推理方面取得了前所未有的进步。然而,随着LLMs的快速发展,有一个令人担忧的趋势,即其产生幻觉的倾向,导致看似合理但实际上不支持的内容。

幻觉被描述为无意义或不忠实于所提供源内容的生成内容。根据与源内容的矛盾,这些幻觉又进一步分为内在幻觉和外在幻觉。在LLMs中,幻觉的范围包含了一个更广泛、更全面的概念,主要集中在事实错误上。本文重新定义了幻觉的分类,为LLM应用程序提供了一个更定制的框架。

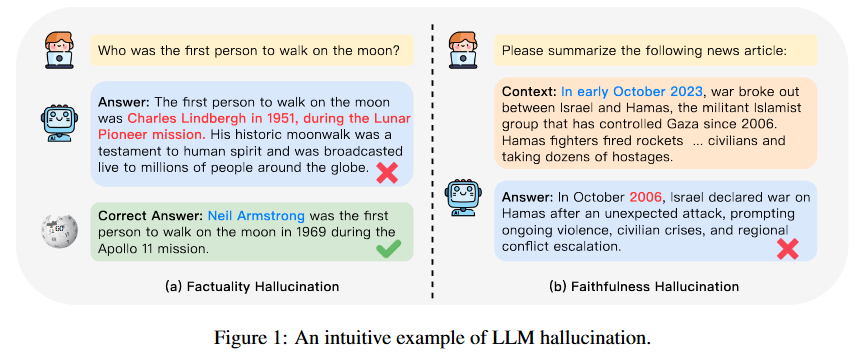

我们把幻觉分为两大类:事实幻觉和忠实幻觉。事实幻觉强调生成的内容与可验证的现实世界事实之间的差异,通常表现为事实不一致或捏造。如图1(a)所示,当被问及第一个在月球上行走的人是谁时,模型可能会断言是1951年的查尔斯·林德伯格。而事实是尼尔·阿姆斯特朗在1969年阿波罗11号任务中成为第一个在月球上行走的人。

忠实幻觉是指生成内容与用户指令或输入提供的上下文背离,以及生成内容内部的自一致性。如图1(b)所示,当模型被要求总结一篇新闻文章时,该模型不准确地生成了以色列和哈马斯之间冲突的实际事件日期。针对事实幻觉,我们根据可验证来源的内容将其进一步分为两类:事实不一致和事实捏造。为了保证可靠性,我们强调从用户的角度解决不一致性,将其分类为指令不一致性、上下文不一致性和逻辑不一致性,从而使其更好地与LLM的当前使用保持一致。

相关定义

大语言模型(LLM)

LLM是指一系列基于transformer的语言模型架构的通用模型,并在大量文本语料库上进行了广泛的训练,其中著名模型有GPT-3、PaLM、LLaMA、GPT-4等。通过扩展数据量和模型容量,llm提高了惊人的应急能力,通常包括上下文学习(ICL) (Brown等人,2020)、思维链提示(Wei等人,2022)和指令遵循(Peng等人,2023)。

LLMs的训练阶段

LLM经历的3个主要训练阶段:预训练、监督微调(SFT)和从人工反馈中强化学习(RLHF)。

预训练

语言模型在预训练期间,旨在自回归地预测序列中的下一个标记。通过在广泛的文本语料库上进行自监督训练,模型获得了语言语法、世界知识和推理的知识,为后续的微调任务提供了强大的基础。语言模型的本质在于预测下一个单词的概率分布。

监督微调

虽然LLM在预训练阶段获得了大量的知识,但预训练主要是为了完成优化。因此,预训练的LLM基本上充当了补全机器,这可能会导致LLM的下一个单词预测目标和用户获得所需响应的目标之间的不一致。为了弥补这一差距引入SFT ,其中涉及使用精心注释的(指令,响应)对集进一步训练LLM,从而增强LLM的能力和改进的可控性。

人类反馈的强化学习

虽然SFT过程成功地使LLM能够遵循用户指示,但它们仍然有空间更好地与人类偏好保持一致。在利用人类反馈的各种方法中,RLHF脱颖而出,成为一种通过强化学习来符合人类偏好的研究解决方案。通常,RLHF采用了一个偏好模型,该模型经过训练可以在给定提示和人工标记的反应情况下预测偏好排名。为了与人类偏好一致,RLHF优化LLM,以生成最大化训练偏好模型提供的奖励的输出,通常采用强化学习算法,如近端策略优化。

LLMs的幻觉

幻觉通常指的是生成的内容看起来荒谬或不忠实于提供的源内容的现象。一般来说,自然语言生成任务中的幻觉可以分为两种主要类型:内在幻觉和外在幻觉。具体来说,内在幻觉属于与源内容冲突的输出。相反,外在幻觉指的是无法从源内容中验证的输出。

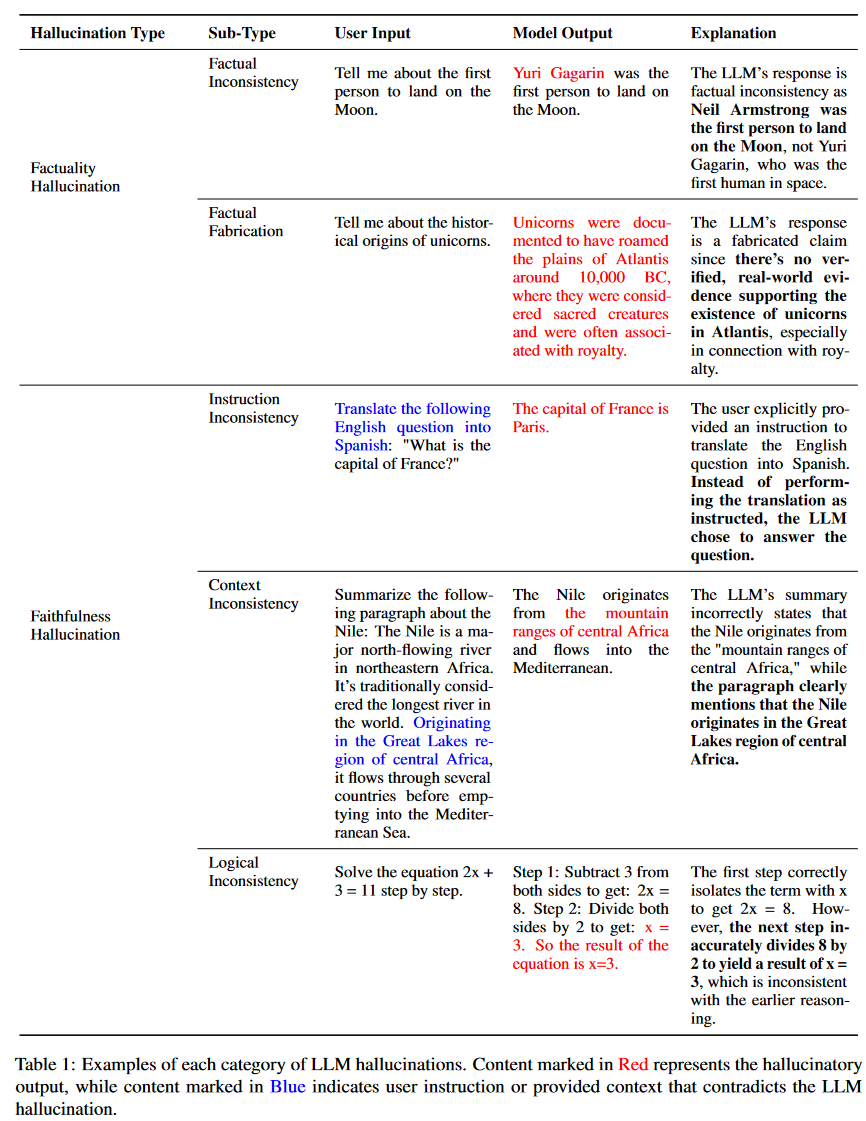

考虑到LLMs非常强调以用户为中心的交互,并优先考虑与用户指令保持一致,再加上它们的幻觉主要出现在事实层面,我们引入了更细粒度的分类法。为了更直观地说明我们对LLM幻觉的定义,我们在表1中给出了每种幻觉的例子,并附有相应的解释。

具体分类如下:

事实幻觉

现有的LLM偶尔会表现出产生与现实世界事实不一致或可能具有误导性的输出的趋势,这对人工智能的可信性构成了挑战。在这种情况下,我们将这些事实性错误归类为事实性幻觉。根据生成的事实内容是否可以根据可靠来源进行验证,它们可以进一步分为两种主要类型:

事实不一致性:指LLM的输出包含可以基于现实世界信息的事实,但存在矛盾的情况。这种类型的幻觉发生得最频繁,并且来自不同的来源,包括LLM对事实知识的捕捉、存储和表达。

事实捏造:指LLM的输出包含无法根据既定的现实世界知识进行验证的事实的实例。

忠实幻觉

随着LLM的使用转向更以用户为中心的应用程序,确保它们与用户提供的指令和上下文信息的一致性变得越来越重要。此外,LLM的忠实还体现在其生成内容的逻辑一致性上。从这个角度出发,我们将忠实幻觉分为三种类型:

指令不一致:指LLM的输出偏离用户指令。虽然一些偏差可能符合安全指导原则,但这里的不一致表示无意中与非恶意用户指令不一致。

上下文不一致:指向LLM的输出与用户提供的上下文信息不一致的实例。

逻辑不一致:通常在推理任务中观察到,LLM输出表现出内部逻辑矛盾。这表现为推理步骤本身之间以及步骤和最终答案之间的不一致。

产生幻觉的原因

来自数据的幻觉

预训练数据是LLM的基石,使它们能够获得泛化能力和事实知识。然而,它可能在不经意间成为LLM幻觉的来源。这主要表现在两个方面:有缺陷的数据源,以及对数据中捕获的事实知识的低劣利用。

有缺陷的数据源

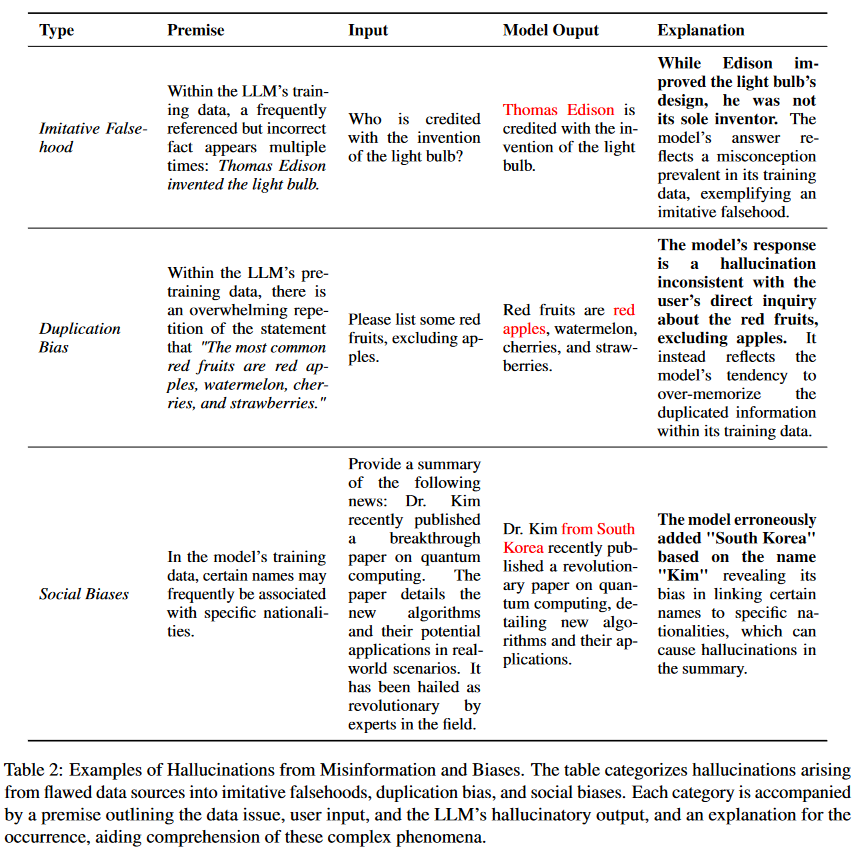

当扩大预训练数据大大提高了LLM的能力,但在保持一致的数据质量方面出现了挑战,这可能会引入错误信息和偏差。此外,特定领域知识和数据中最新事实的缺乏会导致LLM形成知识边界,这为特定场景中的LLM带来了限制。基于此,主要将可能导致幻觉的因素分为错误信息、偏见和知识边界限制。为了更全面地理解,表2列出了每种数据导致的幻觉的示例。

错误信息和偏见:随着对大规模语料库需求的日益增长,启发式数据收集方法被用于高效地收集大量数据,增加了模仿虚假信息的风险。在提供大量数据的同时,它们可能无意中引入错误信息。此外,社会偏见可能无意中引入到LLM的学习过程。这些偏见主要包括重复偏见和各种社会偏见。

模仿虚假信息:LLMs预训练的主要目标是vwin 训练分布。当LLMs在事实不正确的数据上进行训练时,它们可能无意中放大这些不准确性,可能导致事实不正确的幻觉,称为"模仿性虚假信息" 。

重复偏差:LLMs具有记忆训练数据的内在倾向,这种记忆趋势随着模型大小的增加而增长。然而,在预训练数据中存在重复信息的背景下,固有的记忆能力变得有问题。这种重复可能会使LLM从泛化转向记忆,最终导致重复偏差,即LLM对重复数据的召回过于优先,导致偏离所需内容的幻觉。

社会偏见:某些偏见本质上与幻觉有关,特别是与性别和国籍有关的偏见。

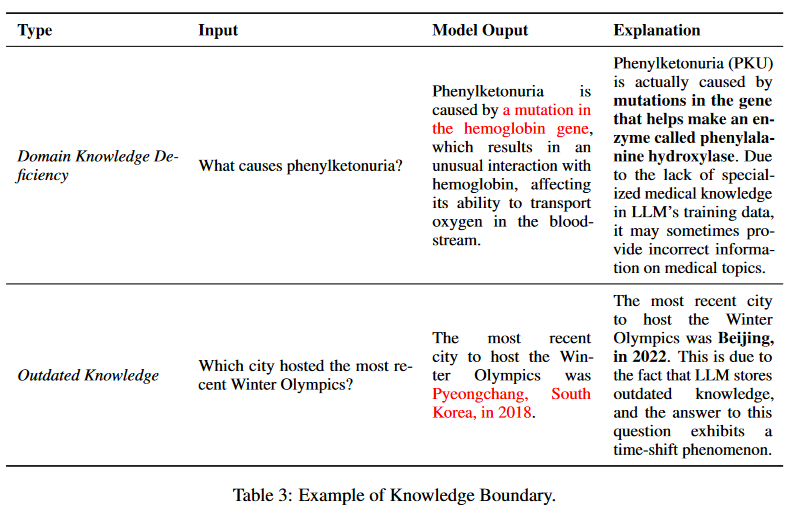

知识边界:虽然庞大的预训练语料库使LLM具有广泛的事实知识,但它们本质上具有边界。这种限制主要表现在两个方面:缺乏最新的事实知识和专业领域知识。表3给出了一个例子。

域内知识缺乏:LLM在通用领域的广泛下游任务中表现出了卓越的性能。然而,鉴于这些通用LLM主要是在广泛的公开数据集上训练的,在特定领域的专业知识内在地受到缺乏专有训练数据的限制。

过时的事实知识:除了特定领域知识的不足之外,关于LLM知识边界的另一个内在限制是其最新知识的能力有限。LLM中嵌入的事实知识表现出明确的时间边界,并可能随着时间的推移而过时。

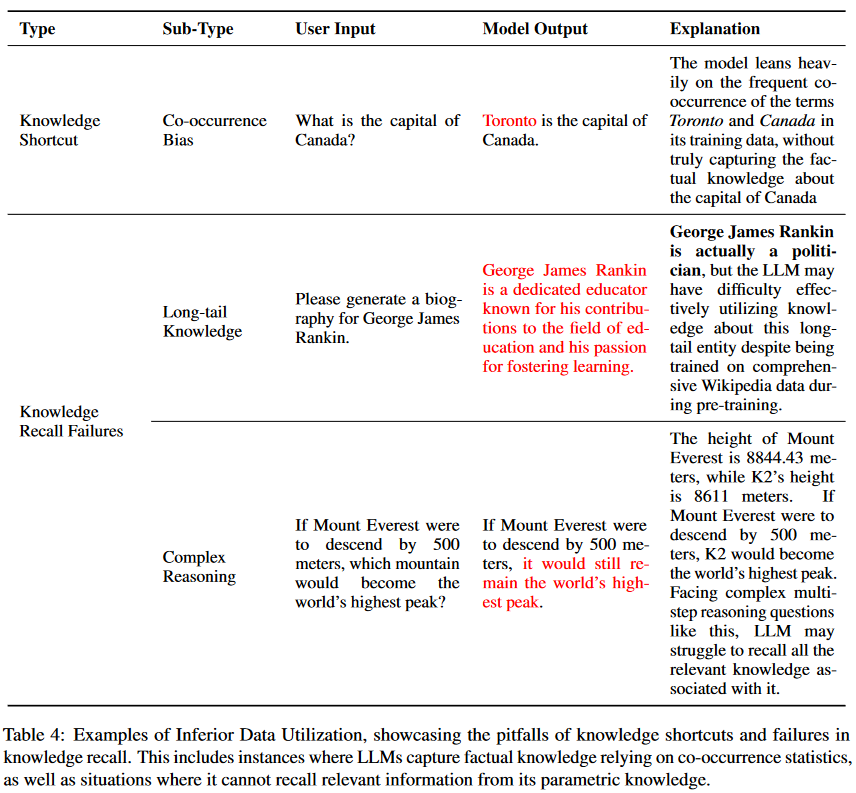

数据利用率低下

预训练数据体现了丰富的现实世界事实知识,使LLM能够在其参数中捕获并随后编码大量事实知识。然而,尽管有这么庞大的知识储备,由于参数化知识的低劣利用,仍然可能产生知识诱导的幻觉。表4列出了与劣质数据利用相关的每种幻觉类型的例子。

知识捷径:LLM捕获事实知识的确切机制仍然难以捉摸。最近的研究指出,LLM不是真正理解事实知识的复杂性,而是经常求助于捷径。它们表现出过度依赖预训练数据中的位置接近、共生统计和相关文档计数的趋势,这可能会引入对虚假相关性的偏差,如果偏差反映了事实不正确的信息,可能导致幻觉。

知识召回失败:当LLM难以有效利用其广泛的知识时,就会出现幻觉。本文探讨了知识召回中的两个主要挑战:记忆长尾知识的不足,以及在需要多跳推理和逻辑推理的复杂场景中的困难。

长尾知识:长尾知识的特点是在预训练数据中相对稀少,为LLM提出了固有的挑战,主要依赖共现模式来记忆事实知识。

复杂场景:在多跳问答场景中,由于其推理的局限性,即使LLM拥有必要的知识,如果问题之间存在多种关联,则可能难以产生准确的结果。此外,研究人员揭示了LLM中被称为逆转诅咒的特定推理失败。具体来说,虽然当问题表述为“A是B”时,模型可以正确回答,但当被问及相反的“B是A”时,它表现出了失败的逻辑推理。这种推理上的差异超出了简单的推论。

来自训练的幻觉

LLM的训练过程主要包括两个主要阶段:1)预训练阶段,其中LLM学习通用表示并捕获世界知识,以及2)对齐阶段,LLM被调整以更好地与用户指令和偏好保持一致。

来自预训练的幻觉

预训练是基础阶段,通常采用基于transformer的架构在大量语料库上进行因果语言建模。然而,与幻觉有关的问题可能来自固有的结构设计和所采用的特定训练策略。在本节中,我们深入研究了结构缺陷和曝光偏差的影响所带来的挑战。

结构缺陷:LLM通常采用基于transformer的架构,遵循GPT建立的范式,通过因果语言建模目标获得表示,该框架以OPT、Falcon和Llama-2等模型为例。尽管取得了成功,但它也并非没有缺陷,特别是在单向表示不足和注意力缺陷方面。

单向表示不充分:遵循因果语言建模范式,LLM仅基于前面的token,以从左到右的方式预测后面的token。这种单向建模在促进高效训练的同时,也有其局限性。它只利用单一方向的上下文,这阻碍了其捕捉复杂上下文依赖关系的能力,潜在地增加了幻觉出现的风险。

注意力缺陷:基于transformer的架构,配备了自注意力模块,在捕捉长程依赖关系方面表现出了非凡的能力。然而,无论模型规模如何,它们在算法推理的背景下偶尔会出现不可预测的推理错误,包括长短程依赖关系。一个潜在的原因是软注意力的局限性,随着序列长度的增加,注意力在各个位置上稀释。

曝光偏差:除了结构缺陷,训练策略也发挥了至关重要的作用。暴光偏差现象是由于自回归生成模型中的训练和推理之间存在差异。在训练过程中,这些模型通常采用教师模型的最大似然估计(MLE)训练策略,其中提供真实值作为输入。然而,在推理过程中,模型依赖于自己生成的内容来进行后续的预测,这种不一致性会导致幻觉。

来自对齐的幻觉

对齐通常涉及两个主要过程,即监督微调和从人类反馈中强化学习。虽然对齐显著提高了LLM响应的质量,但它也引入了幻觉的风险。我们将与幻觉相关的对齐缺陷分为两部分:能力偏差和信念偏差。

能力未对齐:考虑到LLM在预训练过程中建立了固有的能力边界,SFT利用高质量的指令及其相应的响应来让LLM遵循用户指令,释放他们在此过程中获得的能力。然而,当来自校准数据的需求超过预定义的能力边界时,LLM被训练产生超出其自身知识边界的内容,从而放大了幻觉的风险。

观点未对齐:LLM的激活封装了与其生成的真实性相关的内部观点。然而,在这些观点和生成的输出之间偶尔会出现不一致。即使通过人类反馈进行了改进,有时也会产生与内在观点不同的输出。这种行为被称为谄媚,强调了模型倾向于安抚人类评估者,往往以牺牲真实性为代价。

来自推理的幻觉

解码在体现LLM预训练和对齐后的能力方面起着重要作用。然而,解码策略中的某些缺陷可能会导致LLM幻觉。解码过程的两个潜在原因是解码策略的固有随机性和不完美的解码表示。

解码抽样的随机性

随机抽样是目前LLMs采用的主流解码策略。将随机性纳入解码策略的原因在于认识到高似然序列往往会导致令人惊讶的低质量文本,这被称为似然陷阱。解码策略中的随机性带来的多样性是有代价的,因为它与幻觉风险的增加呈正相关。采样温度的升高导致更均匀的token概率分布,增加了从分布尾部采样频率较低的token的可能性。因此,这种对不经常出现的token进行采样的倾向加剧了幻觉的风险。

不完美的解码表示

在解码阶段,LLM使用顶层表示来预测下一个token。然而,顶层表示有其局限性,主要表现在两个方面:上下文注意力不足和Softmax瓶颈。

上下文注意力不足:之前的研究,特别是在机器翻译和摘要等领域,强调了使用编码器-解码器架构的生成模型的过度自信问题。这种过度自信源于过度关注部分生成的内容,通常优先考虑流畅性,而不是忠实地遵循源上下文。虽然主要采用因果语言模型架构的大型语言模型已得到广泛使用,但过度自信现象仍然存在。在生成过程中,对下一个词的预测同时取决于语言模型上下文和部分生成的文本。然而,语言模型在注意力机制中往往表现出局部焦点,优先考虑附近的单词,从而导致上下文注意力的显著缺陷。这种注意力不足会直接产生忠实度幻觉问题,其中模型输出的内容偏离了原始上下文。

Softmax瓶颈:大多数语言模型使用softmax层,该层与词嵌入一起对语言模型中的最终层表示进行操作,以计算与单词预测相关的最终概率。然而,基于Softmax的语言模型的有效性受到公认的Softmax瓶颈的限制,其中将Softmax与分布式词嵌入结合使用,在给定上下文的情况下,限制了输出概率分布的表达能力,这阻止了语言模型输出所需的分布引入了幻觉的风险。

幻觉检测和基准

幻觉检测

检测LLM中的幻觉对于确保生成内容的可靠性和可信性至关重要。传统的衡量标准主要是基于词的重叠,无法区分合理内容和幻觉内容之间的细微差异。鉴于这些幻觉的不同性质,检测方法也会有所不同。

事实幻觉检测

针对事实幻觉的检测方法通常分为检索外部事实和不确定性估算。

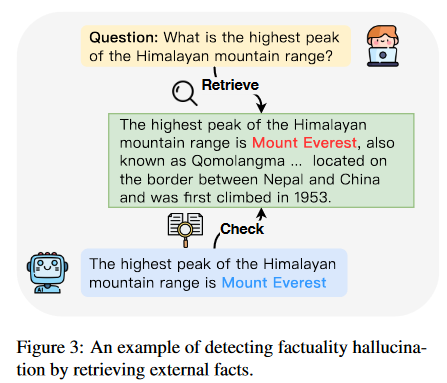

检索外部事实:为了有效查明LLM输出中的事实不准确性,一种直观的策略涉及将模型生成的内容与可靠的知识源进行比较,如图3所示。然而,传统的事实核查方法经常纳入简化的实用性假设,在应用于复杂的现实场景时,会导致差异。认识到这些限制,研究人员更加强调现实世界的场景。他们开创了一个集成多个组件的全自动管道:断言分解、原文档检索、细粒度检索、基于断言的摘要和准确性分类。

一些方法通过引入了FACTSCORE,一种专门用于长文本生成的细粒度事实指标。它将生成内容分解为原事实,然后计算可靠知识源支持的百分比。最近,研究人员通过查询扩展增强了检索幻觉检测支持证据的标准方法。通过在检索过程中将原始问题与LLM生成的答案相结合,解决了主题偏航的问题,确保检索到的段落与问题和LLM的响应一致。

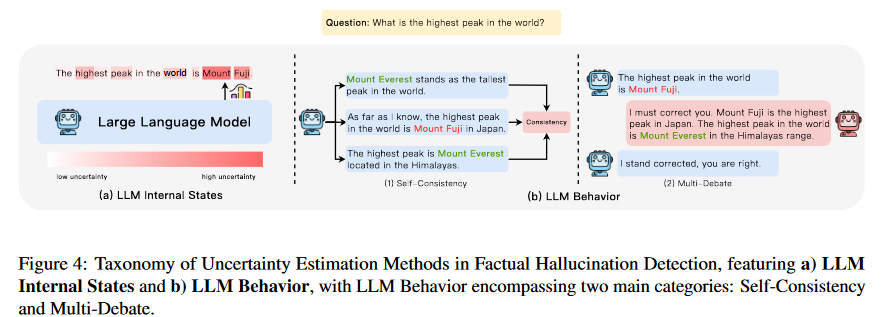

不确定性估算:虽然许多幻觉检测方法依赖外部知识进行事实核查,但已有一些方法用来解决零资源环境下的这个问题,从而消除了检索的需要。这些策略背后的基本前提是,LLM幻觉的起源本质上与模型的不确定性有关。因此,通过估计模型生成的事实内容的不确定性,检测幻觉变得可行。不确定性估计方法大致可以分为两类:基于内部状态的方法和基于LLM行为的方法,如图4所示。前者的运行假设是人们可以访问模型的内部状态,而后者则泛化到更受限的环境,仅利用模型的可观察行为来推断其潜在的不确定性。

LLM的内部状态:LLM的内部状态可以作为其不确定性的信息性指标,通常通过token概率或熵等指标表现出来。通过考虑这些概念中的最小token概率来确定模型对量化的关键概念的不确定性。其基本原理是,低概率作为模型不确定性的有力指标,受概念中存在的高概率token的影响较小。类似地,另一种方法采用了一种基于自我评估的方法来进行不确定性估计,其依据是,语言模型从其生成的解释中熟练地重建原始概念的能力表明其对该概念的熟练程度。首先促使模型为给定概念生成解释,然后利用约束解码使模型根据其生成的解释重新创建原始概念,从响应序列中获得的概率分数可以作为该概念的熟悉度分数。此外,另一种方法通过对抗性攻击的视角来解释幻觉。利用基于梯度的token替换,设计了诱导幻觉的提示。值得注意的是,与来自对抗性攻击的token相比,从原始提示生成的第一个token通常表现出低熵。

LLM行为:然而,当系统只能通过API调用访问时,可能无法访问输出的标记级概率分布。鉴于这种限制,一些研究已经将重点转移到探索模型的不确定性上,或者通过自然语言提示以检查其行为表现。例如,通过对LLM对同一提示的多个响应进行采样,通过评估事实陈述之间的一致性来检测幻觉。然而,这些方法主要依赖于直接查询,明确地从模型中请求信息或验证。受调查性访谈的启发,可以使用间接查询。与直接问题不同,这些间接问题通常提出开放式问题,以引出具体信息。通过使用这些间接查询,可以更好地评估多个模型生成的一致性。除了从单个LLM的多代的自一致性来评估不确定性之外,还可以通过合并其他LLM来拥抱多智能体的视角。

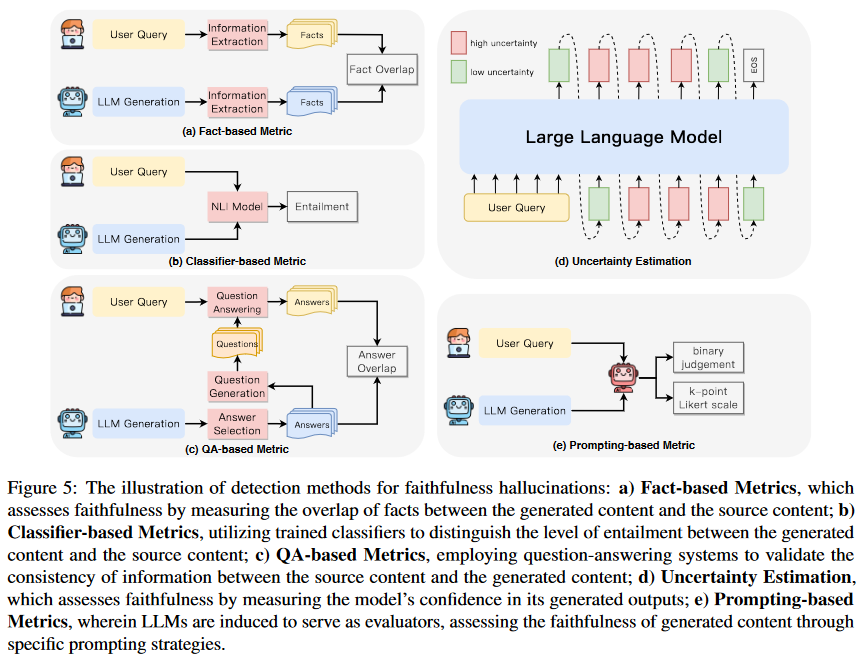

忠实幻觉检测

确保LLM忠实地提供上下文或用户指令,对于它们在无数应用中的实际效用至关重要。忠实度幻觉检测主要关注于确保生成的内容与给定的上下文相一致,避开无关或矛盾输出的潜在陷阱。在本节中,我们将探索在LLM中检测不忠实的方法,并提供图5中的概述。

基于事实的指标:在评估忠实度的领域中,最直观的方法之一涉及测量生成的内容和源内容之间关键事实的重叠度。考虑到事实的不同表现形式,可以根据实体、关系三元组和知识对度量进行分类。

基于N-gram:当将源内容作为参考时,传统的基于N-gram重叠度的评价指标,如ROUGE和PARENT-T,也可以用于评估忠实度。

基于实体:基于实体重叠的指标普遍应用于摘要任务,因为这些关键实体的遗漏或不准确的生成都可能导致不忠实的摘要。

基于关系:即使实体匹配,它们之间的关系也可能是错误的。因此,更应该关注关系元组的重叠,该类标准使用经过训练的端到端事实提取模型来计算提取的关系元组的重叠。

基于知识:在以知识为基础的对话任务中,事实往往与对话中呈现的知识相对应。知识指标F1,用以评估模型的生成与提供的知识的匹配程度。

基于分类器的指标:除了计算事实重叠度之外,评估模型忠实度的另一种直接方法涉及分类器,这些分类器包括特定任务的幻觉内容和忠实内容,以及相关任务的数据或合成的数据。它可以大致分为以下几种类型:

基于Entailment:许多研究在NLI数据集上训练了分类器,以识别事实不准确性,特别是在抽象摘要的背景下。然而,传统NLI数据集与不一致检测数据集之间的输入粒度不匹配限制了它们有效检测不一致的适用性。在此基础上,更先进的研究提出了一些方法,如对抗性数据集的微调,在依赖acr级别分解隐含决策,以及将文档分割成句子单位,然后在句子对之间汇总分数等方法。

弱监督:虽然使用相关任务的数据来微调分类器在评估准确率方面显示出了希望,但认识到相关任务和下游任务之间的固有差距是至关重要的。为了应对这一挑战,一种使用基于规则的转换来创建弱监督数据以微调分类器的方法被提出。同时,研究人员设计了一种自动生成标记级幻觉数据并执行标记级幻觉检测的方法。

基于问答的指标:与基于分类器的指标相比,基于QA的指标因为它们增强了捕捉模型生成与其来源之间信息重叠的能力受到了关注。这些指标通过从LLM输出内的信息单元中初步选择目标答案进行操作,然后由问题生成模块生成问题。这些问题随后用于根据用户上下文生成源答案。最后,通过比较源和目标答案的匹配分数来计算LLM答案的忠实度。

不确定性估计:有条件文本生成中的幻觉与模型的高度不确定性密切相关。

基于熵:数据到文本生成中的幻觉可能性和预测不确定性之间存在正相关,这是通过深度集成估计的。此外,利用蒙特卡罗Dropout产生的假设方差作为神经机器翻译(NMT)中的不确定性度量。最近,特有方法使用条件熵评估生成式摘要的模型不确定性。

基于对数概率:使用长度归一化序列对数概率来度量模型置信度。

基于模型:使用SelfCheck专注于复杂推理中的错误检测。该系统通过目标提取、信息收集、步骤再生和结果比较的简化过程来聚合置信度分数,从而提高问答的准确性。

基于提示的指标:LLM卓越的指令能力突出了其自动评估的潜力。利用这种能力,研究人员已经冒险采用新的范式来评估模型生成内容的忠实度。通过为LLM提供具体的评估指南,并向它们提供模型生成的和源内容,它们可以有效地评估忠实度。最终的评估输出可以是忠实度的二元判断,也可以是表示忠实度的k点李克特量表。对于提示选择,评估提示可以是直接提示、思维链提示,使用上下文学习,或允许模型生成带有解释的评估结果。

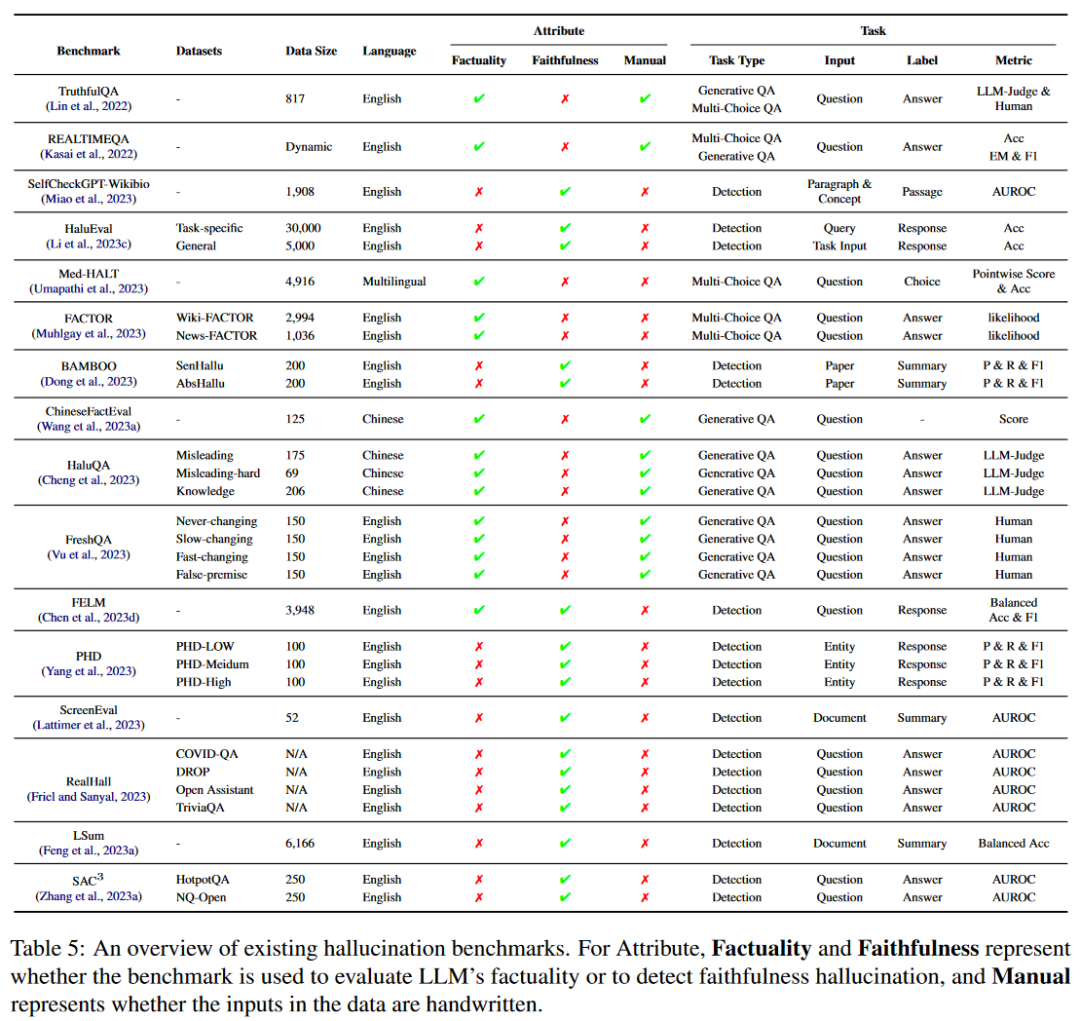

基准

幻觉基准可以分为两个主要领域:幻觉评估基准,评估现有前沿LLM产生的幻觉程度;以及幻觉检测基准,专门用于评估现有幻觉检测方法的性能。

幻觉评估基准

幻觉评估基准是为了评估LLMs产生幻觉的倾向而设计的,特别强调识别事实的不准确性和测量与原始环境的偏差。目前,这些基准的主要焦点是评估生成内容的真实性。TruthfulQA:包含817个问题,涵盖健康、法律、金融和政治等38个不同类别,是专门设计用于评估语言模型真实性的基准。它使用一种对抗性的方法,旨在引出“模仿谬误”——由于模型在训练数据中频繁出现而可能产生的误导性反应。基准测试分为两部分,其中一部分包含人工筛选的问题,通过过滤掉GPT-3正确回答的问题,进一步筛选出437个问题。另一部分包括380个未经过滤的非对抗性问题。对于评估,TruthfulQA提供了两种类型的问答任务:生成和选择题,并采用人工评估来衡量模型的真实性和信息性。此外,该基准还引入了一个名为GPT-judge的自动度量,该度量在6.7B GPT-3模型上进行了微调。

REALTIMEQA:考虑到世界知识是不断发展的,验证LLMs关于当前世界的真实性就变得至关重要。这个基准提供了实时的开放域选择题,这些选择题来源于新发布的新闻文章,涵盖了政治、商业、体育和娱乐等多种主题。此外,该基准还提供了一个实时评估的平台,可以通过准确度评估的多项选择格式,也可以使用精确匹配和基于token的F1指标评估生成设置。

Med-HALT:鉴于幻觉在医学领域对患者护理的重要性,该基准强调了医学领域特定于LLM的挑战。Med-HALT结合了来自不同国家的多项选择,旨在评估LLMs在医学背景下的推理和记忆。推理任务有18,866个样本,通过使用医学多项选择题测试LLM区分不正确或不相关选项和假问题的能力。同时,由4916个样本组成的记忆任务,评估了LLM通过从PubMed摘要/标题生成链接或从给定链接和PIMDs生成标题来召回和生成准确事实信息的能力。对于评估,LLM的表现由它们在测试问题上的准确性或逐点分数来衡量,该分数既考虑正确答案的积极分数,也考虑错误答案的消极惩罚。

FACTOR:为了定量评估语言模型的真实性,出现了通过扰动指定语料库中的事实陈述来自动创建基准的方法。产生了两个基准测试:Wiki-FACTOR和News-FACTOR。具体来说,对于给定的前缀文本,语料库中的原始补全作为事实正确的答案。然后用包含特定错误类型的提示来指导InstructGPT生成非事实的完成。这些生成的回答随后被过滤流畅和自我一致性,作为多项选择任务的基础。

ChineseFactEval:通过收集来自常识、科学研究、医学、法律、金融、数学和中国近代史等不同领域的问题,ChineseFactEval使用125个问题来评估六个当代中国llm的事实能力,以及GPT-4。在评估中,问题根据各种LLM实现的准确性进行分类,不同难度的问题分配不同的分数。所有LLM的响应主要由人工注释,由FacTool补充,然后使用最终分数来评估它们的真实性。

HalluQA:借鉴了TruthfulQA的构建方法,旨在专门评估中国LLM中的幻觉,侧重于模仿性的谎言和事实错误。该基准由30个领域的450个手工制作的对抗性问题组成,分为两部分。误导部分捕获了成功欺骗GLM-130B的问题,而知识部分保留了ChatGPT和Puyu一致回答错误的问题。为了进行评估,LLM生成这些问题的答案,然后使用GPT-4将这些答案与正确答案进行比较,以确定答案是否包含幻觉。

FreshQA:认识到幻觉可能部分源于过时知识,引入了该基准来评估现有LLM的真实性。该基准包括600个手工设计的问题,其答案可能随着时间的推移而变化,或其前提实际上不正确,该基准主要评估LLM快速变化知识的能力以及识别具有错误前提的问题的能力。在评估方面,该基准提供了两种模式的评估过程:RELAXED和STRICT,前者只评估原始答案的正确性,后者进一步评估答案中每个事实的正确性。

幻觉检测基准

对于幻觉检测基准,大多数之前的研究主要集中在特定任务的幻觉上。然而,这些研究中产生的内容往往来自能力较弱的模型,如BART和PEGASUS。因此,它们可能不能准确地反映幻觉检测策略的有效性。

SelfCheckGPT-Wikibio:基于维基生物数据集的概念,使用GPT-3生成合成维基百科文章,引入了一个句子级的幻觉检测数据集。然后对这些段落的真实性在句子一级进行人工注释,总共为238篇文章生成了1908个句子。

HaluEval:为了评估LLM识别幻觉的能力,使用自动生成和人工注释相结合的方式构建,产生了5000个一般用户查询与ChatGPT响应以及30000个特定任务样本。自动生成采用了“先采样再过滤”的方法。该基准利用问答、基于知识的对话和文本摘要等特定任务的数据集,首先使用ChatGPT根据与任务相关的幻觉模式对多层面的幻觉答案进行采样,然后用ChatGPT选择最可信的幻觉样本。

BAMBOO:该基准引入了两个新的数据集SenHallu和AbsHallu,旨在检测长文本背景下的幻觉。这些数据集是通过诱导ChatGPT在给定学术论文的情况下产生幻觉来构建的。

FELM:该基准评估了五个领域的真实性:世界知识、科学和技术、数学、写作和推荐以及推理。虽然早期的研究有意地根据特定的模式诱导LLM产生幻觉,但该基准使用ChatGPT在零样本设置中产生响应,共产生817个样本(包括3948个片段)。每个段都标注了事实性、错误原因、错误类型和外部引用。作为事实性检测器的测试平台,该基准采用F1得分和平衡分类精度来评估片段和响应级别的事实性错误。

PHD:该基准强调的不是句子级的幻觉检测,而是篇章级的检测。基准的构建首先从Wikipedia转储中提取实体,然后使用ChatGPT生成段落。当LLM缺乏足够的知识时,通常会出现事实错误,因此基准测试根据谷歌搜索返回的相关项的数量来选择实体。

ScreenEval:该基准将范围扩展到长格式对话中的事实不一致。基于SummScreen数据集,该数据集包括电视脚本和人工制作的摘要,该基准测试在句子级别为Longformer和GPT-4生成的摘要引入事实不一致注释,从而得到包含52个文档和624个摘要句子的数据集。在评估方面,使用AUROC评分在此基准上对幻觉检测方法进行评估。

RealHall:该基准的构建遵循以下原则:幻觉检测基准中的任务应该对LLMs提出实质性的挑战,并与现实世界的应用相关,同时确保多样性的广度。与此一致,基准测试将重点放在问答任务上,根据提示中参考文本的可用性将其分为Closed和Open组。基准测试中的每个问题最初都使用ChatGPT生成响应,随后通过涉及人工注释、GPT4评估和基于规则的自动评估的组合方法为这些响应分配布尔真值标签。使用AUROC评分对应用于该基准的幻觉检测方法的有效性进行量化。

LSum:基准集中在LLMs摘要任务中的事实一致性检测上。该基准基于XSum,包括使用来自GPTfamily、GLM-family和LLaMA家族的各种LLM生成摘要,并使用ChatGPT和GPT4在句子层面对事实一致性进行注释,总共有6166个注释摘要。

SAC3:该基准测试包括两个数据集:HotpotQA-halu和NQopen-halu。这些数据集分别从HotpotQA和NQ-open的训练集中抽取250个样本来构建。然后用GPT-3.5涡轮增压产生幻觉答案。然后,对答案进行人工注释,将其与基础事实和相关知识来源进行比较。

缓解幻觉

缓解与数据相关的幻觉

与数据相关的幻觉通常是偏见、错误信息和知识差距的原因,这些基本都植根于训练数据。

缓解错误信息和偏差

为了减少错误信息和偏见的存在,最直观的方法是收集高质量的事实数据以防止引入错误信息,并进行数据清洗以消除偏见。

增强事实数据:最直接的方法是手动管理预训练数据集。然而,随着预训练数据集的不断扩展,人工管理成为一个挑战。考虑到学术或专业领域的数据通常是事实准确的,收集高质量的数据成为主要策略。

消除偏见:预训练数据的偏见可分为重复偏见和社会偏见,每种都需要不同的消除偏见的方法。

重复偏见:通常分为完全重复和近似重复。对于完全重复项,最直接的方法包括精确子字符串匹配,以识别相同的字符串。然而,考虑到预训练数据的庞大,这个过程可能是计算密集型的。此外,一种更有效的方法利用后缀数组的构造,能够在线性时间内有效地计算大量子字符串查询。关于近似重复,识别通常涉及近似全文匹配,通常使用基于哈希的技术来识别具有显著N-gram重叠的文档对。

社会偏见:当前的主流解决方案严重依赖于精心策划的培训语料库。通过仔细选择多样化、平衡和代表性的训练数据,我们可以减轻偏见,可能会引发幻觉。此外,还引入了工具包,使用户能够消除现有模型和自定义模型的偏见。

缓解知识边界

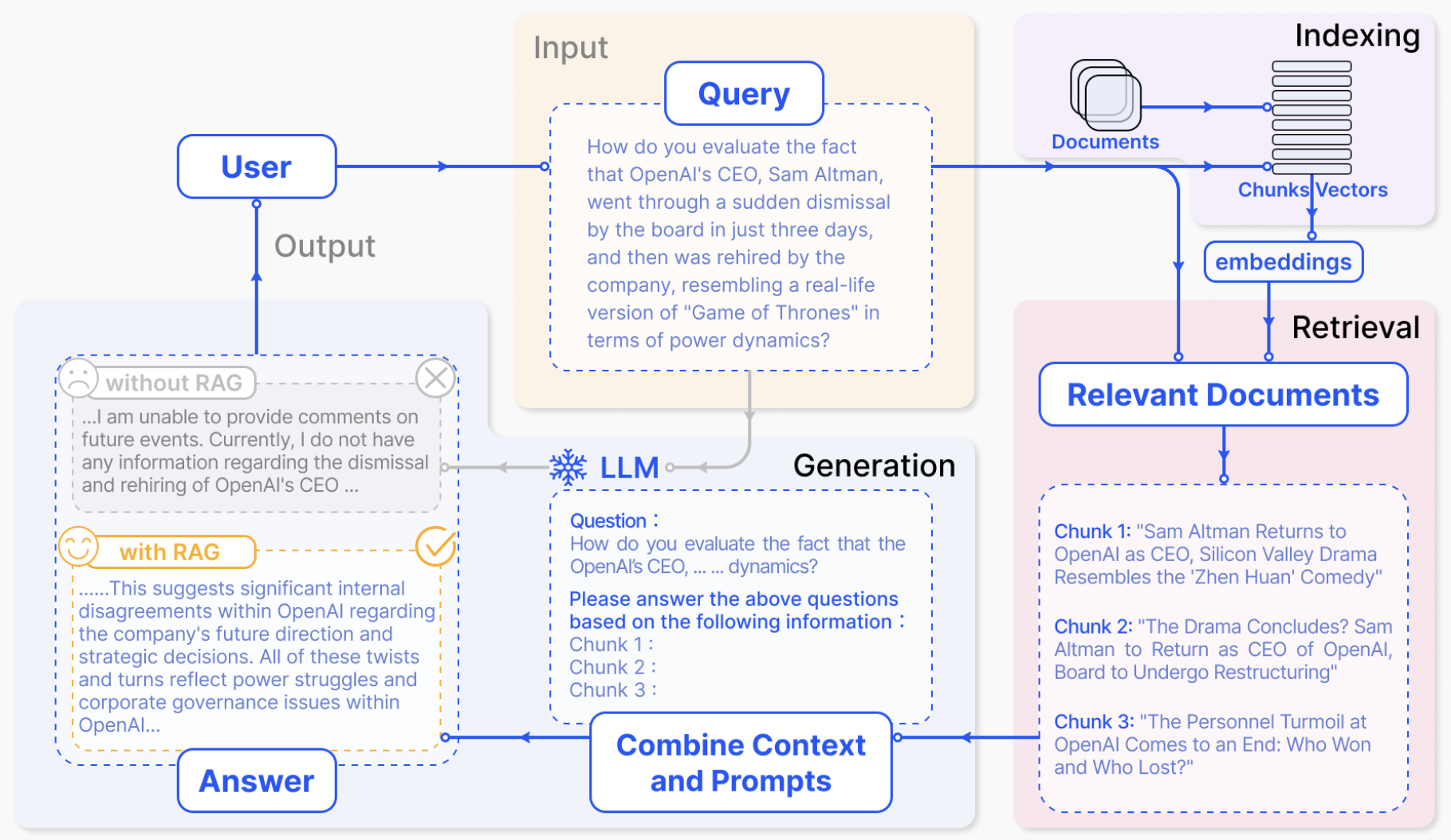

受训练数据的覆盖范围和时间边界的限制,不可避免地形成知识边界。通常有两种方法解决这一问题,一是知识编辑,旨在直接编辑模型参数以弥合知识鸿沟。另一种通过检索增强生成(RAG)利用非参数知识源。

知识编辑:目的是通过纳入额外的知识来纠正模型行为。当前的知识编辑技术可以修复事实性错误和刷新过时的信息以缓解知识鸿沟,可分为两类:通过修改模型参数改变模型的行为或使用外部模型插件冻结原始模型。

修改模型参数:这类技术直接将知识注入到原始模型中,导致模型输出的实质性改变,这可以进一步分为定位后编辑方法和元学习方法。定位后编辑方法由两个阶段组成,首先定位模型参数中“有bug的”部分,然后对它们进行更新以改变模型的行为。元学习方法训练一个外部超网络来预测原始模型的权重更新。然而,元学习方法往往需要额外的训练和记忆成本,需要专门的设计来减小llm时代超网络的规模(如低秩分解)。虽然这些方法可以细粒度地调整模型的行为,但对参数的修改可能会对模型的固有知识产生潜在的有害影响。

保留模型参数:一些研究不是直接修改模型参数,而是将额外的模型插件应用到原始模型中,以实现模型行为的所需更改。SERAC采用了一个范围分类器,将存储在外部编辑记忆中的与新知识相关的输入路由到反事实模型,这可以帮助基本模型处理更新的信息。与整个模型相比,有多种技术涉及将额外的参数层(例如适配器层)作为插件合并到原始模型中。T-Patcher和NKB都将补丁添加到FFN层中,这些层被认为是存储知识的存储库,以纠正事实错误。CALINET 提出了一种识别PLM中错误知识的评估方法,并通过引入类似FFN的内存槽来调整输出,这有助于缓解知识鸿沟。这些方法需要额外的步骤来训练参数模块,精心设计训练功能和结构,使插件在保持原始模块处理未编辑事实的同时,发挥更新知识的作用。

检索增强:减轻知识鸿沟的直观方法是检索增强生成(RAG),通过对从外部知识源检索的相关文档进行条件约束,使LLM生成ground-truth。通常,RAG遵循检索后读取,其中相关的上下文文档首先由检索器从外部源检索,然后由生成器对输入文本和检索文档进行条件约束生成所需的输出。将使用检索增强来减轻幻觉的方法分为三种类型,包括一次性检索、迭代检索和事后检索。

一次检索:目的是将单次检索获得的外部知识直接添加到LLMs的提示符中。Incontext RALM是一种简单而有效的策略,即将选定的文档预先添加到LLM的输入文本中。PKG采用可训练的背景知识模块,将其与任务知识对齐,生成相关的上下文信息。PKG的有效性突出了通过整合检索到的背景知识来提高LLM忠诚度的潜力。

迭代检索:当面对复杂的挑战时(如多步推理和长篇问答),传统的一次性检索可能不足。针对这些苛刻的信息需求,最近的研究提出了迭代检索,它允许在整个生成过程中不断收集知识。一个新兴的研究方向试图通过将这些复杂的任务分解成更易于管理的子任务来解决这些复杂的任务。认识到思维链提示在多步骤推理中带来的实质性进步,许多研究尝试在每个推理步骤中纳入外部知识,并进一步指导基于正在进行的推理的检索过程,减少推理链中的事实错误。

事后检索:通过随后的基于检索的修订来细化LLM输出。为了提高LLM的可信度和归因性,研究人员先研究相关证据,然后根据发现的与证据的差异对初始生成进行修改。同样,有方法引入了验证和验证框架,通过引入外部知识来提高推理链的事实准确性。对于一致性低于平均水平的推理链,框架生成验证问题,然后根据检索到的知识提炼基本原理,确保更真实的响应。

缓解知识捷径

当LLMs依靠虚假的相关性(如预训练语料库的共现统计)来获取事实知识时,知识捷径就会显现出来。可以通过排除有偏样本构建的去偏数据集进行微调。尽管这导致频繁事实的召回率显著下降,因为更多的样本被排除在外,但当微调过程中看不到罕见事实时,这种方法很难泛化。

缓解知识召回失败

LLMs产生幻觉的一个普遍原因是他们无法准确地检索和应用嵌入在参数化知识中的相关信息。在信息完整性至关重要的复杂推理场景中,这一挑战尤为严峻。通过增强知识回忆,我们可以更好地将模型的输出锚定到可验证的知识上,从而提供更强大的防御,防止产生幻觉内容。通常,召回知识最直接的方法是让LLMs通过思维链提示进行推理。

缓解训练相关幻觉

为了解决与预训练相关的幻觉,大多数研究强调探索新的模型架构和改进预训练目标。

缓解预训练相关幻觉

缓解有缺陷的模型结构:减轻预训练相关幻觉的一个重要研究途径集中在模型架构固有的局限性上,特别是单向表示和注意故障。鉴于此,许多研究已经深入到设计新颖的模型架构,专门针对这些缺陷进行改进。

缓解单向表示:引入采用双向自回归方法的BATGPT。这种设计允许模型基于以前看到的所有标记来预测下一个标记,同时考虑过去和未来的上下文,从而捕获两个方向上的依赖关系。

减轻注意力故障:利用注意锐化正则化器。这种即插即用的方法使用可微损失项来简化自关注架构,以促进稀疏性,从而显著减少推理幻觉。

缓解次优预训练目标:传统目标可能导致模型输出中的碎片化表示和不一致。最近的进展试图通过改进预训练策略,确保更丰富的上下文理解和规避偏见来解决这些挑战。本节阐明了这些开创性的方法,包括新的训练目标和消除曝光偏差方法。

训练目标:由于GPU内存约束和计算效率,文档级别的非结构化事实知识经常被分块,导致信息碎片化和不正确的实体关联,引入了一种事实增强的训练方法。通过给事实文档中的每个句子附加一个TOPICPREFIX,该方法将它们转换为独立的事实,显著减少了事实错误,增强了模型对事实关联的理解。

曝光偏差:曝光偏差引起的幻觉与错误积累有着复杂的联系。在置换多任务学习框架中引入了中间序列作为监督信号,以减轻NMT领域移位场景中的虚假相关性。此外,通过采用最小贝叶斯风险解码也可以进一步减少与曝光偏差相关的幻觉。

缓解未对齐引起的幻觉

为了解决这个问题,一个直接的策略是改进人类的偏好判断,进而改进偏好模型。研究LLM的使用,以帮助人类标记者识别被忽视的缺陷。此外,汇总多种人类偏好可以提高反馈质量,从而减少谄媚。对LLM内部激活的修改也显示出改变模型行为的潜力。这可以通过微调或推理期间的激活转向。具体来说,使用综合数据对语言模型进行微调,其中主张的基本事实独立于用户的意见,旨在减少阿谀奉承的倾向。另一种研究方法是通过激活导向来减轻阿谀奉承。这种方法包括使用成对的阿谀/非阿谀提示来生成阿谀导向矢量,该矢量来自对中间激活的差异进行平均。

缓解推理相关幻觉

事实增强解码

通过强调事实的准确性,该策略旨在生成严格遵循真实世界信息的输出,并抵制产生误导性或虚假的陈述。

独立解码:考虑到采样过程中的随机性会将非事实内容引入开放式文本生成,引入了事实核采样算法,该算法在整个句子生成过程中动态调整"核心"。该解码策略根据衰减因子和下界动态调整核概率,并在每个新句子开始时重新设置核概率,从而在生成事实内容和保持输出多样性之间取得平衡。此外,一些研究假设LLM的激活空间包含与事实性相关的可解释结构。在这个想法的基础上,引入了推理-时间干预(ITI)。该方法首先在与事实正确语句相关的激活空间中确定一个方向,然后在推理过程中沿着真值相关的方向调整激活。通过反复应用这种干预,LLM可以被引导到产生更真实的反应。

后编辑解码:与直接修改概率分布以防止初始解码期间出现幻觉的方法不同,后编辑解码寻求利用LLM的自校正能力来完善最初生成的内容,而不依赖外部知识库。一些方法使用验证链(COVE),该验证链的运行假设是,在适当的提示下,LLM可以自纠正其错误并提供更准确的事实。它首先制定验证问题,然后系统地回答这些问题,以便最终产生改进的修订回答。

忠实度增强编码

忠实度增强解码优先考虑与用户指令或提供的上下文保持一致,并强调增强生成内容的一致性。将现有工作总结为两类,包括上下文一致性和逻辑一致性。

上下文一致:由于对上下文关注不足而产生的幻觉问题仍然存在。研究人员提出了上下文感知解码(CAD),通过减少对先验知识的依赖来修改输出分布,从而促进模型对上下文信息的关注。然而,由于多样性和归因之间的内在权衡,过度强调上下文信息会降低多样性。因此引入了一种创新的采样算法,以在保持多样性的同时支持归因。该方法包括两个并行解码,一个考虑源,另一个不考虑源,并根据token分布之间的KL散度动态调整温度以反映源属性。还有方法探索了一个更通用的后期编辑框架,以减轻推理过程中的忠实度幻觉。该方法首先在句子和实体级别检测幻觉,然后利用这种检测反馈来完善生成的响应。一些方法提出了知识约束解码(KCD),采用token级幻觉检测来识别幻觉,并通过对未来基于知识的更好估计重新权衡token分布来指导生成过程。

逻辑一致:为了增强思维链提示的内在自一致性,可采用知识蒸馏框架。首先使用对比解码生成一致的理由,然后用反事实推理的目标对学生模型进行微调,这有效地消除了推理捷径,这些捷径在不考虑理由的情况下推导出答案。此外,通过采用对比解码,可以减少表面级复制并防止遗漏推理步骤。

挑战和开放问题

挑战

虽然在缓解LLM幻觉方面取得了重大进展,但仍存在值得注意的挑战。本节主要介绍它们在长文本生成、检索增强生成和大视觉-语言模型等领域的表现。

长文本生成的幻觉

随着生成内容长度的增加,幻觉的倾向也会增加,导致评估这种幻觉的成为挑战。首先,现有的LLM幻觉基准通常以事实问答的形式呈现,更关注事实幻觉。在长文本生成领域,明显缺乏人工标注的幻觉基准,这阻碍了研究人员在此背景下研究特定类型的幻觉。其次,评估长文本生成中的幻觉具有挑战性。虽然有一些可用的评估指标,但它们有局限性,当事实更微妙、开放式和有争议时,或当知识源中存在冲突时,并不适用。

检索增强生成的幻觉

检索增强生成(RAG)已成为一种有希望减轻LLM中的幻觉的策略。随着人们对LLM幻觉的担忧加剧,RAG越来越受到关注,为一系列商业应用铺平了道路,如Perplexity2, YOU.com 3和New Bing 4。RAG通过从外部知识库中检索证据,使LLM具备最新的知识,并根据相关证据生成响应。然而,RAG也有幻觉。一个值得注意的问题是RAG管道内潜在的误差累积。不相关的证据可能会传播到生成阶段,可能会污染输出。另一个问题在于生成检索领域,它偶尔会遭受引用不准确的问题。虽然引用的目的是为验证目的提供一条可追踪的信息来源的路径,但这个领域的错误可能会导致用户误入歧途。此外,现有的RAG可能会在多样性和事实性之间进行权衡,这就对多样性的需求提出了新的挑战。

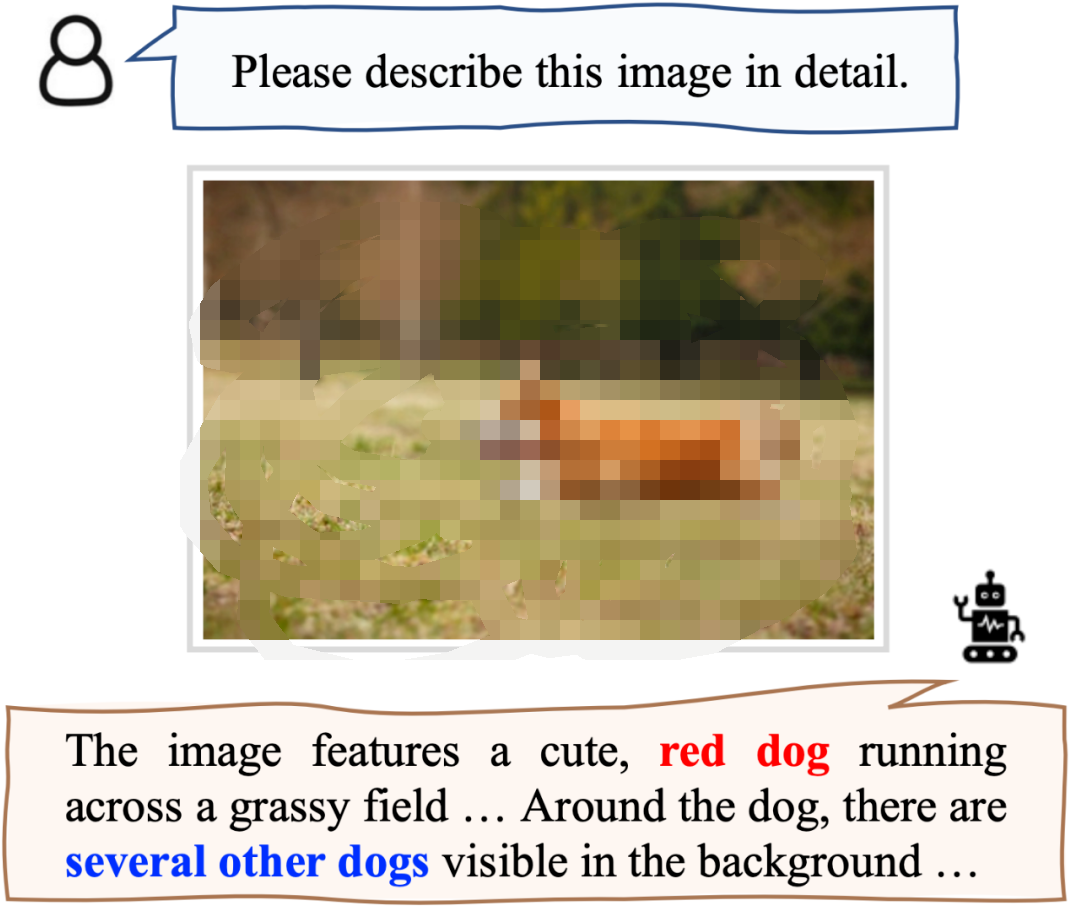

大视觉-语言模型的幻觉

由于具备了视觉感知能力,以及出色的语言理解和生成能力,大视觉-语言模型(LVLM)表现出了非凡的视觉-语言能力。与之前从大规模视觉语言预训练数据集获得有限视觉语言能力的预训练多模态模型不同,LVLM利用先进的大语言模型来更好地与人类和环境交互。因此,LVLM的多样化应用也为维护此类系统的可靠性带来了新的挑战,需要进一步研究和缓解。评估和实验表明,当前的LVLM容易对相关图像产生不一致的响应,包括不存在的对象、错误的对象属性、错误的语义关系等。此外,由于过度依赖强语言先验,LVLM很容易被愚弄,并经历严重的性能下降,以及其抵御不适当用户输入的能力较差。人们正在努力建立一个更鲁棒的大视觉-语言模型。当呈现多个图像时,LVLM有时会混淆或遗漏部分视觉上下文,以及无法理解它们之间的时间或逻辑联系,这可能会阻碍它们在许多场景中的使用,正确识别此类障碍的原因并解决它们仍然需要持续的努力。

LLM幻觉的开放问题

随着LLM幻觉研究的进展,其自我纠正机制在减少幻觉方面的有效性,其内部对知识边界的理解,以及他们的创造力和真实性之间的平衡等问题需要进一步探讨。

自校正机制能帮助减轻推理幻觉吗?

虽然LLM在通过思维链提示处理复杂推理任务方面表现出了非凡的能力,但它们偶尔会表现出不忠实的推理,其特征是推理步骤或结论在逻辑上不遵循推理链研究表明,将外部反馈集成到LLM中。这种反馈通常通过检索过程来自外部知识源,与其他LLM进行互动或来自外部评估指标的指导。这探索了自校正机制的潜力,其中LLM使用其内置能力校正其初始响应,而不依赖外部反馈。尽管自校正已显示出实现忠实和准确推理的能力,但某些研究对自矫正机制的有效性提出质疑,指出LLM仍然难以自校正其推理链。因此,该机制的有效性仍然是一个开放问题,值得进一步探索。

是否能准确计算知识边界?

尽管从广泛的数据中捕获事实知识的能力令人印象深刻,但LMM在识别自己的知识边界方面仍然面临挑战。这种不足导致幻觉的发生,在这种情况下,LMM自信地制造谎言,而没有意识到自己的知识限制。许多研究都深入探索了LMM的知识边界,利用了一些策略,如评估多项选择题中正确答案的概率,或通过评估具有不确定含义的句子集之间的相似性来量化模型的输出不确定性。此外,还有工作揭示了LLM在其激活空间中包含与真实性信念相关的潜在结构。最近的研究也发现了大量证据,表明LLM有能力对问题的不可回答性进行编码,尽管这些模型在面对不可回答的问题时表现出过度自信并产生幻觉。因此,我们是否可以有效地探索LLM的内部信念正在进行中,需要进一步的研究。

如何在创造性和真实性之间取得平衡?

在LLM发展过程中,平衡创造力和事实性的挑战是一个重要的问题。确保真实性对于用于现实世界应用的LLM至关重要;任何不准确的信息都会误导用户,污染网络环境。相反,幻觉有时可以提供有价值的视角,特别是在创造性的努力中,如讲故事、头脑风暴和产生超越传统思维的解决方案。虽然目前对LLM的研究严重倾向于减少幻觉,但往往忽视了其创造力的重要作用。其创造力和事实准确性之间取得平衡的挑战仍然没有解决。探索多模态文本生成任务中的平衡也是有趣的,也适用于视觉生成任务。这个问题超越了单纯的技术问题,需要对人工智能的本质及其对人类互动和知识交流的影响进行更广泛的思考。

总结

这篇综述对大型语言模型中的幻觉进行了深入研究,深入研究了其根本原因、检测方法以及相关基准和有效的缓解策略。尽管已经取得了重大进展,但大型语言模型中的幻觉问题仍然是一个令人信服和持续的问题,需要继续进行研究。

原文标题:LLM的幻觉问题最新综述

文章出处:【微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

-

人工智能

+关注

关注

1791文章

47183浏览量

238209 -

涡轮增压

+关注

关注

1文章

79浏览量

5336 -

ChatGPT

+关注

关注

29文章

1558浏览量

7592 -

LLM

+关注

关注

0文章

286浏览量

327

原文标题:LLM的幻觉问题最新综述

文章出处:【微信号:zenRRan,微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

对比解码在LLM上的应用

TaD+RAG-缓解大模型“幻觉”的组合新疗法

基于Transformer的大型语言模型(LLM)的内部机制

最新综述!当大型语言模型(LLM)遇上知识图谱:两大技术优势互补

最新研究综述——探索基础模型中的“幻觉”现象

幻觉降低30%!首个多模态大模型幻觉修正工作Woodpecker

LLM推理加速新范式!推测解码(Speculative Decoding)最新综述

利用知识图谱与Llama-Index技术构建大模型驱动的RAG系统(下)

自然语言处理应用LLM推理优化综述

LLM的幻觉问题最新综述

LLM的幻觉问题最新综述

评论