人工智能(AI)无疑是近几年最火的技术。从开发到部署AI技术主要可分为两大步骤,即AI训练和AI推理。

AI训练主要是为AI模型提供数据,使其掌握了解将要分析的数据类型所需的一切信息的过程;而AI推理则是通过经过训练的AI模型运行新的实时数据,从而作出预测并产生可执行结果的过程。

在这两个过程中,它们对于计算的需求不同,AI训练的计算周期长,需要大量优质数据,是一次性的投资。AI推理则是短时间的算力需求激增,需要快速、高效能的计算,是一个长期投资。

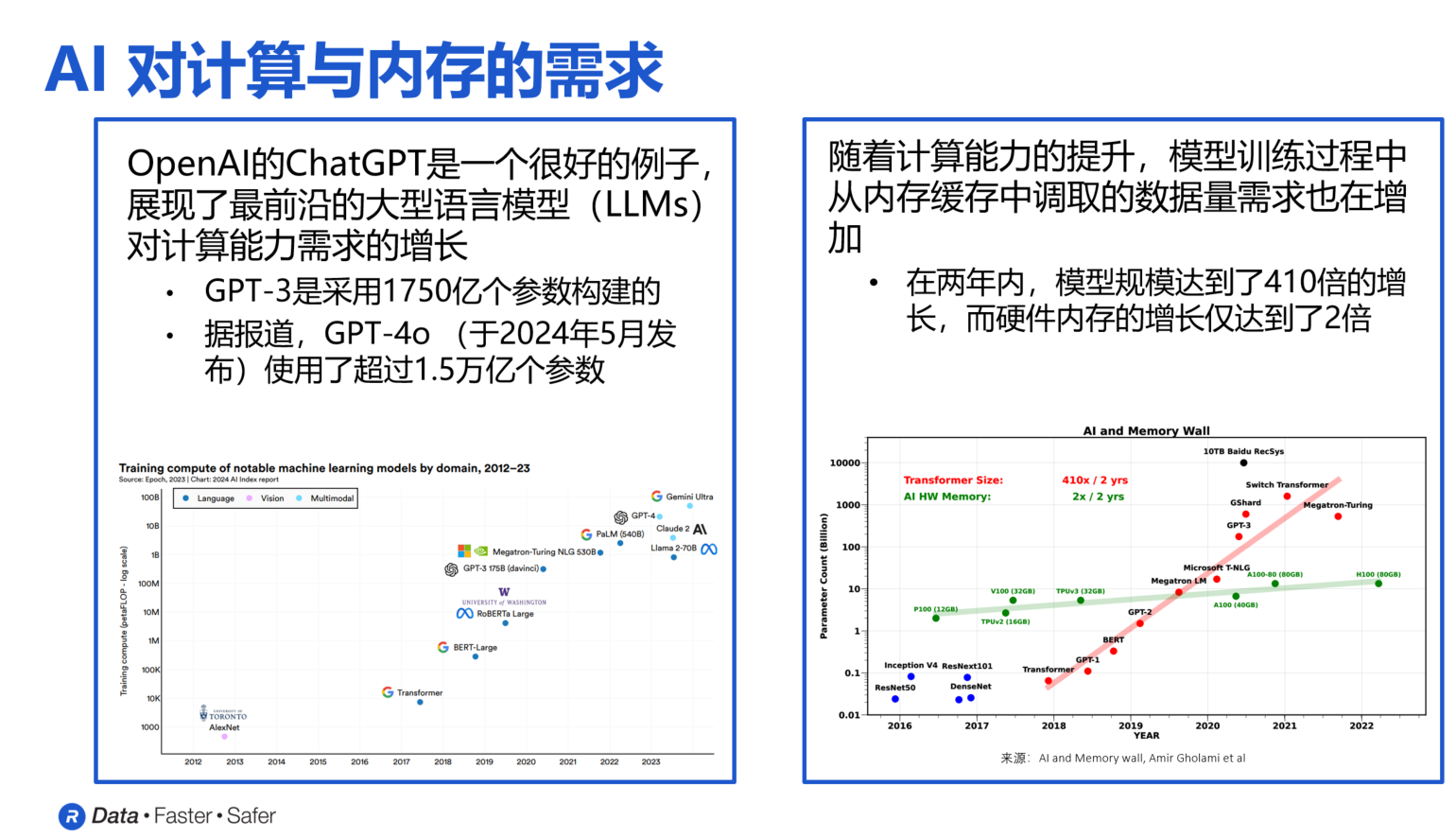

尤其对于AI训练,随着AI大模型的复杂度不断提升,AI训练所需的数据也在持续增长。根据OpenAI的数据,自2012年以来,最大规模的AI训练所使用的计算量以每年10倍的速度增长。以OpenAI的ChatGPT为例,2022年11月发布的GPT-3当时使用了1750亿个参数构建,而到2023年3月发布的GPT-4时,使用的参数数量已经超过1.5万亿个。这一数据还在持续增长中。

如此大规模的数据总量对于内存提出了较高要求,如高带宽、高容量、高性能等,传统的内存产品已经无法满足AI训练的需求。而HBM似乎是为AI训练量身定做的存储器产品。

HBM(High Bandwidth Memory,高带宽存储器)最先是AMD和SK海力士发起的一种基于3D堆栈工艺的高性能DRAM,它包含了中介层、处理器以及内存堆栈。这意味着HBM可以提供非常高的带宽,而且还具有非常高的能效及低延迟。目前,HBM内存已经演进了了几代,最新一代为HBM3E,英伟达即将发布的H200将是首款提供HBM3E的GPU产品。

人工智能技术的发展也带动了HBM市场的不断发展,在今年内存市场普遍低迷的情况下,HBM需求井喷,未来几年的增幅也将扩大。据咨询机构TrendForce预测,2024年全球HBM的位元供给有望增长105%。到2024年,HBM的市场规模有望达到89亿美元,同比增长127%,2025年预计将突破100亿美元。

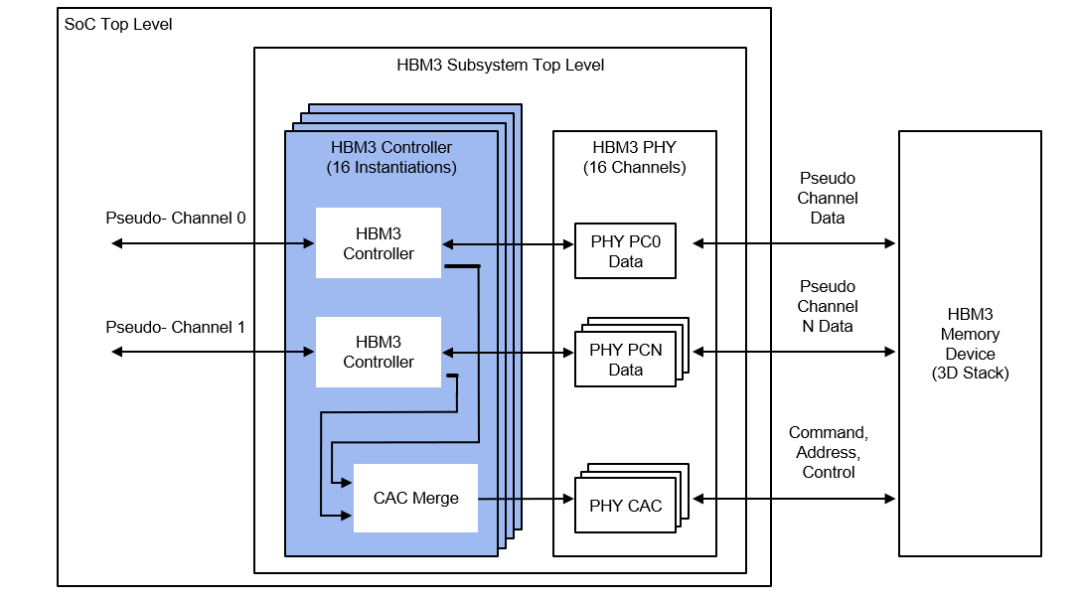

在此情况下,作为内存控制器IP的主要提供商之一,Rambus也积极布局HBM内存市场,近期推出了数据传输速率高达9.6Gb/s的HBM3内存控制器IP,可帮助大幅提高AI性能。据Rambus接口IP产品管理和营销副总裁Joe Salvador先生介绍,Rambus的这一内存控制器IP产品是经过验证的,可支持所有HBM3产品,也包括最新的HBM3E内存设备。

Rambus HBM3控制器模块图

Joe Salvador强调:“Rambus HBM3控制器不仅仅是一个独立产品,我们还能提供一整套完整的经过验证的解决方案,能够和市面上目前比较常见的HBM3以及相关的内存模组进行匹配,如SK海力士、美光和三星的产品,我们都已经完成了一整套的测试。另外,我们也经过了第三方来自西门子Avery的验证IP,也可以完整地支持相应的功能。”

目前,随着AI技术的不断发展,对于算力和内存的需求也将不断增长。Rambus大中华区总经理苏雷先生表示:“AI技术发展面临的挑战将更多集中于存储墙问题,而算力的演进将不会面临太多的挑战。目前的内存和带宽的发展还是太慢,无法跟上AI技术的发展脚步。作为存储方面的专家,Rambus可以预见,伴随着AI的新成长和驱动,我们会在这一轮的科技浪潮中发挥越来越重要的作用,助力AI的发展。”

另外,数据安全也是在AI技术发展中不可忽视的问题。苏雷表示:“我们也提供安全IP方面的全套方案,让数据传输更快、更安全。”

AI时代的来临,带来了很多挑战和机遇。而对于存储器市场来说,则是一次很好的发展机会。作为存储行业的老兵,Rambus未来也大有可为。

审核编辑:刘清

-

控制器

+关注

关注

112文章

16332浏览量

177795 -

人工智能

+关注

关注

1791文章

47182浏览量

238199 -

ai技术

+关注

关注

1文章

1266浏览量

24284 -

HBM3

+关注

关注

0文章

74浏览量

154

原文标题:【媒体报道】术业专攻,Rambus推出9.6Gbps HBM3内存控制器IP

文章出处:【微信号:Rambus 蓝铂世科技,微信公众号:Rambus 蓝铂世科技】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

HBM格局生变!传三星HBM3量产供货英伟达,国内厂商积极布局

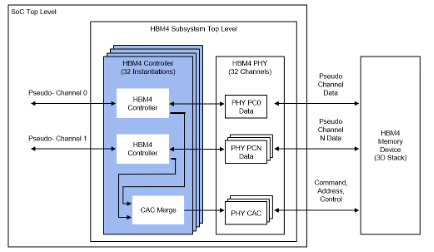

HBM4进一步打破内存墙,Rambus控制器IP先行

Rambus推出业界首款HBM4控制器IP

Rambus宣布推出业界首款HBM4控制器IP,加速下一代AI工作负载

Rambus推GDDR7内存控制器IP满足AI应用需求

三星LPDDR5X DRAM内存创10.7Gbps速率新高

HBM3E起飞,冲锋战鼓已然擂响

NVIDIA预定购三星独家供应的大量12层HBM3E内存

英伟达CEO赞誉三星HBM内存,计划采购

什么是HBM3E内存?Rambus HBM3E/3内存控制器内核

AMD MI300加速器将支持HBM3E内存

AMD发布HBM3e AI加速器升级版,2025年推新款Instinct MI

Rambus HBM3内存控制器IP速率达到9.6 Gbps

Rambus推出9.6Gbps HBM3内存控制器IP

Rambus推出9.6Gbps HBM3内存控制器IP

评论