Stability AI 宣布推出迄今为止最强大的小语言模型之一 Stable LM 2 1.6B。以英语、西班牙语、德语、意大利语、法语、葡萄牙语和荷兰语的多语言数据为基础进行了训练,体积小、速度快,降低了硬件门槛;并提供了完全透明的训练细节,旨在让开发人员和模型创建者能够快速进行实验和迭代。

Stable LM 是一种文本内容生成 LLM,Stability AI 于 2023 年 4 月首次推出了 30 亿和 70 亿参数模型。新的 StableLM 模型实际上是 Stability AI 在 2024 年发布的第二个模型,此前该公司在早些时候还发布了一个 Stable Code 3B。

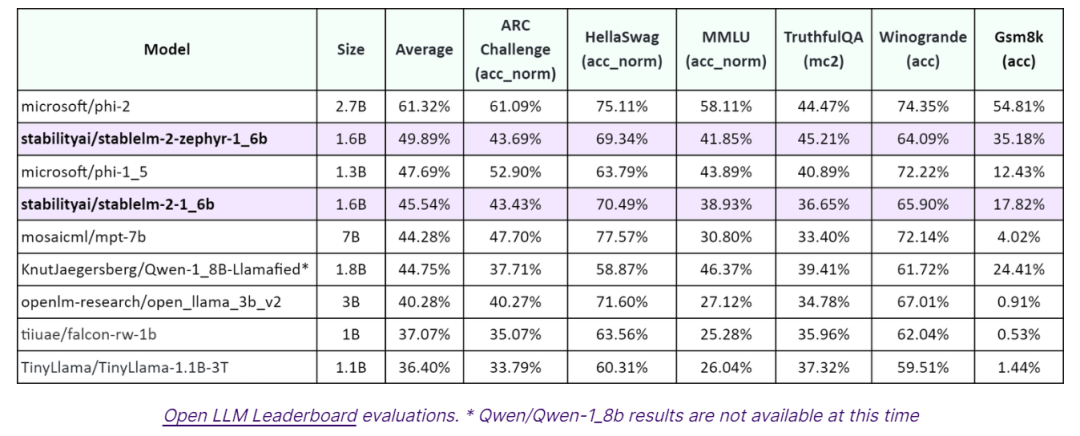

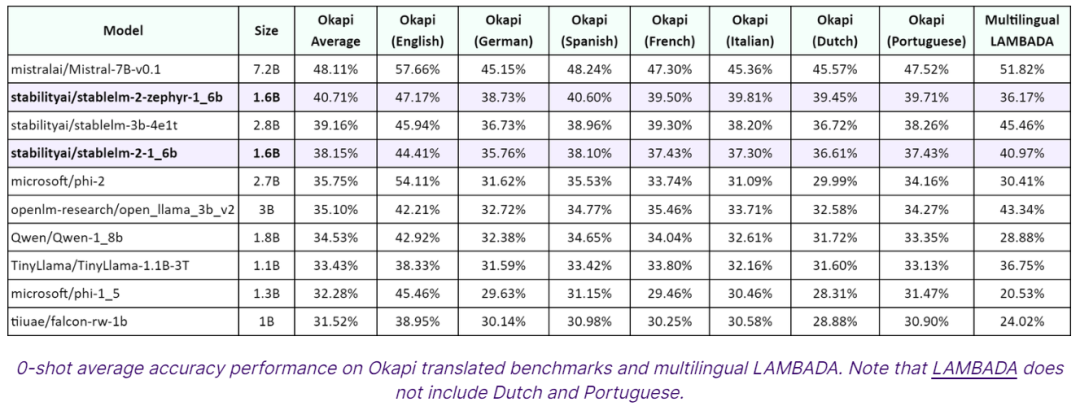

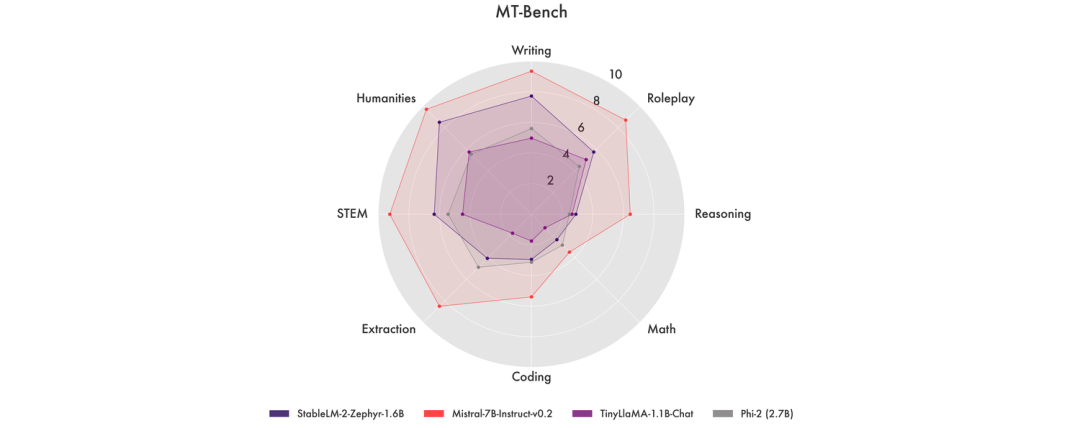

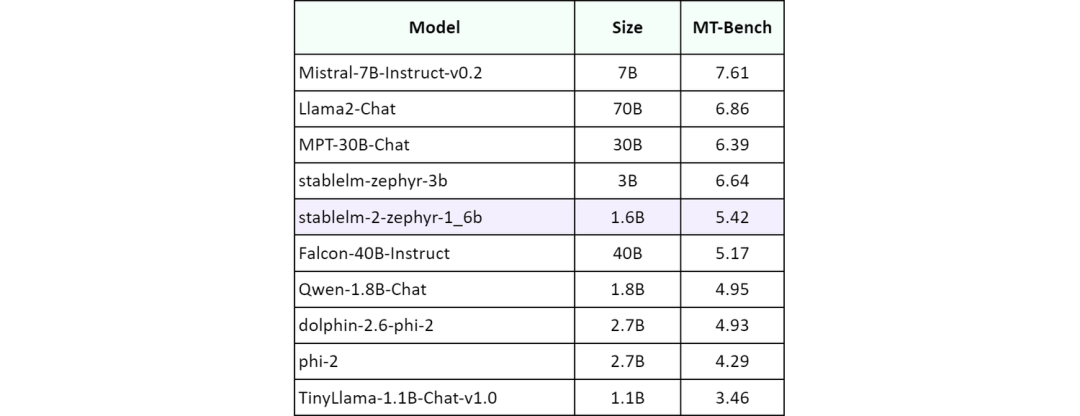

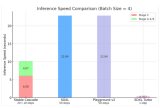

Stability AI 声称,Stable LM 2 1.6B 在大多数基准测试中均优于其他参数低于 20 亿个的小语言模型,如微软的 Phi-1.5 (1.3B) 和 Phi-2 (2.7B)、TinyLlama 1.1B 或 Falcon 1B。

不过他们也警告称,由于小型、低容量语言模型的特性,Stable LM 2 1.6B 可能会出现高幻觉率、潜在的有毒语言等类似的常见问题。“我们要求社区在构建应用程序时牢记这一点,并采取适当措施确保以负责任的方式进行开发。”

Stable LM 2 1.6B 目前可在商业和非商业领域使用,只要拥有 Stability AI 会员资格,即可在 Hugging Face 上测试该模型。

审核编辑:刘清

-

语言模型

+关注

关注

0文章

520浏览量

10268 -

LLM

+关注

关注

0文章

286浏览量

327

原文标题:Stability AI推出更小、更高效的1.6B语言模型

文章出处:【微信号:OSC开源社区,微信公众号:OSC开源社区】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

AI大语言模型开发步骤

大语言模型开发语言是什么

IBM发布Granite 3.0 AI模型家族

英伟达发布AI模型 Llama-3.1-Nemotron-51B AI模型

Meta Llama 3.1系列模型可在Google Cloud上使用

Mistral AI与NVIDIA推出全新语言模型Mistral NeMo 12B

安霸生成式AI芯片解决方案助力本地处理大型语言模型

【大语言模型:原理与工程实践】揭开大语言模型的面纱

Stability AI发布Stable Code Instruct 3B大语言模型,可编译多种编程语言

Stability AI推出全新Stable Video 3D模型

Stability AI与Morph AI共同推出一体化AI视频创作工具

蚂蚁集团推出20亿参数多模态遥感基础模型SkySense

Stability AI试图通过新的图像生成人工智能模型保持领先地位

Stability AI推出迄今为止更小、更高效的1.6B语言模型

Stability AI推出迄今为止更小、更高效的1.6B语言模型

评论