在小公司做大模型,这个事情是可以的。

笔者在小公司,做了一年多的大模型。先列一下成绩单:

开源了目前业界可能是分类较完整(50类)、数量较大(1100+万)的SFT数据集:匠数科技大模型sft数据集[1]

通过SFT、DPO、RLHF等技术训练了领域写作模型。实测下来,在该领域写作上,强于国内大多数的闭源模型。

如何在小公司做大模型,笔者总结,有如下几点:

1、至少要有基础的硬件条件。

如果双卡3090都没有,那是比较难的。实在没有,可以说服老板,租机器训练。

2、要有选择跟进模型训练、部署的最新进展,选主流、走大道。

技术迭代太快,人力有限的情况下,不可能什么都跟进的。比如部署,市面上的部署方案很多了,但是主流的就是vllm,所以,集中精力将vllm搞懂用好,就够了,其他的可以了解,但不用重点关注。

再比如各种训练技术,经过验证好用的也就是那么几个。看起来过于旁门左道的论文,可以先放放,让子弹飞一会儿再说。提一点,DPO确实是小公司对齐训练的福音。

3、要坚持开放交流,多加群。

围绕llm,有很多社群,也有很多活动,可以选择性参加,但是切记切记,不要过分沉溺其中,以为这样就能紧跟时代前沿,掌握最新趋势了。假装学到很多,是很有害滴。记得前段时间不是有个什么架构,号称取代transformer吗?铺天盖地的宣传,笔者当时也听了作者的线上分享。现在呢?自己连个像样的模型都没搞出来。纯纯浪费太多精力。相信时间会证明一切。

4、要针对业务场景解决问题,不要陷入llm崇拜。

这种现象典型的就是不是llm的工作就提不起神,不想做。实话实说,这是病,得治。笔者根据业务问题需求,开源的cutword[2],就是为了替代jieba的新一代分词工具,同时,ner类型和效果都是目前开源中一流的,也收获了大家的认可。

解决问题才是关键。不能有了llm这个锤子,看什么都是钉子。具体问题具体分析的能力很重要。

审核编辑:黄飞

-

大模型

+关注

关注

2文章

2423浏览量

2637

原文标题:如何在小公司做大模型

文章出处:【微信号:zenRRan,微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

从“可用”到“好用”,百度智能云如何做大模型的“超级工厂”?

ASML任命新CEO,带领公司走向未来

sora模型中国可以使用吗 sora模型是哪个公司

sora模型上市公司 sora模型对现实的影响

嵌入式产品开发的基本流程和注意事项

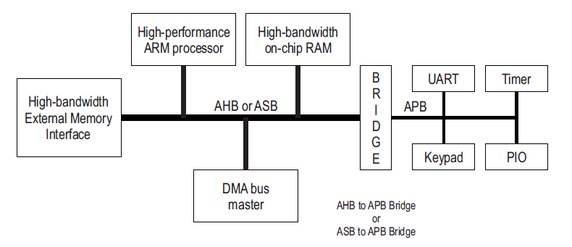

聊聊AMBA协议的evolution过程

无刷电机技术演进与高速风筒行业现状【其利天下高速风筒PCBA方案】

聊聊小公司如何做大模型

聊聊小公司如何做大模型

评论