训练AI大模型是一个复杂且耗时的过程,涉及多个关键步骤和细致的考量。

一、数据准备

1. 数据收集

- 确定数据类型 :根据模型的应用场景,确定需要收集的数据类型,如文本、图像、音频等。

- 寻找数据源 :从可靠的来源获取数据,如公开数据集、内部数据库或第三方数据提供商。

2. 数据清洗

- 去除重复数据 :确保数据集中没有重复项,以避免在训练过程中引入冗余信息。

- 处理缺失值 :对于缺失的数据,可以采取填充、删除或插值等方法进行处理。

- 标准化数据格式 :确保所有数据都符合统一的格式和标准,以便后续处理。

3. 数据预处理

- 数据划分 :将数据集划分为训练集、验证集和测试集。训练集用于训练模型,验证集用于调整模型参数和防止过拟合,测试集用于评估模型性能。

- 特征工程 :根据业务需求,提取和选择对模型训练有重要影响的特征。

- 数据增强 :对于图像或音频等数据,可以通过数据增强技术来增加数据的多样性和丰富性。

二、模型设计

1. 确定问题类型

- 分类问题 :如果目标变量是离散的,则可能是分类问题,如文本分类、图像分类等。

- 回归问题 :如果目标变量是连续的,则可能是回归问题,如房价预测、股票价格预测等。

- 聚类问题 :如果需要将数据集中的样本分为不同的组,则可能是聚类问题,如客户细分、市场细分等。

2. 选择模型类型

3. 设计模型结构

- 选择合适的算法 :根据问题类型和数据集的特点,选择适当的算法。

- 确定网络结构 :对于神经网络模型,需要确定网络的层数、节点数、激活函数等。

- 设置超参数 :如学习率、批量大小、迭代次数等,这些参数对模型的训练效果有重要影响。

三、模型训练

1. 选择训练框架

- TensorFlow :一个开源的机器学习框架,支持分布式训练,适用于大规模数据集和复杂模型。

- PyTorch :另一个流行的深度学习框架,具有灵活性和易用性,适用于研究和原型开发。

2. 配置计算资源

- GPU/TPU加速 :利用高性能计算设备(如NVIDIA GPU、Google TPU)来加速训练过程。

- 分布式训练 :将训练任务划分为多个子任务,并在多台计算设备上并行处理,以加快训练速度。

3. 调整模型参数

- 学习率调整 :根据模型的训练情况,动态调整学习率,以加快收敛速度并提高训练效率。

- 正则化方法 :使用L1、L2正则化等技术来防止模型过拟合。

4. 监控训练过程

- 损失函数 :监控损失函数的变化情况,以判断模型的训练效果。

- 验证集性能 :定期在验证集上评估模型的性能,以便及时调整模型参数。

四、模型评估

1. 选择评估指标

- 准确率 :分类问题中,正确分类的样本数占总样本数的比例。

- 召回率 :分类问题中,正确分类的正类样本数占所有正类样本数的比例。

- F1分数 :准确率和召回率的调和平均数,用于综合评估模型的性能。

2. 进行测试集评估

- 在测试集上运行模型,并计算评估指标的值。

- 根据评估结果,判断模型的性能是否满足业务需求。

五、模型优化与部署

1. 模型优化

- 模型剪枝 :通过移除不重要的神经元和连接来减小模型的规模,以提高运行效率。

- 模型量化 :将模型的权重和激活值转换为低精度表示,以减少模型的存储空间和计算成本。

2. 模型部署

- 选择合适的部署平台 :根据业务需求和技术要求,选择合适的部署平台,如云服务、边缘设备等。

- 进行集成和测试 :将模型集成到业务系统中,并进行全面的测试,以确保其稳定性和可靠性。

3. 监控和维护

- 监控模型性能 :定期监控模型的性能,以便及时发现并解决问题。

- 更新和优化 :根据业务需求和技术发展,不断更新和优化模型。

综上所述,训练AI大模型需要经历数据准备、模型设计、模型训练、模型评估以及模型优化与部署等多个环节。每个环节都需要细致入微的考虑和操作,以确保最终训练出的模型能够满足业务需求并具有高性能。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表德赢Vwin官网

网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

神经网络

+关注

关注

42文章

4771浏览量

100703 -

数据

+关注

关注

8文章

7002浏览量

88937 -

AI大模型

+关注

关注

0文章

315浏览量

305

发布评论请先 登录

相关推荐

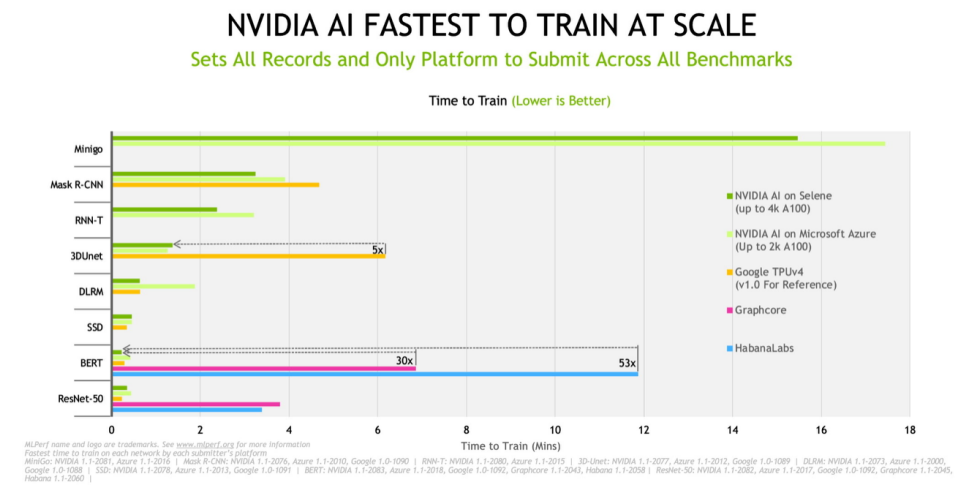

云服务、OEM 借助 NVIDIA AI让AI训练更上层楼

借助 NVIDIA AI,戴尔、浪潮、Microsoft Azure 和 Supermicro 在今天发布的新 MLPerf 基准测试中创下快速训练 AI 模型的记录。

发表于 12-03 10:19

•1607次阅读

“联邦学习”或将推动AI在医疗行业加速落地?

只有获取更多的数据进行训练,AI模型才能更强健,而数据现状显然有碍于深度学习理论下AI模型的进展。“联邦学习”能否打破壁垒,实现

NVIDIA为需要加速计算的企业客户运行测试服务器

借助 NVIDIA AI,戴尔、浪潮、Microsoft Azure 和 Supermicro 在今天发布的新 MLPerf 基准测试中创下快速训练 AI 模型的记录

NVIDIA联合构建大规模模拟和训练 AI 模型

Champollion 超级计算机位于格勒诺布尔,由慧与和 NVIDIA 联合构建,它将为全球科学和工业领域的用户创建大规模模拟和训练 AI 模型。

构建、训练AI模型不必令人困惑且耗时

毫不夸张地说,人工智能(AI)几乎可以用于工业领域的任何应用。随着技术被推向物联网的边缘,使用数量大幅攀升。开发人员正在迅速部署其AI架构,这要归功于Vecow等供应商的进步。

构建、训练AI模型不必令人困惑且耗时

毫不夸张地说,人工智能(AI)几乎可以用于工业领域的任何应用。随着技术被推向物联网的边缘,使用数量大幅攀升。开发人员正在迅速部署他们的人工智能架构,这要归功于Vecow等供应商的进步。

Open AI进军芯片业技术突破与市场机遇

Sam希望获得资金支持一个雄心勃勃的项目,目的是创建先进芯片,减少对目前AI芯片市场领导者英伟达的依赖,芯片算力对于训练AI模型至关重要。

发表于 01-22 14:37

•352次阅读

EyeEm平台默认使用用户照片训练AI模型,用户可自行删除作品

据报道,摄影分享平台EyeEm近期更新服务协议,宣称将默认使用用户上传的图片进行AI模型训练,若用户对此提出异议,则需自行删除所有作品。

如何训练自己的AI大模型

训练自己的AI大模型是一个复杂且耗时的过程,涉及多个关键步骤。以下是一个详细的训练流程: 一、明确需求和目标 首先,需要明确自己的需求和目标。不同的任务和应用领域需要不同类型的

微软否认使用用户数据训练AI模型

近日,微软公司正式否认了一项关于其使用Microsoft 365应用程序中客户数据来训练人工智能模型的指控。这一声明旨在澄清近期在社交媒体上流传的某些用户的疑虑和误解。 此前,部分用户在社交媒体平台

训练AI大模型需要什么样的gpu

训练AI大模型需要选择具有强大计算能力、足够显存、高效带宽、良好散热和能效比以及良好兼容性和扩展性的GPU。在选择时,需要根据具体需求进行权衡和选择。

GPU是如何训练AI大模型的

在AI模型的训练过程中,大量的计算工作集中在矩阵乘法、向量加法和激活函数等运算上。这些运算正是GPU所擅长的。接下来,AI部落小编带您了解GPU是如何

如何训练ai大模型

如何训练ai大模型

评论