评估AI大模型的效果是一个复杂且多维度的过程,涉及多个方面的考量。以下是一些关键的评估方法和步骤:

一、基准测试(Benchmarking)

使用标准数据集和任务来评估模型的性能,如GLUE、SuperGLUE、SQuAD等。这些数据集提供了不同任务上的基准评估,使得不同模型在同一任务上的性能可以进行直接比较。

二、多样性和覆盖性测试

测试模型在不同类型的数据和任务上的表现,如文本生成、翻译、问答等。这有助于确保模型能够处理各种语言现象和上下文,评估其泛化能力。

三、鲁棒性测试

检查模型在面对输入数据扰动(如拼写错误、语法错误、模糊描述等)时的表现。通过引入各种噪声和干扰,测试模型对扰动和干扰的抗性能力,以确保模型的误差容忍度和稳定性。

四、效率和可扩展性测试

测试模型在不同计算资源和硬件环境下的运行效率,评估推理速度、内存占用和扩展能力。这对于确保模型在实际应用中的可行性和性能至关重要。

五、实际应用测试

在真实场景中测试模型的应用效果,如客户服务、文本分析、对话系统等。收集用户反馈和性能指标,评估模型的实用性和用户满意度。这有助于发现模型在实际应用中的潜在问题和改进方向。

六、选择合适的评估指标

根据具体应用场景和需求,选择适合的评估指标进行模型的评估。常见的评估指标包括准确率、精确率、召回率、F1值等。对于分类任务,可以使用混淆矩阵来详细分析模型的性能。对于回归任务,则可以使用均方误差(MSE)、均方根误差(RMSE)、平均绝对误差(MAE)等指标来评估模型的预测精度。

七、可解释性和透明度评估

评估模型的可解释性和透明度,了解模型是如何做出决策的。这有助于发现潜在的问题,提高模型的可信度和可靠性。对于某些应用场景,如金融、医疗等,模型的可解释性尤为重要。

八、综合评估框架

为了全面评估AI大模型的效果,可以使用综合评估框架,如OpenCompass等。这些框架为开发者和研究者提供了一个一站式的平台来评估大模型在各种任务上的表现。它们通常包括配置、推理与评估、可视化等阶段,能够方便地比较不同模型的性能,并提供详细的评估报告。

综上所述,评估AI大模型的效果需要综合考虑多个方面,包括基准测试、多样性和覆盖性测试、鲁棒性测试、效率和可扩展性测试、实际应用测试、选择合适的评估指标、可解释性和透明度评估以及综合评估框架等。通过这些步骤和方法,可以全面评估AI大模型的性能和可靠性,确保模型在实际应用中的表现达到预期目标。

-

硬件

+关注

关注

11文章

3312浏览量

66199 -

GLUE

+关注

关注

0文章

5浏览量

7352 -

AI大模型

+关注

关注

0文章

315浏览量

305

发布评论请先 登录

相关推荐

AI大语言模型开发步骤

Meta发布新AI模型自学评估器,探索减少人类参与度

Meta推出可自我评估AI模型

【每天学点AI】人工智能大模型评估标准有哪些?

华为云盘古汽车大模型通过可信AI汽车大模型评估

STM CUBE AI错误导入onnx模型报错的原因?

英国AI安全研究所推出AI模型安全评估平台

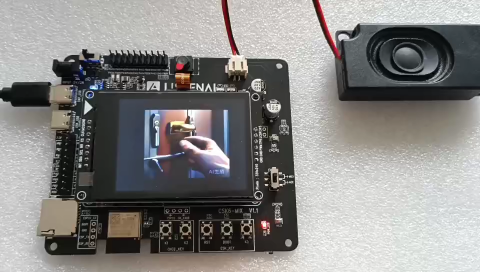

防止AI大模型被黑客病毒入侵控制(原创)聆思大模型AI开发套件评测4

使用cube-AI分析模型时报错的原因有哪些?

如何评估AI大模型的效果

如何评估AI大模型的效果

评论