导读

2023年以ChatGPT为代表的大语言模型横空出世,它的出现标志着自然语言处理领域取得了重大突破。它在文本生成、对话系统和语言理解等方面展现出了强大的能力,为人工智能技术的发展开辟了新的可能性。同时,人工智能技术正在进入各种应用领域,在智慧城市、智能制造、智慧医疗、智慧农业等领域发挥着重要作用。

柴火创客2024年将依托母公司Seeed矽递科技在人工智能领域的创新硬件,与全球创客爱好者共建“模型仓”,通过“SenseCraft AI”平台可以让使用者快速部署应用体验人工智能技术!

本期介绍:模型案例:|花卉分类识别模型!

FCOS

FCOS(Fully Convolutional One-Stage Object Detection)是一种基于全卷积的单阶段目标检测算法,它是一种无Anchor box的算法,实现了无Anchor、无Proposal,并且提出了Center-ness的思想,极大地提升了Anchor-Free目标检测算法的性能。

FCOS的优点包括避免了Anchor Box带来的复杂计算,如计算重合度IoU,避免了Anchor Box相关的超参数设置,这些设置对性能影响较大。

因此,FCOS可以与其他使用FCN结构的任务相统一,方便其他任务方法之间的re-use,减少了超参数数量,更简单,同时也减少了计算复杂度,如IoU计算。

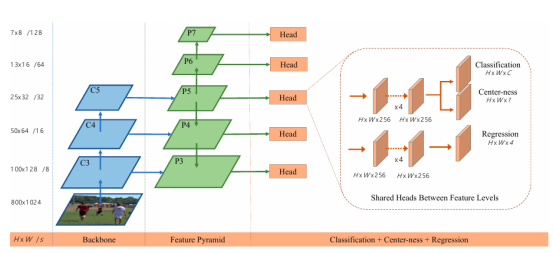

FCOS网络结构

FCOS的网络结构主要由三部分组成:Backbone、FPN(Feature Pyramid Networks)和Classification+Center-ness+Regression Head。

Backbone

Backbone是FCOS网络的特征提取部分,通常采用深度卷积神经网络(如ResNet、VGG等)来提取图像的多尺度特征。这些特征图不仅包含了丰富的语义信息,还保留了足够的空间信息,为后续的目标检测提供了有力的支持。

在FCOS中,Backbone输出的特征图尺寸逐层减半,形成金字塔结构。对于特征图上的每一个点(x, y),其映射回原图的坐标可以通过公式(⌊s/2⌋+xs, ⌊s/2⌋+ys)计算得到,其中s为特征图相对于原图的下采样倍数。这种映射关系使得FCOS能够直接利用特征图上的点进行目标预测,而无需预设Anchor boxes。

FPN

FPN(Feature Pyramid Networks)是一种用于多尺度目标检测的网络结构,它通过融合不同尺度的特征图来增强网络对不同尺寸目标的检测能力。在FCOS中,FPN同样扮演着重要的角色。

与Anchor Based的检测器不同,FCOS通过限制不同层级特征图上的边界框回归范围来分配检测任务。具体来说,FCOS将每个特征图上的点分配给其最近的目标(如果存在的话),并根据目标的大小将其分配到不同的特征层级上。这种分配策略不仅提高了检测效率,还使得网络能够更专注于处理与其层级相匹配的目标尺寸。

Classification+Center-ness+Regression Head

在FCOS中,每个特征图上的点都被视为一个潜在的训练样本,用于进行目标分类、Center-ness预测和边界框回归。为了实现这些任务,FCOS在特征图后接入了三个并行的卷积头:Classification Head、Center-ness Head和Regression Head。

Classification Head:用于预测特征图上每个点所属的目标类别。在训练过程中,只有当特征点位于某个目标的有效区域内时(即与目标的边界框有足够的重叠),才会被标记为正样本并参与分类训练。否则,该点被视为负样本。

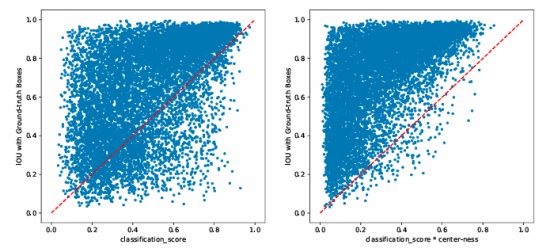

Center-ness Head:是FCOS的一个创新点,用于预测特征点上目标中心区域的相对位置。具体来说,Center-ness是一个0到1之间的值,表示该点到其所属目标中心的距离远近。在训练过程中,Center-ness的值会根据点到目标中心的距离进行计算和标注。在推理过程中,Center-ness的值会与分类得分相乘作为最终的预测得分,以降低远离目标中心的预测框的得分从而提高检测性能。

Regression Head:用于预测特征图上每个点到其所属目标边界框四条边的距离。与许多Anchor-based的方法不同,FCOS直接回归这些距离值而无需预设Anchor boxes。这种回归方式不仅简化了检测流程还减少了计算量。·

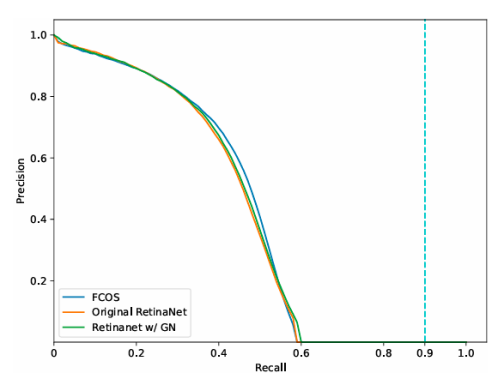

FCOS性能优势

减少了计算复杂度,由于摒弃了Anchor boxes机制FCOS避免了与之相关的复杂计算如计算重合度IoU等从而减少了计算量提高了检测效率。同时FCOS还减少了与Anchor相关的超参数数量简化了算法设计并降低了超参数调整的难度。

提高了检测精度,通过引入Center-ness优化机制FCOS能够降低远离目标中心的预测框的得分从而提高检测精度。此外FCOS还采用了多尺度预测与层级分配策略来处理不同尺寸的目标进一步提高了检测性能。

增强了与其他任务的兼容性,由于FCOS采用了全卷积网络结构因此它可以与其他使用FCN结构的任务相统一方便其他任务方法之间的re-use。这种兼容性不仅有助于实现多任务学习还能够促进不同领域之间的知识共享和迁移学习。

花卉分类识别模型

该模型用来检测花卉,可以识别郁金香(tulips)、向日葵(sunflowers)和粉玫瑰(roses)三种花卉。

花卉识别数据集

数据集下载地址

在Grove - VisionAIV2模块上训练和部署模型

SenseCraft Al平台提供和简单、方便的AI模型训练和部署功能,可以让技术小白也能快速进行特定场景的AI模型训练和部署。

1、打开SenseCraft AI平台,如果第一次使用请先注册一个会员账号,还可以设置语言为中文,在顶部菜单栏单击【模型训练】选项,如下图所示。

平台地址:https://sensecraft.seeed.cc/ai/#/model

2、进入【模型训练】页面后单击左侧的【分类识别类别】选项,如下图所示。

3、单击Class1和Class2右边的修改分类名称图标,修改两个类别名称为roses(粉玫瑰)和sunflowers(向日葵)两个图像分类类别,再单击底部的“添加类别”选项并修改类别名称为tulips(郁金香),如下图所示。

4、在每个分类选项中,单击右边的【...】图标,单击【导入图片】打开导入图像窗口,将下载好的数据图片导入到每个类别中,这样就导入了一定数量的数据集(至少100张),如下图所示。

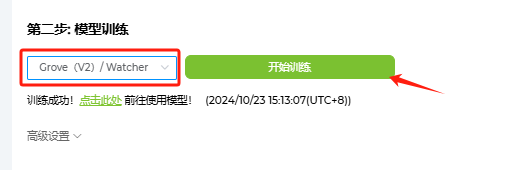

5、接着进行第二步:模型训练,先选中“Grove(V2)”然后单击【开始训练】按钮,如下图所示。经过一段时间的训练后,即可生成花卉分类图像识别模型。

6、第三步是部署,先选中“Grove(V2)”选项,单击【部署到设备】如下图所示,按提示连接Grove vision AI V2硬件后开始进行模型部署。

7、部署完成后进入工作窗口,这时会打开摄像头预览功能,对郁金香(tulips)、向日葵(sunflowers)和粉玫瑰(roses)图像,预览窗口底部会看到预测的类别名称和置信率,如下图所示。

推理结果演示

Grove Al视觉模块 V2套装介绍

Grove Al视觉模块 V2

OV5647-62摄像头

Grove - Vision Al Module V2是一款拇指大小的人工智能视觉模块, 配备Himax WiseEye2 HX6538处理器和Arm Ethos-U55嵌入式神经网络加速单元(NPU), 该处理器采用 ArmCortex-M55双核架构。

Arm Ethos-U55 嵌入式神经网络处理器(NPU)

嵌入式神经网络处理器(NPU)是一种特别设计用于执行神经网络计算的高效率处理器。它主要基于数据驱动并行计算架构,特别擅长处理视频、图像等大量的多媒体数据。NPU模仿了生物神经网络的架构,与CPU、GPU相比,它能够通过更少的指令(一条或几条)完成神经元的处理,因此在深度学习的处理效率方面具有明显优势。

它具有标准的CSI接口, 并与树莓派相机兼容。它有一个内置的数字麦克风和SD卡插槽。它非常适用于各种嵌入式视觉项目。

有了SenseCraft Al算法平台, 经过训练的ML模型可以部署到传感器, 而不需要编码。它兼容XIAO系列和Arduino生态系统, 是各种物体检测应用的理想选择。

主要硬件配置

- 板卡基于WiseEye2 HX6538处理器, 采用双核ARM Cortex-M55架构

- 配备集成Arm Ethos-U55嵌入式神经网络处理器(NPU), 兼容的树莓派相机

- 板载PDM麦克风, SD卡插槽, Type-C, Grove接口, 丰富的外设支持样机开发

- Seeed Studio XIAO的可扩展性, SenseCraft Al的现成AI模型用于无代码部署。

- 支持各种有效的模型, 包括MobilenetV1、MobilenetV2、 Eficientnet-Lite、Yolov5和Yolov8.

写在最后

SenseCraft-AI平台的模型仓数量还很少,但是好消息是它支持自定义模型上传并输出推理结果,平台会逐渐增加模型仓的数量和分享爱好者设计的模型仓原型,敬请关注!

-

人工智能

+关注

关注

1791文章

47182浏览量

238187 -

模型

+关注

关注

1文章

3226浏览量

48804 -

目标检测

+关注

关注

0文章

209浏览量

15605 -

ChatGPT

+关注

关注

29文章

1558浏览量

7589

原文标题:模型案例:| 花卉分类识别模型!

文章出处:【微信号:ChaiHuoMakerSpace,微信公众号:柴火创客空间】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

基于隐马尔可夫模型的音频自动分类

【GoKit申请】智能花卉浇水系统

多分类器融合行为识别模型

一种新的目标分类特征深度学习模型

花卉分类识别模型设计

花卉分类识别模型设计

评论