近日,腾讯公司宣布成功推出业界领先的开源MoE(Mixture of Experts,专家混合)大语言模型——Hunyuan-Large。这款模型不仅在参数量上刷新了业界纪录,更在效果上展现出了卓越的性能,标志着腾讯在自然语言处理领域迈出了重要的一步。

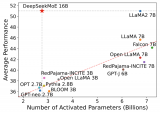

据了解,Hunyuan-Large的总参数量高达389B(即3890亿),这一数字远超当前许多主流的大语言模型。而其激活参数也达到了惊人的52B(即520亿),这意味着模型在处理复杂任务时能够展现出更强的学习能力和泛化性能。

除了参数量上的优势,Hunyuan-Large在训练数据上也下足了功夫。据悉,该模型训练时所使用的token数量达到了7T(即7万亿),这确保了模型能够充分学习到语言的多样性和复杂性。同时,Hunyuan-Large还支持最大上下文长度为256K的文本输入,这一特性使得模型在处理长文本或对话场景时能够更准确地捕捉上下文信息,从而生成更加连贯和自然的回复。

腾讯此次推出的Hunyuan-Large大语言模型,不仅展示了其在人工智能领域的深厚技术积累,也为整个自然语言处理领域的发展注入了新的活力。

-

人工智能

+关注

关注

1791文章

47182浏览量

238200 -

腾讯

+关注

关注

7文章

1652浏览量

49422 -

语言模型

+关注

关注

0文章

520浏览量

10268 -

自然语言

+关注

关注

1文章

287浏览量

13346

发布评论请先 登录

相关推荐

大语言模型开发语言是什么

猎户星空发布Orion-MoE 8×7B大模型及AI数据宝AirDS

昆仑万维开源2千亿稀疏大模型Skywork-MoE

浪潮信息发布“源2.0-M32”开源大模型

腾讯云大模型价格调整:混元-lite、混元-standard免费,混元-pro降价

Mistral Large模型现已在Amazon Bedrock上正式可用

Mistral发布Mistral Large旗舰模型,但没有开源

昆仑万维发布新版MoE大语言模型天工2.0

机器人基于开源的多模态语言视觉大模型

对标OpenAI GPT-4,MiniMax国内首个MoE大语言模型全量上线

腾讯发布开源MoE大语言模型Hunyuan-Large

腾讯发布开源MoE大语言模型Hunyuan-Large

评论