人们对深度学习模型的真正运行机制还远远没有完全了解,如何提高预测模型的“可解释性”成了一个日益重要的话题。近来的一篇论文讨论了机器学习模型的“可解释性”的概念及其重要意义。

7月17日,加州大学圣迭戈分校(UCSD)博士、卡内基梅隆大学(CMU)计算机科学助理教授Zachary C. Lipton在ACM Queue上发表了题为《The Mythos of Model Interpretability》的文章,讨论了监督式机器学习预测模型的可解释性问题。Lipton在文中试图明确“可解释性”的定义,并对“可解释性”进行分类,并提出了一个重要观点,认为线性模型的可解释性并不一定高于深度神经网络(DNN)模型。

以下是新智元对论文内容的简编。

监督式的机器学习模型具有卓越的预测能力。不过,机器学习模型不仅应该可用,而且应该是可解释的,但“解释机器学习模型”的任务定义似乎不够明确。学术文献中提出了为模型寻求可解释性的许多动机,并提供了无数的技术来提供可解释的模型。尽管存在这种模棱两可的情况,但许多作者宣称他们的模型在公理上是可解释的,然而对此却缺乏进一步的论证。问题是,目前尚不清楚这些技术的共同特性是什么。

本文旨在完善关于可解释性的表述。首先,文章回顾了以前论文中解决可解释性的目标,发现这些目标多种多样,偶尔还有相互矛盾。接着讨论了研究可解释性的模型属性和技术思路,以及模型对人而言的识别透明度,并引入了“事后可解释性”的概念作为对比。文章讨论了关于模型可解释性概念的不同观点的可行性和合理之处,对“线性模型可解释,深度神经网络不可解释”这一常见的观点提出了质疑。

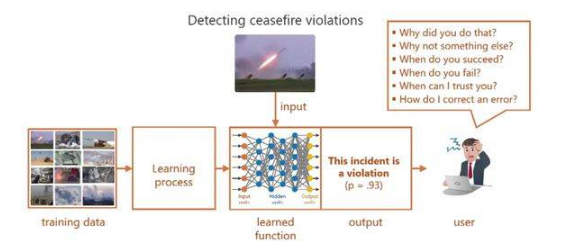

在过去的20年中,机器学习的快速发展产生了自动决策。在实际应用中,大多数基于机器学习的决策的运作方式是这样的:用输入数据训练机器学习算法,然后由算法预测相应的输出。例如,给定一组关于金融交易的属性信息,机器学习算法可以预测长期的投资回报。给定来自CT扫描的图像,算法可以该图像的扫描对象罹患癌性肿瘤的概率。

机器学习算法接收大量成对数据(输入和输出),然后输出一个模型,能够预测之前未见过的输入。研究人员将这个模式称为“监督式学习”。然后,为了让决策过程完全自动化,可以将模型的输出提供给某个决策规则。例如,垃圾邮件过滤器可以通过程序舍弃被预测为垃圾邮件(置信度超过某阈值)的电邮。

什么是可解释性,它为什么如此重要?

目前机器学习在医学、刑事司法系统和金融市场等关键领域的应用越来越广泛,但人类无法真正理解这些模型,这是个问题。一些人提出了模型的“可解释性”作为一种补救措施,但在学术文献中,很少有作者准确地阐明了“可解释性”的含义,也没有准确解释他们提出的解决方案为何是有用的。

尽管缺乏定义,但越来越多的文献提出了据称可解释的算法。这样来看我们似乎可以得出以下结论:要么是(1)人们对可解释性的定义是普遍认同的,但没人愿意费心以书面表达出来,要么就是(2)对“可解释性”的定义是不明确的,所以关于机器学习模型的可解释性的观点都显得科学性不足。对相关文献的研究表明,后者与实际情况相符合。关于模型可解释性的文献中提出的目标和方法多种多样,这表明可解释性不是一个单一概念,而是一些彼此迥然不同的观点,有必要将这些观点分开来讨论。

本文侧重讨论监督式学习,而非强化学习和互动学习等其他机器学习范式。这是因为当前在实际应用中,监督式学习居于首要地位。同时给出了对“线性模型可解释,而深层神经网络不可解释”这个常见观点的分析。首先需要明确的是,什么是可解释性?可解释性为什么如此重要?

许多人提出,可解释性就是对模型产生信任的方式。这又导致了另一个关于认识论的问题:什么是信任?是指对模型能够表现良好的信心吗?还是说“可解释性”只是意味着对模型的低层级机制的理解?信任是否是一种主观的定义?

还有人认为,可解释的模型就是可取的,因为它可能有助于揭示观察数据中的因果结构。而关于解释权的法律概念为可解释性一词提供了另一个视角。有时,寻求可解释性的目的,可能只是为了从模型中获取更多有用的信息。

本文讨论了模型的哪些属性可以让它们变得可解释。有些论文将可解释性与可理解性或可理解性等同起来,在这些论文中,可理解的模型有时被称为“透明”的,而难以理解的模型被称为黑盒子。但是透明度是什么?算法本身会收敛吗?有唯一解吗?人们是否了解每个参数代表什么?或者考虑模型的复杂性:是否足够简单?

其他内容包括“事后可解释”的概念。这种解释可能解释了预测结果,但没有阐明预测模型运作的机制。比如由人类生成的口头解释,或者用于分析深度神经网络的显著性图。因此,人类做出的决定可能会满足“事后可解释”,不过人类大脑的运作机制仍是个黑盒子,这表明两种常见的可解释性概念之间的矛盾。

本论文的作者Zachary C. Lipton

线性模型和深度网络模型的取舍

可解释性的概念很重要、也很棘手。本文分析了可解释性的动机和研究界提出的一些尝试。现在让我们考虑一下这种分析的含义并提供一些内容。

线性模型并不比深度神经网络具有更高的可解释性。尽管这种说法很流行,但其真实价值取决于采用哪种可解释性的概念。如果可解释性指的是算法透明度,那么这种说法似乎没有什么争议,但对高维特征或经大幅修正的特征而言,线性模型就分别不具备可模拟性和可分解性。

在线性模型和深度模型之间进行选择时,我们时常要在算法透明度和可分解性之间进行权衡。这是因为深度神经网络模型一般面向原始特征或轻度处理的特征。所以如果不出意外,这些特征都具有直观的意义,因而采用“事后可解释性”的概念是可以接受的。而线性模型则不同,为了获得足够的性能,通常必须面向大量经人工设计的特征。Zachary Lipton曾与他人合作撰文指出,线性模型要想接近递归神经网络(RNN)的性能,就必须以舍弃可分解性为代价。

如果考察某些类型的“事后可解释性”(post-hoc interpretable),深度神经网络具有明显的优势。深度神经网络能够学习丰富的表示,这些表示能够可视化、用语言表达或用于聚类。如果考虑对可解释性的需求,似乎线性模型在研究自然世界上的表现更好,但这似乎没有理论上的原因。

关于可解释性的声明必须是合格的。可解释性一词并没有一个整体概念。关于可解释性的任何观点都应该首先为“可解释性”确定一个特定的定义。如果模型满足透明度的形式,则可解释性可以直接体现出来。对于“事后可解释性”,则应确定一个明确的目标,并证明所提供的解释形式能够实现这一目标。

事后解释可能会有误导性。不能一味接受“事后可解释”的概念,特别是在基于主观目标对模型做特定优化时。因为在这种情况下,人们可能会在有意无意间优化算法,以提供误导性、但貌似合理的解释。就像在招聘活动和大学录取中的一些行为一样。我们在努力推广机器学习模型的应用,模仿人类智能的过程中,更应该小心不要重现大规模的不正常行为。

未来方向

未来有几个有前途的方向。首先,对于某些问题,可以开发更丰富的损失函数和性能指标,降低现实与机器学习目标之间的差异。包括对稀疏诱导正则化因子(sparsity-inducing regularizers)和成本敏感学习(cost-sensitive learning)的研究。其次,这种分析可以扩展到其他机器学习范式中,比如强化学习。强化学习模型可通过直接对模型与环境的交互进行建模,从而解决模型可解释性研究中的一些问题。

值得注意的是,强化学习模型能够学习自身行为与现实世界的影响之间的因果关系。然而,与监督式学习一样,强化学习同样依赖于明确定义的标量目标。对于公平性(fairness)问题,这个我们正在努力精确定义的指标,机器学习范式可解释度的提升则不大可能解决。

观点争鸣

不过,关于这个问题也有人提出了一些异议,谷歌大脑软件工程师、斯坦福大学计算机科学硕士Akshay Agrawal就对Lipton论文中的主要观点进行了归纳,并提出了不少不同意见。

对此文提出不同意见的Akshay Agrawal

Agrawal认为Lipton的论文对模型可解释性的定义分为三个方面:

第一是透明度,其表现形式是“可vwin 性”,即人类应该可以手动模拟机器学习模型。第二是“可分解性”,即模型的每个部分都有直观的解释。第三是算法,算法应该有独一无二的解。

Agrawal认为:第一点有些问题,因为计算机的目的是自动完成人类在合理的时间内无法完成的任务。第二点讲得很好。第三点也有问题,因为即使在凸面上甚至都不能保证有唯一解。而算法的确定性问题已经不属于机器学习的范围。

Agrawal表示,在可解释性问题上,重要问题的有两点:

1. 这个模型是否能推广用在未见过的数据上面?如果在对某个推广假设试图证伪之后,该假设仍然成立,那么这个模型就是可解释的。我认为这与Lipton在此文中说的“可转移性”的概念差不多。

2. 该模型是否足够安全,比如是否能够防止欺骗?确定模型的安全性是一个悬而未决的问题。也许可以通过使用Lipton在他的论文中调查的一些工具来研究这个问题。不过我很清楚,验证神经网络模型的安全性要比对线性模型进行验证要困难得多。

- 神经网络

+关注

关注

42文章

4716浏览量

99810 - 机器学习

+关注

关注

66文章

8295浏览量

131699

原文标题:线性模型可解释一定比DNN高?UCSD科学家:大错特错!

文章出处:【微信号:AI_era,微信公众号:新智元】欢迎添加关注!文章转载请注明出处。

发布评论请先登录

相关推荐

什么是“可解释的”?可解释性AI不能解释什么

Explainable AI旨在提高机器学习模型的可解释性

机器学习模型可解释性的介绍

使用RAPIDS加速实现SHAP的模型可解释性

文献综述:确保人工智能可解释性和可信度的来源记录

机器学习模型的“可解释性”的概念及其重要意义

机器学习模型的“可解释性”的概念及其重要意义

评论