编者按:如今,社交网络将全球各地的人们紧密联系在了一起,虽然这确实带来了极大的便利,但它也成了不良信息的发育土壤,比如散布黄图。月前,Facebook曾向用户征集裸照,用于训练模型以屏蔽和用户相关的不雅照片,此举引发巨大社会反响。而近期,巴西名校里约热内卢天主教大学的几位研究人员开发了一个自动给裸露人体穿上比基尼的模型:把别人脱下的衣服,一件件穿了回去。

现在,借助互联网的可访问性和信息的广泛传播性,人们获取各种内容的简易程度堪称前所未有。虽然这带来了不少好处,但也暴露了一个事实——部分用户的隐私信息正在被大肆传播,比如个人不雅照。

当然,我们不排除社交网络上存在愿意暴露自己身体的网友,但在缺乏管制和约束的环境下,一些未经本人同意,甚至本人都不知道的图像也会出现在网络中,给当事人造成恶劣影响。虽然各国成人信息监管由来已久,但这些审查工作至今都还是简单的二元分类:“忽略”,还是“不忽略”?在这种情况下,受害者的权益没法得到保障。

更有甚者,据澳大利亚伯内特的一项统计显示,92.2%的受访男孩和62.1%的受访女孩在18岁以前就已经在网上接触过色情内容,首次接触的中位年龄只有14岁。这些流传于社交网络的不良信息正在荼毒我们的下一代,而审查机制不合理(全年龄环境下)是一个主因。

在这篇论文中,研究人员介绍了一种新的成人信息审查方法:用自动过滤敏感内容取代检测、排除已识别内容。他们开发了一种基于GAN的图到图转换方法,可以检测出图片中的敏感区域,在覆盖它们的同时保留其语义。

简单来讲,就是用穿衣服取代打马赛克,模型不用学会识别什么是胸部,什么是臀部,它只需要学会判断哪里是敏感部位,只要这些部位是裸的,它就可以生成符合形状的布料。

具体方法

因为目标是把裸女转成穿着比基尼女郎,首先,研究人员从网上抓取了两类图像:***女性(X)和穿着比基尼的女性(Y)。他们对图像进行了过滤,一张脸只保留一张图,这是训练模型所使用的数据集(数据集会公开,但由于双盲评审,链接被隐去)。

在摘要中,他们称即便数据集很小,模型的效果也很理想。所以把数据集进一步分为训练集(90%)和测试集(10%)后,对于图像X,他们有1044张训练图像和117张测试图像;对于图像Y,他们有921张训练图像和103张测试图像。

图像到图像转换是一类经典计算机视觉问题,按照一般方法,研究人员需要对齐训练集图像,让模型学习输入图像和输出图像之间的映射。但在这个问题下找到成对图像基本是不可能的,他们没有那个条件去找一千多个模特专门拍摄。如上图所示,最终他们受Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks这篇论文启发,用对抗训练学习域之间的真实映射。

具体而言,这个框架由两个映射生成器(G:X→Y、F:Y→X)和两个判别器(DX、DY)组成:

生成器G:把真实裸女图像{x}转成比基尼女郎伪图{yˆ};

生成器F:把真实比基尼女郎图像{y}转成裸女伪图{xˆ};

判别器DX:区分裸女真图{x}和裸女伪图{F (y)} = {xˆ};

判别器DY:区分比基尼女郎真图{y}和比基尼女郎伪图{yˆ}。

训练完成后,生成器就能生成能骗过判别器的图像,也就是为裸女“穿”上衣服。模型使用的是LSGANs的损失函数,因为它比原始GAN的函数更稳健,具体细节论文中有明确写明,此处不再介绍。

实验结果

研究人员在实验中测试了不同架构生成器的效果,用的模型分别是ResNet和U-Net,他们也测试了不同深度对判别器的影响。下图是模型在原数据集上的效果:第一行是裸女原图,第二行是ResNet生成器的结果,第三行是U-Net生成器结果。

可以发现,虽然使用U-Net生成器的模型(第三行)为敏感部位打上了“马赛克”,但它们整体上失真严重,不能被视为“比基尼”。而使用ResNet生成器的模型效果更好,比基尼更美观,覆盖范围也更准确,图像质量更高。

在训练过程中,研究人员发现模型有时会试图在图像主体(人)和图像背景间建立联系,这显然是误入歧途。因此他们用Mask R-CNN截取任务轮廓,制作了一个空白背景数据集重新训练模型。从理论上来讲,通过使用“无背景”图像,神经网络可以更专注于当前任务,而不受嘈杂的背景影响。

如上图所示,无背景下,两个模型的结果比之前好了一点,但相比U-Net生成器,ResNet生成器还是显示出了明显的优势。此外,他们还对模型的稳健性进行了测试:输入一张比基尼女郎图后,生成器F输出了和原图非常相近的图像,并没有做太多更改——这意味着模型在没有胸部、臀部语义认知的情况下,真正学会了识别敏感区域。

小结

看罢全文,相信有读者会提出质疑:近几年学界发表了不少去马赛克的成果,这种技术和打马赛克又有多大区别?

总的来说,区别还是很明显的,至少比基尼女郎比马赛克更美观,从某种程度上来说也更少儿皆宜。再者说,不用考虑超分辨率去马赛克,整个模型是一体的,既然生成器G可以生成逼真比基尼女郎图像,同理,生成器F也能把比基尼给“脱”了,这在论文中有图文介绍,所以想还原不是没有办法。

但需要注意的是,这种技术的本意是改进现有成人信息审查机制,让更多不该看到这类信息的人没有机会接触不良信息,尤其是青少年和儿童。这也保护了不雅照泄露者的权益,避免网络传播给他们造成二次伤害。从根本上说,它无法真正制止犯罪和侵权,但它能反映一种进步。

如果要说缺点,除了图像质量不高,论文作者给的图像测试也不具典型性,因为侵权图像涉及大量偷拍内容,而论文中的裸女照片都像模特摆拍,因此数据集还有待扩充。此外,数据集中也应该增加男性内容。

-

图像

+关注

关注

2文章

1083浏览量

40449 -

GaN

+关注

关注

19文章

1933浏览量

73278 -

数据集

+关注

关注

4文章

1208浏览量

24688

原文标题:用GAN过滤图像敏感区域:为裸女“穿”上比基尼

文章出处:【微信号:jqr_AI,微信公众号:论智】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

基于Qualcomm FastCv的边缘检测算法详解

请问LABVIEW是否可以绘制如附件图片中所示的矢量强度图

一种先分割后分类的两阶段同步端到端缺陷检测方法

GaN HEMT可靠性测试:为什么业界无法就一种测试标准达成共识

一种基于Haar小波变换的彩色图像人脸检测方法

bmp图片转换为PCB图的软件

一种基于图像处理的双目视觉校准方法

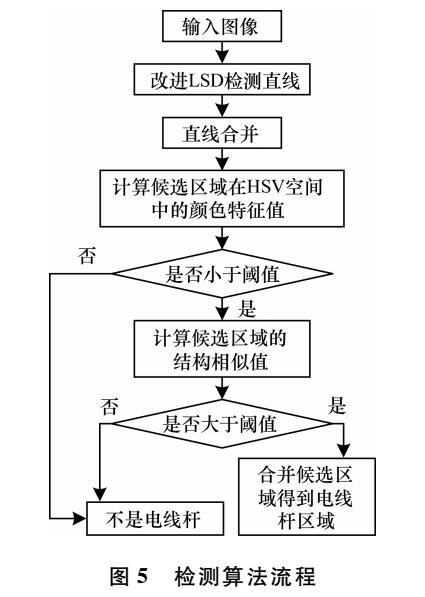

一种改进的线段分割检测算法

一种基于GAN的图到图转换方法,可以检测出图片中的敏感区域

一种基于GAN的图到图转换方法,可以检测出图片中的敏感区域

评论