自动语言翻译是NLP领域研究的一大热门,它可以免去语言不通的烦恼,让用户随意浏览信息、接受服务。为了保证质量,现有的机器翻译系统需要用大量的翻译文本做训练样本。这样就使得机器翻译只有在一小部分样本数量充足的语言表现良好。

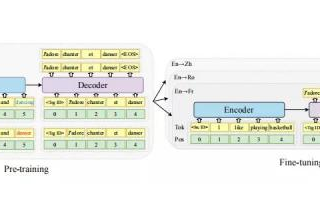

这一领域目前研究的重点就是在不需要任何源翻译的情况下训练机器翻译模型,即无监督训练。Facebook的研究团队在EMNLP 2018上展示的研究成果正式最近针对这一问题的研究,并获得了EMNLP 2018的最佳论文,论智将大概内容编译如下:

我们的新方法在此前无监督翻译的基础上得到了极大地提升,并且达到了和有将近10万份翻译参考样本的监督式方法的水平。BLEU分数是衡量机器翻译准确性常用的准则,提高1分就已经很有说服力了,而我们的方法最终提升了10个BLEU分数。

总的来说,这是机器翻译领域的重要研究成果,尤其是对世界上数千种缺乏样本的小众语言来说,是非常有用的。对资源较少的语言,现在有一种方法能学习彼此间互相翻译了,例如乌尔都语和英语之间的翻译,只需要一段英语和与之无关的乌尔都语即可互译,无需对应的文本。

这一新方法开启了多种语言快速翻译、精准翻译的大门。

词对词翻译

为了达到我们的研究目的,第一步就是让系统学习双语词典,也就是将一个单词和目标语言中的翻译版本联系起来。为了做到这一点,我们用了此前论文中的方法,让系统首先学习各种语言中每个单词的词嵌入(单词的向量表示)。

词嵌入经过训练,是为了根据语境预测单词(例如给定一个单词,猜测前面五个单词和后面五个单词分别是什么)。虽然这一过程简单,但词嵌入可以捕捉有趣的予以结构。例如,“kitty”的最近邻单词是“cat”,并且单词“kitty”的词嵌入与“animal”的嵌入比与“rocket”更近(因为“rocket”几乎很少在由“kitty”的语境中出现)。

并且,不同语言的词嵌入的近邻结构是相似的,因为世界各地的人们对事物的认知是一样的。例如在英语中,“cat”和“fluffy”的关系和西班牙语中的“gato”和“peludo”的关系是一样的,因为这些词出现的语境相似。

基于这种相似性,我们提出让系统学习某种语言词嵌入的旋转,用多种技术的结合,例如对抗训练,来匹配另一种语言的词嵌入。有了这一信息,我们可以不用任何翻译来推断出相当准确的双语词典,进行词对词的翻译。

两种语言的二维词嵌入(左)可以通过简单的旋转连接起来(右)

翻译语句

用无监督的双语词典推断法进行词对词翻译并不是好的翻译方法,因为词语可能会丢失,或打乱顺序,或出现错误。但是,它能最大程度地保留文本的意思。我们可以用语言模型对其进行本地化编辑,该模型经过单一语言数据的训练,可以对词语的顺序进行打分。

如果我们有一个大型的乌尔都语数据集,就可以训练一个乌尔都语模型和同样的英语模型。有了语言模型和词对词翻译,我们可以建立起翻译系统的早期版本。

虽然这一版本还不够完美,但是该系统已经比单纯的词对词翻译要好了,并且可以从很多源语言翻译成目标语言。

接下来,我们将这些系统翻译(从乌尔都语翻译成英语)看作是标准数据,反过来用它们训练机器翻译系统(从英语翻译成乌尔都语)。可以想到,作为输入的英语语句可能会有些许遗漏,因为在第一次翻译时会有误差。这一技术由R. Sennrich等人于ACL 2015上提出,是机器翻译系统的半监督学习(其中可使用少量平行文本)。这是该技术第一次用于完全的无监督系统中,重要的是,它最初是在监督数据上训练的。

我们现在有了乌尔都语语言模型了,我们可以将反向翻译的平行语句和乌尔都语语言模型生成的正确语句相结合,训练从英语到乌尔都语的翻译系统。

系统训练完成后,我们可以用它翻译很多英语语句,建造起另一个数据集,帮助之前的乌尔都语-英语翻译系统提高性能。一个系统变得更好,就可以用它生成用于训练反向系统的数据,不断进行迭代。

模型结合

在我们的研究中,我们设立了三个步骤:

词对词翻译初始化

语言建模

反向翻译

这三个步骤是无监督机器翻译的重要原则,有了这些原则,我们可以衍生出不同的模型,我们将这些原则应用于两种不同的方法处理无监督机器翻译问题。

首先是无监督神经模型,比词对词翻译更流畅,但是无法生成我们想要的翻译质量。但是它们可以用于反向翻译,在反向翻译中,这种方法被看作有10万条平行句子的监督式模型。

接下来,我们将上述三原则应用于另一个基于经典数据模型的方法,即基于短语的机器翻译。这些模型在小众语言上表现得较好,非常有趣。但是这是首次应用于无监督机器翻译上,在这种情况下,我们发现翻译结果中,词语的使用是正确的,但不够流畅。不过这一方法同样比此前的无监督模型表现得要好。

最后,我们将这两种模型结合得到了最好的模型,既能流畅生成语句,又能翻译无误。我们首先训练了神经模型,然后通过基于短语的模型,用额外的反向翻译语句对其进行训练。

重要的是,这种复合型模型极大地提高了吴建德机器翻译的精确度,在英语-法语和英语-德语翻译上提高了10个BLEU分数,这两种翻译常被用作基准。

我们同样在其他语言互译上测试了这种新方法,例如在英语-罗马尼亚语、英语-乌尔都语这样小众的翻译,结果都比之前有很大的进步,甚至有些超过了用平行数据训练处的监督式方法。

德语-英语翻译案例的结果如下:

结语

提高10个BLEU对我们来说是很大的惊喜了,然而更值得关注的是未来机器翻译进步的空间。在短期内,技术的进步一定会让更多语言翻译变得更加容易、翻译质量更好。但这次的研究成果和基本研究准则不会仅仅用于机器翻译。在其他无监督学习领域,此次研究的成果也可让智能体利用无标记数据执行多种任务。这次的研究证明了,系统可以在无监督的情况下学习,并搭建多种系统,其中的元素会在多次迭代中提高性能。

-

机器翻译

+关注

关注

0文章

139浏览量

14880 -

数据集

+关注

关注

4文章

1208浏览量

24689

原文标题:EMNLP 2018最佳论文 | Facebook提出二合一无监督机器翻译,BLEU分数提高10个点

文章出处:【微信号:jqr_AI,微信公众号:论智】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

LabVIEW做百度翻译助手

语言翻译技术一流的智能翻译机-讯飞翻译机3.0

基于浅层句法信息的翻译实例获取方法研究

利用C语言和GEL语言的Flash编程新方法

日本AI翻译耳机可精准翻译三国语言 精准率达90%

一众科技厂商竞相推出“翻译蛋”“翻译机”等各色智能翻译设备

关于roobo联手中译语通对人工智能翻译时代的分析和介绍

阿里宣布完成全球首个多语言实时翻译的电商直播

Facebook的AI翻译系统能翻译100种语言!

多语言翻译新范式的工作:机器翻译界的BERT

专业中英文翻译机推荐:讯飞双屏翻译机打破语言障碍

智能翻译机就选讯飞双屏翻译机,83种语言在线即时翻译供你选

新方法开启了多种语言快速翻译、精准翻译的大门

新方法开启了多种语言快速翻译、精准翻译的大门

评论